Python爬虫技术 第27节 API和RESTful服务

Python 爬虫技术是一种自动化获取网页内容的方法,通常用于数据收集、信息抽取或自动化测试。在讲解 Python 爬虫技术时,我们通常会涉及到以下几个关键概念:

-

HTTP 请求:爬虫通过发送 HTTP 请求来获取网页内容,这是爬虫与服务器交互的基础。

-

API:API(Application Programming Interface)是应用程序编程接口,它允许不同的软件应用之间进行交互。API 通常定义了一组规则和协议,使得不同的系统能够通过 HTTP 请求和响应进行数据交换。

-

RESTful 服务:RESTful 是一种基于 HTTP 协议的网络服务架构风格,它使用标准的 HTTP 方法(如 GET、POST、PUT、DELETE 等)来操作网络上的资源。RESTful 服务通常易于使用和扩展,因为它们遵循统一的接口。

Python 爬虫技术详解

-

请求网页:使用 Python 的

requests库来发送 HTTP 请求,获取网页的 HTML 或 JSON 数据。import requests response = requests.get('http://example.com') -

解析内容:使用

BeautifulSoup或lxml等库来解析 HTML 或 XML 内容,提取所需的数据。from bs4 import BeautifulSoup soup = BeautifulSoup(response.text, 'html.parser') -

数据存储:将提取的数据存储到数据库或文件中,以便进一步分析或使用。

# 假设提取的数据是一个列表 data = [item.text for item in soup.find_all('li')] -

处理 API:如果目标网站提供了 API,可以通过 API 直接获取数据,这通常比直接爬取网页更高效、更稳定。

api_response = requests.get('http://api.example.com/data') -

遵守规则:在使用爬虫技术时,需要遵守目标网站的

robots.txt文件规定,尊重版权和隐私政策。 -

异常处理:编写代码时,需要考虑到网络请求可能失败的情况,并进行相应的异常处理。

try:response = requests.get('http://example.com')response.raise_for_status() # 检查请求是否成功 except requests.exceptions.HTTPError as err:print(f"HTTP error occurred: {err}") -

使用会话:对于需要多次请求同一服务器的情况,使用

requests.Session()可以提高效率。 -

模拟浏览器:有时网站可能需要用户代理(User-Agent)或其他浏览器特性,可以通过设置请求头来模拟浏览器行为。

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3' } response = requests.get('http://example.com', headers=headers) -

使用代理:在爬取过程中可能会遇到 IP 被封的情况,使用代理可以绕过这些限制。

-

异步请求:对于需要发送大量请求的情况,可以使用

aiohttp等异步库来提高效率。

RESTful 服务的使用

-

理解资源:RESTful 服务通常将数据表示为资源,每个资源都有一个唯一的标识符(URI)。

-

使用 HTTP 方法:根据需要执行的操作(如获取、创建、更新、删除)选择相应的 HTTP 方法。

# 获取资源 response = requests.get('http://api.example.com/resource') # 创建资源 response = requests.post('http://api.example.com/resource', json=data) # 更新资源 response = requests.put('http://api.example.com/resource/1', json=data) # 删除资源 response = requests.delete('http://api.example.com/resource/1') -

处理状态码:理解并处理不同的 HTTP 状态码,例如 200 表示成功,404 表示未找到,500 表示服务器错误等。

-

使用 JSON:RESTful 服务通常使用 JSON 作为数据交换格式,需要熟悉如何发送和解析 JSON 数据。

-

认证和授权:如果 RESTful 服务需要认证,可能需要在请求中包含认证信息,如 OAuth 令牌。

-

错误处理:正确处理 API 调用中可能出现的错误,如网络错误、数据格式错误等。

通过上述步骤,你可以构建一个基本的 Python 爬虫,或者使用 RESTful 服务来获取和操作数据。记住,爬虫的使用应遵守法律法规和网站的使用条款。

让我们通过一个具体的案例来讲解 Python 爬虫技术的应用,以及如何使用 RESTful API 服务。

案例:爬取在线商店的商品信息

假设我们想要爬取一个在线商店的商品信息,包括商品名称、价格、库存状态等。

步骤 1: 确定数据来源

首先,我们需要确定数据来源。如果商店提供了 API,我们应优先使用 API,因为它通常更稳定、更快速,并且可以减少对网站服务器的压力。

步骤 2: 注册 API 并获取密钥

许多 API 服务需要注册并获取一个 API 密钥(API Key),以验证请求的合法性。

步骤 3: 阅读 API 文档

阅读 API 提供的文档,了解如何构造请求,包括基本的 URL、支持的 HTTP 方法、请求参数、认证方式等。

步骤 4: 使用 Python 发送请求

使用 requests 库构造请求并获取数据。

import requestsapi_url = 'https://api.examplestore.com/products'

api_key = 'your_api_key_here'

headers = {'Authorization': f'Bearer {api_key}','Content-Type': 'application/json'

}# 发送 GET 请求获取商品列表

response = requests.get(api_url, headers=headers)

products = response.json()

步骤 5: 解析数据

解析返回的 JSON 数据,提取所需的商品信息。

for product in products['data']:print(f"Product Name: {product['name']}")print(f"Price: {product['price']}")print(f"In Stock: {product['in_stock']}")print("-" * 30)

步骤 6: 存储数据

将提取的数据存储到适当的格式或数据库中。

import csv# 将数据写入 CSV 文件

with open('products.csv', 'w', newline='', encoding='utf-8') as file:writer = csv.writer(file)writer.writerow(['Product Name', 'Price', 'In Stock'])for product in products['data']:writer.writerow([product['name'], product['price'], product['in_stock']])

步骤 7: 处理分页

如果 API 支持分页,需要处理分页以获取所有数据。

page = 1

while True:params = {'page': page}response = requests.get(api_url, headers=headers, params=params)page_data = response.json()if not page_data['data']:breakfor product in page_data['data']:print(f"Product Name: {product['name']}")page += 1

步骤 8: 异常处理

添加异常处理逻辑,确保程序的健壮性。

try:response = requests.get(api_url, headers=headers)response.raise_for_status() # 检查请求是否成功

except requests.exceptions.HTTPError as err:print(f"HTTP error occurred: {err}")

except requests.exceptions.RequestException as e:print(f"Error during requests to {api_url}: {e}")

步骤 9: 遵守爬虫礼仪

确保你的爬虫遵守 robots.txt 规则,不要发送请求过于频繁,以免对服务器造成过大压力。

步骤 10: 使用代理和用户代理

如果遇到 IP 被封的情况,可以使用代理和更改用户代理。

proxies = {'http': 'http://10.10.1.10:3128','https': 'http://10.10.1.10:1080',

}

headers['User-Agent'] = 'Your Custom User Agent'

通过这个案例,你可以看到 Python 爬虫技术的实际应用,以及如何与 RESTful API 服务交互。记住,实际应用中还需要考虑更多的细节,如请求频率控制、数据的进一步清洗和分析等。

好的,让我们继续优化上述案例,使其更加健壮和高效。

优化点 1: 动态处理分页

在处理分页时,我们不仅要考虑循环获取数据,还要考虑 API 的分页参数可能有所不同,以及如何动态地处理分页。

def fetch_all_products(api_url, api_key):headers = {'Authorization': f'Bearer {api_key}','Content-Type': 'application/json'}params = {}products = []while True:response = requests.get(api_url, headers=headers, params=params)page_data = response.json()if not page_data['data']:breakproducts.extend(page_data['data'])# 动态检查API的分页参数,可能是'page'或'offset'if 'next_page' in page_data:params = {'page': page_data['next_page']}elif 'next_offset' in page_data:params['offset'] = page_data['next_offset']else:breakreturn products# 使用函数

api_key = 'your_api_key_here'

all_products = fetch_all_products(api_url, api_key)

优化点 2: 异步请求

如果 API 允许并发请求,使用异步请求可以显著提高数据获取的效率。

import asyncio

import aiohttpasync def fetch_product(session, url, headers):async with session.get(url, headers=headers) as response:return await response.json()async def fetch_all_products_async(api_url, api_key):headers = {'Authorization': f'Bearer {api_key}','Content-Type': 'application/json'}tasks = []products = []page = 1while True:url = f"{api_url}?page={page}"task = fetch_product(aiohttp.ClientSession(), url, headers)tasks.append(task)if len(tasks) >= 5: # 限制同时进行的请求数量responses = await asyncio.gather(*tasks)products.extend([resp['data'] for resp in responses])tasks.clear()if not tasks: # 检查是否还有下一页breakpage += 1return products# 使用异步函数

api_key = 'your_api_key_here'

loop = asyncio.get_event_loop()

all_products_async = loop.run_until_complete(fetch_all_products_async(api_url, api_key))

优化点 3: 错误重试机制

在网络请求中,引入错误重试机制可以提高爬虫的稳定性。

from requests.adapters import HTTPAdapter

from requests.packages.urllib3.util.retry import Retrydef requests_retry_session(retries=3,backoff_factor=0.3,status_forcelist=(500, 502, 504),session=None,

):session = session or requests.Session()retry = Retry(total=retries,read=retries,connect=retries,backoff_factor=backoff_factor,status_forcelist=status_forcelist,)adapter = HTTPAdapter(max_retries=retry)session.mount('http://', adapter)session.mount('https://', adapter)return session# 使用带重试的会话

session = requests_retry_session()

response = session.get(api_url, headers=headers)

优化点 4: 日志记录

添加日志记录可以帮助我们更好地监控爬虫的状态和调试问题。

import logginglogging.basicConfig(level=logging.INFO, format='%(asctime)s - %(levelname)s - %(message)s')try:response = session.get(api_url, headers=headers)response.raise_for_status()

except requests.exceptions.HTTPError as err:logging.error(f"HTTP error occurred: {err}")

except requests.exceptions.RequestException as e:logging.error(f"Error during requests to {api_url}: {e}")

优化点 5: 遵守爬虫协议

确保爬虫遵守 robots.txt 文件的规定,并设置合理的请求间隔,避免给网站服务器带来过大压力。

import time

import robotparserrp = robotparser.RobotFileParser()

rp.set_url("http://examplestore.com/robots.txt")

rp.read()if rp.can_fetch("*", api_url): # 检查是否可以爬取API URLresponse = session.get(api_url, headers=headers)

else:logging.warning("Crawling blocked by robots.txt")time.sleep(1) # 休息一段时间再尝试

优化点 6: 数据清洗和验证

在存储数据前,进行数据清洗和验证,确保数据的准确性和一致性。

def clean_data(product):cleaned_product = {}for key, value in product.items():if key in ['name', 'price', 'in_stock']:if key == 'price':cleaned_product[key] = float(value) # 确保价格是数字类型elif key == 'in_stock':cleaned_product[key] = bool(value) # 确保库存是布尔类型else:cleaned_product[key] = value.strip() # 去除字符串两端的空白字符return cleaned_productcleaned_products = [clean_data(product) for product in all_products]

通过这些优化点,我们的爬虫不仅更加健壮和高效,而且更加专业和符合最佳实践。

相关文章:

Python爬虫技术 第27节 API和RESTful服务

Python 爬虫技术是一种自动化获取网页内容的方法,通常用于数据收集、信息抽取或自动化测试。在讲解 Python 爬虫技术时,我们通常会涉及到以下几个关键概念: HTTP 请求:爬虫通过发送 HTTP 请求来获取网页内容,这是爬虫与…...

音视频入门基础:WAV专题(4)——FFmpeg源码中获取WAV文件音频压缩编码格式、采样频率、声道数量、采样位数、码率的实现

音视频入门基础:WAV专题系列文章: 音视频入门基础:WAV专题(1)——使用FFmpeg命令生成WAV音频文件 音视频入门基础:WAV专题(2)——WAV格式简介 音视频入门基础:WAV专题…...

环境变量在Conda中的魔法:控制包安装的秘诀

环境变量在Conda中的魔法:控制包安装的秘诀 Conda不仅是Python和其他语言包的包管理器,它还是一个强大的环境管理器。在使用Conda时,环境变量可以极大地增强其功能,允许用户控制包的安装过程,实现定制化的安装策略。本…...

VS Code C/C++ MSVC编译器

官方教程 通过快捷方式打开VS Code是编译不了的,需要对tasks.json修改(Tasks: Configure default build task) 先创建tasks.json 复制这段配置到tasks.json,记得修改VsDevCmd.bat的路径 {"version": "2.0.0","windows": {"options"…...

【技巧】IDEA 个性化配置

【技巧】IDEA 个性化配置 自动补全 关闭大小写区分 自动导包 插件 Rainbow Brackets 彩色括号 更容易区分是哪个括号...

`pytest` 中一些常用的选项

下面列出的参数和功能涵盖了 pytest 中一些常用的选项,但 pytest 还有许多其他参数和功能。以下是一些补充的 pytest 命令行参数和功能: 其他命令行参数 测试配置 --confcutdir<path>: 只加载指定目录及其子目录中的配置文件。例如 --confcutdirs…...

fme从json中提取位置到kml中

fme从json中提取位置到kml中 简单参考,我自己要用的,越弄越复杂。 概述-模板总体结构 数据就是官方提供的数据,模板的基本节结构是读模块+转换器+写模块,最近爬取一些json文件,用到了。 1.使用json读模块读取数据 首先检查一下源数据 使用文本打开数据集,可以看到非缩…...

在Ubuntu 18.04上安装和配置pgAdmin 4服务器模式的方法

前些天发现了一个巨牛的人工智能学习网站,通俗易懂,风趣幽默,忍不住分享一下给大家。点击跳转到网站。 简介 pgAdmin 是一个针对 PostgreSQL 及其相关数据库管理系统的开源管理和开发平台。它使用 Python 和 jQuery 编写,支持 P…...

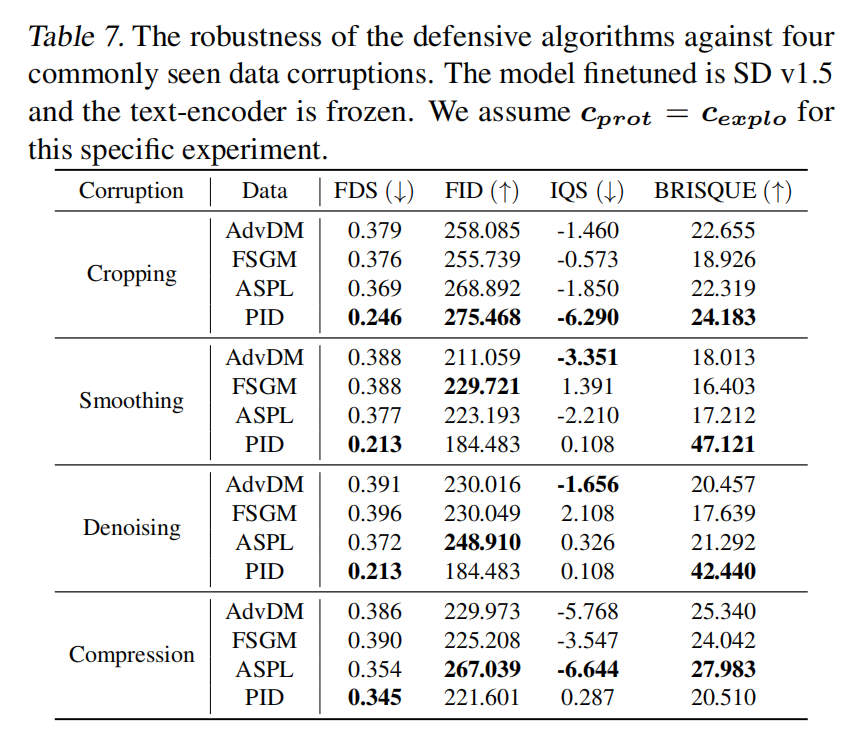

NiFi :1 初识这把“十年一剑”的利器

--->更多内容,请移步“鲁班秘笈”!!<--- “现在AI和数据处理密不可分,80%的企业可以利用Apache NiFi轻松解决复杂的数据问题,快速完成场景建设。犹如花上百来块钱在家享受一顿不亚于五星级西餐厅的法式大餐。对…...

Pyside6实战教程专栏目录

Pyside6实战教程🚀 专栏目录介绍 本专栏将详细地向Python开发者展示如何利用PySide6框架创建功能丰富的桌面应用程序。无论你是刚刚接触GUI编程的新手,还是希望快速提升自己技能水平的进阶用户,本文都将为你提供一系列简单易懂的教程…...

创建图表)

【Dash】使用 Dash Design Kit (DDK) 创建图表

一、Styling Your App The examples in the previous section used Dash HTML Components to build a simple app layout, but you can style your app to look more professional. This section will give a brief overview of the multiple tools that you can use to enhan…...

C++ 几何算法 - 向量点乘,叉乘及其应用

一:点乘介绍 1. 向量点乘: 2. 向量点乘的性质: 3. 向量点乘公式: 4. 向量的点乘的属性: (1):向量与自身做点乘,会得到向量长度的平方: (2…...

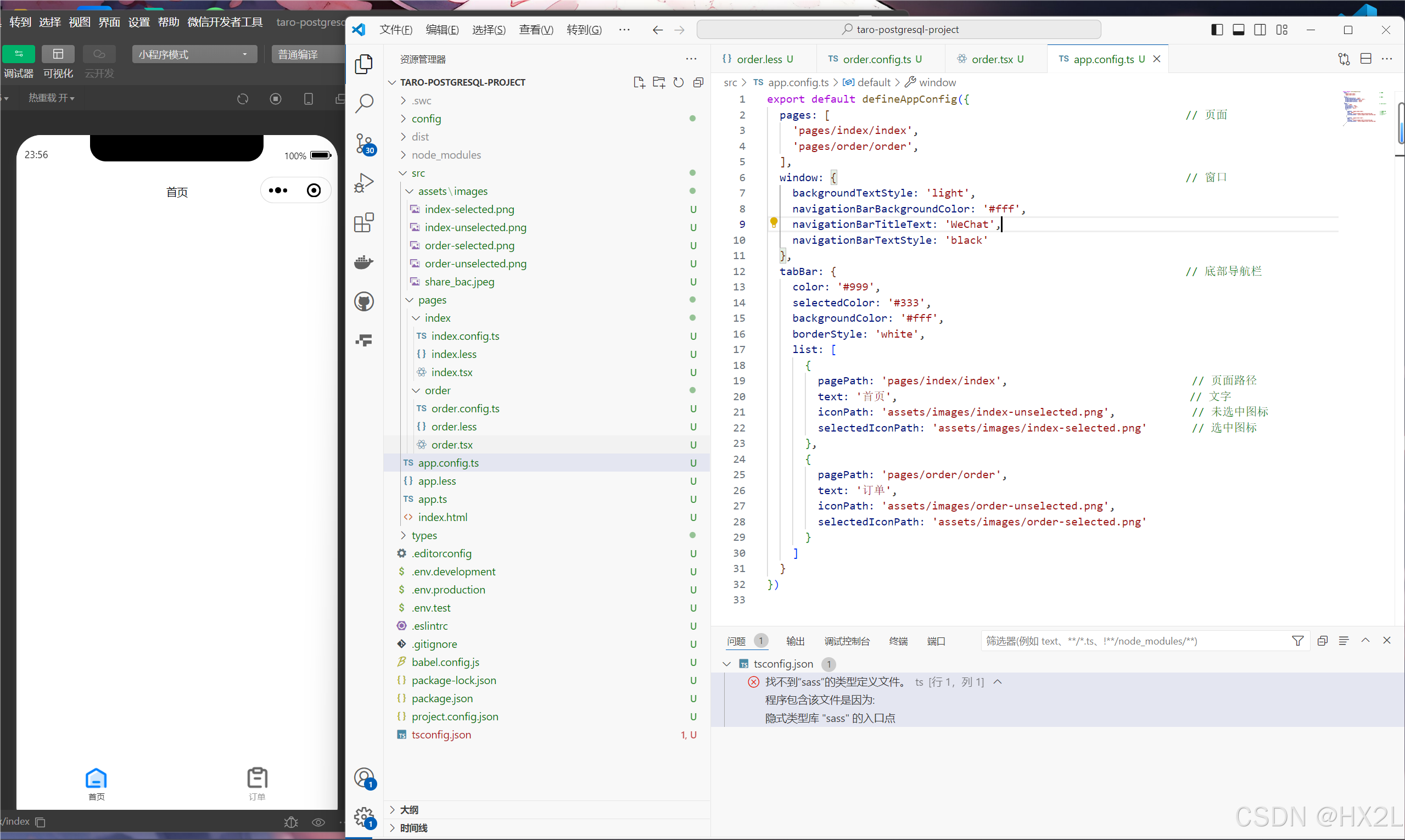

Taro学习记录(具体项目实践)

一、安装taro-cli 二、项目文件 三、项目搭建 1、Eslint配置 在项目生成的 .eslintrc 中进行配置 {"extends": ["taro/react"], //一个配置文件,可以被基础配置中的已启用的规则继承"parser": "babel/eslint-parser…...

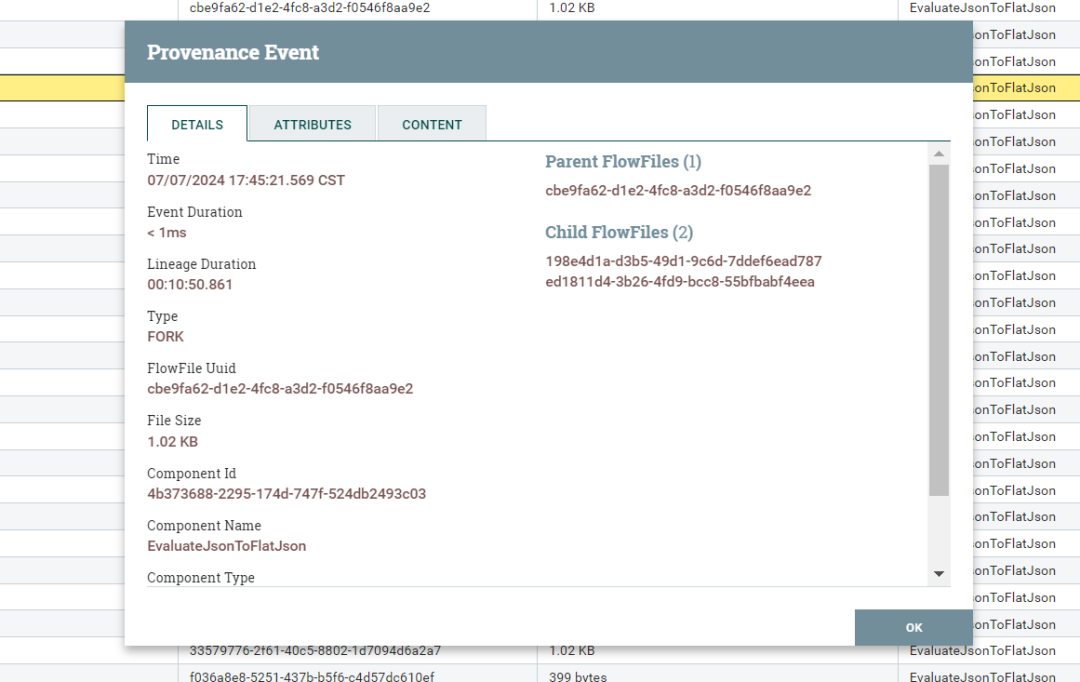

ICML 2024 | 矛与盾的较量!北大提出提示无关数据防御保护算法PID

文章链接:https://arxiv.org/pdf/2406.15305 代码地址:https://github.com/PKU-ML/Diffusion-PID-Protection 亮点直击 本文在实证观察中发现,保护阶段和利用阶段之间的提示不匹配可能会削弱当前数据保护算法的有效性。本文深入探讨了利用LDM…...

Oracle聚合函数LISTAGG和WM_CONCAT简介

目录 Oracle聚合函数LISTAGG和WM_CONCAT简介LISTAGG 函数1.语法2.示例3.去除重复值 WM_CONCAT 函数1.语法2.示例3.去除重复值 比较1.性能2.排序与分隔符3.去除重复值 Oracle聚合函数LISTAGG和WM_CONCAT简介 在处理数据库中的数据聚合任务时,我们经常需要将多行数据…...

【Unity】多种寻路算法实现 —— BFS,DFS,Dijkstra,A*

本实验寻路算法均基于网格实现,整体称呼为Grid,单个瓦片称之为Tile 考虑程序处理的简洁性,所有算法使用同一种Tile,且权值点,A*所需的记录数值也全部放在Tile中记录 前排贴上代码仓库链接: GitHub - Sir…...

十大游戏设计软件:创意实现的利器

在数字娱乐的多彩世界里,游戏设计无疑是一项充满创意与技术挑战的艺术。随着技术的进步,游戏设计师的手中拥有了一系列强大的工具,它们让想象中的世界得以呈现,让玩家的体验更加丰富和真实。本文将带你走进游戏设计的幕后…...

Pandas高级操作:多级索引、窗口函数、数据透视表等

在数据处理和分析中,pandas库提供了强大的功能,支持从简单到复杂的数据操作。本文将介绍一些pandas的高级操作,包括多级索引(MultiIndex)、窗口函数(Window Functions)、数据透视表与复杂聚合、数据合并与连接、高级数据变换以及时间序列数据的高级处理。 1. 多级索引(…...

mysql源码编译启动debug

对于没有C语言基础的同学来说,想看看源码,在搞定编辑器做debug的时候就被劝退了,发生点啥了,完全看不懂,不知道从哪里入手去做debug;我为了看看 mysql 的 insert buffer 到底存的是索引页还是数据页&#x…...

吴恩达机器学习-C1W3L2-逻辑回归之S型函数

可选实验:逻辑回归 在这个不评分的实验中,你会 探索sigmoid函数(也称为logistic函数)探索逻辑回归;哪个用到了s型函数 import numpy as np %matplotlib widget import matplotlib.pyplot as plt from plt_one_addpt_onclick import plt_one_addpt_onclick from l…...

前端倒计时误差!

提示:记录工作中遇到的需求及解决办法 文章目录 前言一、误差从何而来?二、五大解决方案1. 动态校准法(基础版)2. Web Worker 计时3. 服务器时间同步4. Performance API 高精度计时5. 页面可见性API优化三、生产环境最佳实践四、终极解决方案架构前言 前几天听说公司某个项…...

MODBUS TCP转CANopen 技术赋能高效协同作业

在现代工业自动化领域,MODBUS TCP和CANopen两种通讯协议因其稳定性和高效性被广泛应用于各种设备和系统中。而随着科技的不断进步,这两种通讯协议也正在被逐步融合,形成了一种新型的通讯方式——开疆智能MODBUS TCP转CANopen网关KJ-TCPC-CANP…...

高危文件识别的常用算法:原理、应用与企业场景

高危文件识别的常用算法:原理、应用与企业场景 高危文件识别旨在检测可能导致安全威胁的文件,如包含恶意代码、敏感数据或欺诈内容的文档,在企业协同办公环境中(如Teams、Google Workspace)尤为重要。结合大模型技术&…...

MySQL中【正则表达式】用法

MySQL 中正则表达式通过 REGEXP 或 RLIKE 操作符实现(两者等价),用于在 WHERE 子句中进行复杂的字符串模式匹配。以下是核心用法和示例: 一、基础语法 SELECT column_name FROM table_name WHERE column_name REGEXP pattern; …...

C#中的CLR属性、依赖属性与附加属性

CLR属性的主要特征 封装性: 隐藏字段的实现细节 提供对字段的受控访问 访问控制: 可单独设置get/set访问器的可见性 可创建只读或只写属性 计算属性: 可以在getter中执行计算逻辑 不需要直接对应一个字段 验证逻辑: 可以…...

协议转换利器,profinet转ethercat网关的两大派系,各有千秋

随着工业以太网的发展,其高效、便捷、协议开放、易于冗余等诸多优点,被越来越多的工业现场所采用。西门子SIMATIC S7-1200/1500系列PLC集成有Profinet接口,具有实时性、开放性,使用TCP/IP和IT标准,符合基于工业以太网的…...

消防一体化安全管控平台:构建消防“一张图”和APP统一管理

在城市的某个角落,一场突如其来的火灾打破了平静。熊熊烈火迅速蔓延,滚滚浓烟弥漫开来,周围群众的生命财产安全受到严重威胁。就在这千钧一发之际,消防救援队伍迅速行动,而豪越科技消防一体化安全管控平台构建的消防“…...

WEB3全栈开发——面试专业技能点P7前端与链上集成

一、Next.js技术栈 ✅ 概念介绍 Next.js 是一个基于 React 的 服务端渲染(SSR)与静态网站生成(SSG) 框架,由 Vercel 开发。它简化了构建生产级 React 应用的过程,并内置了很多特性: ✅ 文件系…...

若依登录用户名和密码加密

/*** 获取公钥:前端用来密码加密* return*/GetMapping("/getPublicKey")public RSAUtil.RSAKeyPair getPublicKey() {return RSAUtil.rsaKeyPair();}新建RSAUti.Java package com.ruoyi.common.utils;import org.apache.commons.codec.binary.Base64; im…...

多元隐函数 偏导公式

我们来推导隐函数 z z ( x , y ) z z(x, y) zz(x,y) 的偏导公式,给定一个隐函数关系: F ( x , y , z ( x , y ) ) 0 F(x, y, z(x, y)) 0 F(x,y,z(x,y))0 🧠 目标: 求 ∂ z ∂ x \frac{\partial z}{\partial x} ∂x∂z、 …...