YOLOv8-ultralytics-8.2.103部分代码阅读笔记-torch_utils.py

torch_utils.py

ultralytics\utils\torch_utils.py

目录

torch_utils.py

1.所需的库和模块

2.def torch_distributed_zero_first(local_rank: int):

3.def smart_inference_mode():

4.def autocast(enabled: bool, device: str = "cuda"):

5.def get_cpu_info():

6.def select_device(device="", batch=0, newline=False, verbose=True):

7.def time_sync():

8.def fuse_conv_and_bn(conv, bn):

9.def fuse_deconv_and_bn(deconv, bn):

10.def model_info(model, detailed=False, verbose=True, imgsz=640):

11.def get_num_params(model):

12.def get_num_gradients(model):

13.def model_info_for_loggers(trainer):

14.def get_flops(model, imgsz=640):

15.def get_flops_with_torch_profiler(model, imgsz=640):

16.def initialize_weights(model):

17.def scale_img(img, ratio=1.0, same_shape=False, gs=32):

18.def copy_attr(a, b, include=(), exclude=()):

19.def get_latest_opset():

20.def intersect_dicts(da, db, exclude=()):

21.def is_parallel(model):

22.def de_parallel(model):

23.def one_cycle(y1=0.0, y2=1.0, steps=100):

24.def init_seeds(seed=0, deterministic=False):

25.class ModelEMA:

26.def strip_optimizer(f: Union[str, Path] = "best.pt", s: str = "", updates: dict = None) -> dict:

27.def convert_optimizer_state_dict_to_fp16(state_dict):

28.def profile(input, ops, n=10, device=None):

29.class EarlyStopping:

1.所需的库和模块

# Ultralytics YOLO 🚀, AGPL-3.0 licenseimport contextlib

import gc

import math

import os

import random

import time

from contextlib import contextmanager

from copy import deepcopy

from datetime import datetime

from pathlib import Path

from typing import Unionimport numpy as np

import torch

import torch.distributed as dist

import torch.nn as nn

import torch.nn.functional as Ffrom ultralytics.utils import (DEFAULT_CFG_DICT,DEFAULT_CFG_KEYS,LOGGER,NUM_THREADS,PYTHON_VERSION,TORCHVISION_VERSION,WINDOWS,__version__,colorstr,

)

from ultralytics.utils.checks import check_versiontry:import thop

except ImportError:thop = None# Version checks (all default to version>=min_version)

# 这段代码执行了一系列版本检查,以确保 PyTorch 和 torchvision 库的版本满足特定的要求。

# 版本检查。

# 使用 check_version 函数比较 PyTorch 和 torchvision 的当前版本与一系列最小版本。例如, TORCH_1_9 会检查 PyTorch 版本是否至少为 1.9.0。

# def check_version(current: str = "0.0.0", required: str = "0.0.0", name: str = "version", hard: bool = False, verbose: bool = False, msg: str = "",) -> bool:

# -> 用于检查当前安装的软件包版本是否满足特定的要求。返回结果。函数返回 result ,表示当前版本是否满足要求。

# -> return result

TORCH_1_9 = check_version(torch.__version__, "1.9.0")

TORCH_1_13 = check_version(torch.__version__, "1.13.0")

TORCH_2_0 = check_version(torch.__version__, "2.0.0")

TORCH_2_4 = check_version(torch.__version__, "2.4.0")

TORCHVISION_0_10 = check_version(TORCHVISION_VERSION, "0.10.0")

TORCHVISION_0_11 = check_version(TORCHVISION_VERSION, "0.11.0")

TORCHVISION_0_13 = check_version(TORCHVISION_VERSION, "0.13.0")

TORCHVISION_0_18 = check_version(TORCHVISION_VERSION, "0.18.0")

# Windows 特定警告。

# 这个条件检查是否在 Windows 系统上,并且 PyTorch 的版本正好是 2.4.0。

if WINDOWS and check_version(torch.__version__, "==2.4.0"): # reject version 2.4.0 on Windows# 如果条件为真,则使用 LOGGER.warning 记录一条警告信息,建议用户升级 PyTorch 版本以解决已知问题。LOGGER.warning("WARNING ⚠️ Known issue with torch==2.4.0 on Windows with CPU, recommend upgrading to torch>=2.4.1 to resolve " # 警告 ⚠️ 在带有 CPU 的 Windows 上,torch==2.4.0 存在已知问题,建议升级到 torch>=2.4.1 来解决。"https://github.com/ultralytics/ultralytics/issues/15049")

# 这段代码强调了在特定环境下(如 Windows 上的 PyTorch 2.4.0)可能遇到的兼容性问题,并提供了一种机制来通知用户并建议采取行动以避免这些问题。2.def torch_distributed_zero_first(local_rank: int):

# 这段代码定义了一个名为 torch_distributed_zero_first 的上下文管理器(context manager),用于在分布式训练中确保所有进程等待主进程(通常是 rank 0)完成特定任务后再继续执行。

# 函数定义。# @contextlib.contextmanager

# contextlib.contextmanager 是 Python 标准库 contextlib 模块中的一个装饰器,它用于将一个生成器函数转换为上下文管理器。上下文管理器是一种特殊的对象,它允许你定义在代码块执行前后需要运行的代码,通常用于管理资源,如文件操作、锁的获取和释放等。

# 装饰器定义 :

# @contextlib.contextmanager

# def some_context_manager():

# # 在代码块执行前需要执行的代码

# yield # 这表示上下文管理器的入口点

# # 在代码块执行后需要执行的代码

# 函数体 :

# yield 语句之前的代码块在进入 with 语句时执行,这通常用于设置或初始化资源。

# yield 语句之后的代码块在退出 with 语句时执行,这通常用于清理或释放资源。

# 总结 :

# contextlib.contextmanager 装饰器提供了一种简洁的方式来创建上下文管理器,而不需要定义一个类并实现 __enter__ 和 __exit__ 方法。这种方式特别适合于简单的资源管理场景,可以减少模板代码,使代码更加清晰和易于维护。# 使用 @contextmanager 装饰器,表示这是一个上下文管理器,可以在 with 语句中使用。

@contextmanager

# 参数说明。

# 1.local_rank :当前进程的局部排名,通常是在每个节点上分配给进程的唯一标识符。

def torch_distributed_zero_first(local_rank: int):# 确保分布式训练中的所有进程都等待本地主机(等级 0)先完成任务。"""Ensures all processes in distributed training wait for the local master (rank 0) to complete a task first."""# 检查分布式环境是否初始化。检查 PyTorch 的分布式通信模块是否可用并且已经初始化。initialized = dist.is_available() and dist.is_initialized()# 等待主进程。# 如果分布式环境已经初始化,并且当前进程不是主进程( local_rank 不是 0 或 -1,-1 通常表示非分布式环境)。if initialized and local_rank not in {-1, 0}:# 调用 dist.barrier 函数,使当前进程等待,直到所有进程都到达这个 barrier。这确保了所有非主进程都等待主进程完成其任务。dist.barrier(device_ids=[local_rank])# 上下文管理器的主体,允许执行 with 语句块内的代码。yield# 主进程等待其他进程。# 如果分布式环境已经初始化,并且当前进程是主进程( local_rank 是 0)。if initialized and local_rank == 0:# 主进程调用 dist.barrier 函数,等待所有其他进程到达这个 barrier,确保主进程在其他进程继续之前完成其任务。dist.barrier(device_ids=[local_rank])

# 这个上下文管理器非常有用,特别是在需要在分布式训练中同步操作时,例如在打印日志、保存模型或执行评估时。通过确保主进程首先完成,可以避免数据竞争和不一致性问题。3.def smart_inference_mode():

# 这段代码定义了一个名为 smart_inference_mode 的函数,其目的是根据 PyTorch 的版本动态地选择使用 torch.inference_mode() 装饰器或 torch.no_grad() 装饰器。这个函数是一个装饰器工厂,它返回一个装饰器,该装饰器根据 PyTorch 的版本和是否已经启用了推理模式来决定如何装饰函数。

# 函数定义。这个函数不接受任何参数,它返回一个装饰器。

def smart_inference_mode():# 如果 torch>=1.9.0,则应用 torch.inference_mode() 装饰器,否则应用 torch.no_grad() 装饰器。"""Applies torch.inference_mode() decorator if torch>=1.9.0 else torch.no_grad() decorator."""# 内部装饰器定义。# 这是一个内部函数,它接受一个函数 1.fn 作为参数,并返回一个新的函数,该函数根据 PyTorch 的版本和推理模式的状态来决定如何装饰 fn 。def decorate(fn):# 根据 torch 版本为推理模式应用适当的 torch 装饰器。"""Applies appropriate torch decorator for inference mode based on torch version."""# 版本检查和条件逻辑。# torch.is_inference_mode_enabled()# torch.is_inference_mode_enabled() 是 PyTorch 提供的一个函数,用于检查当前是否启用了推理模式(inference mode)。当在推理模式下运行代码时,PyTorch 会禁用梯度计算和某些其他功能,以提高性能。# 返回值 :# 返回一个布尔值( bool ),如果当前启用了推理模式,则返回 True ;否则返回 False 。# 相关背景 :# 从 PyTorch 1.9 版本开始,引入了 torch.inference_mode 上下文管理器,它类似于 torch.no_grad ,但在推理模式下运行的代码可以通过禁用视图跟踪和版本计数来获得更好的性能。# torch.inference_mode 可以作为上下文管理器使用,也可以作为装饰器使用。# 上下文管理器示例:# with torch.inference_mode():# 在这个示例中,使用 torch.inference_mode 上下文管理器来禁用梯度计算,然后执行乘法操作。在推理模式下, y 的 requires_grad 属性将被设置为 False 。# 装饰器示例:# @torch.inference_mode()# 在这个示例中,使用 @torch.inference_mode() 装饰器来装饰函数 func ,这样在调用 func 时会自动启用推理模式,禁用梯度计算。# torch.is_inference_mode_enabled() 提供了一种方便的方式来检查当前是否处于推理模式,这在调试和性能优化时非常有用。# TORCH_1_9 是一个全局变量,它在函数外部定义,并且是通过 check_version 函数检查 PyTorch 版本是否大于或等于 1.9.0 的结果。# torch.is_inference_mode_enabled() 检查 PyTorch 是否已经启用了推理模式。if TORCH_1_9 and torch.is_inference_mode_enabled():# 如果 PyTorch 版本大于或等于 1.9.0 并且已经启用了推理模式,则直接返回原始函数 fn ,不做任何装饰。return fn # already in inference_mode, act as a pass-through# 否则,根据 PyTorch 的版本选择使用 torch.inference_mode() 或 torch.no_grad() 装饰器,并将其应用于函数 fn 。else:# @torch.no_grad()# @torch.no_grad() 是 PyTorch 中的一个装饰器,用于包裹一个函数,使得在该函数内部执行的所有操作都不会跟踪梯度,也就是说,这些操作不会计算梯度,也不会消耗计算图。# 这通常用于推理(inference)或者评估(evaluation)阶段,因为在这些阶段我们不需要进行反向传播,因此不需要计算梯度,这样可以减少内存消耗并提高计算效率。# 说明 :# 当你使用 @torch.no_grad() 装饰器时,它会暂时将 PyTorch 设置为评估模式,在这个模式下,所有的 Variable 对象都会禁用梯度计算。# 装饰器的作用域仅限于它所装饰的函数内部。# 如果你需要在代码的某个特定区域临时禁用梯度计算,而不是整个函数,可以使用 torch.no_grad() 作为一个上下文管理器: with torch.no_grad(): # 在这个代码块中,梯度计算被禁用 result = model(input_data)# 在示例中, evaluate_model 函数被 @torch.no_grad() 装饰,这意味着在函数内部执行的所有操作都不会跟踪梯度。这在模型评估时非常有用,因为评估时通常不需要进行梯度更新。# torch.inference_mode(mode=True)# torch.inference_mode() 是 PyTorch 中的一个上下文管理器,用于在推理(inference)时禁用梯度计算和某些其他功能,以提高性能。这个功能在 PyTorch 1.9 版本中引入,作为 torch.no_grad() 的一个替代方案,特别是在推理模式下运行代码时,能够获得更好的性能。# 参数说明 :# mode :一个布尔值,指示是否启用推理模式。默认为 True 。# 功能描述 :# 当 mode=True 时, torch.inference_mode() 禁用梯度计算和视图跟踪,这可以减少内存消耗并提高计算速度。# 该上下文管理器是线程局部的,不会影响其他线程的计算。# 注意事项 :# torch.inference_mode() 与 torch.no_grad() 类似,但提供了更好的性能优化,特别是在推理模式下。# 在使用 torch.inference_mode() 时,不能在中途设置 requires_grad=True ,这与 torch.no_grad() 不同,后者允许在上下文内部更改 requires_grad 属性。# 如果已经在推理模式下,再次使用 torch.inference_mode() 作为装饰器或上下文管理器不会改变当前状态,它只会在退出时恢复到先前的状态。# torch.inference_mode() 提供了一种有效的方式来优化模型推理时的性能,特别是在需要禁用梯度计算的场景中。return (torch.inference_mode if TORCH_1_9 else torch.no_grad)()(fn)# 返回装饰器。# smart_inference_mode 函数返回 decorate 函数,这意味着 decorate 本身是一个装饰器,它可以根据 PyTorch 的版本和推理模式的状态来动态地装饰其他函数。return decorate

# smart_inference_mode 函数提供了一种灵活的方式来处理不同 PyTorch 版本之间的差异,并确保在推理时使用最合适的装饰器。4.def autocast(enabled: bool, device: str = "cuda"):

# 这段代码定义了一个名为 autocast 的函数,它用于创建一个上下文管理器,以便在 PyTorch 的自动混合精度(AMP)中使用。这个函数根据 PyTorch 的版本来决定使用哪种 autocast 接口。

# 1.enabled :一个布尔值,指示是否启用自动混合精度。

# 2.device :一个字符串,指定设备类型,默认为 "cuda"。

def autocast(enabled: bool, device: str = "cuda"):# 根据 PyTorch 版本和 AMP 设置获取适当的自动转换上下文管理器。# 此函数返回一个用于自动混合精度 (AMP) 训练的上下文管理器,该管理器与 PyTorch 的旧版本和新版本兼容。它处理 PyTorch 版本之间自动转换 API 的差异。"""Get the appropriate autocast context manager based on PyTorch version and AMP setting.This function returns a context manager for automatic mixed precision (AMP) training that is compatible with botholder and newer versions of PyTorch. It handles the differences in the autocast API between PyTorch versions.Args:enabled (bool): Whether to enable automatic mixed precision.device (str, optional): The device to use for autocast. Defaults to 'cuda'.Returns:(torch.amp.autocast): The appropriate autocast context manager.Note:- For PyTorch versions 1.13 and newer, it uses `torch.amp.autocast`.- For older versions, it uses `torch.cuda.autocast`.Example:```pythonwith autocast(amp=True):# Your mixed precision operations herepass```"""# 检查 PyTorch 版本。# TORCH_1_13 是一个条件变量,用于检查当前 PyTorch 版本是否为 1.13 或更高版本。# 如果 PyTorch 版本是 1.13 或更高,使用 torch.amp.autocast 并指定设备类型和启用状态。if TORCH_1_13:# torch.amp.autocast(enabled=True, device=None, dtype=torch.bfloat16, out=None)# torch.amp.autocast() 是 PyTorch 中用于自动混合精度(Automatic Mixed Precision, AMP)的上下文管理器。它允许你在代码的特定部分自动切换张量的数据类型,以减少内存使用和加速计算,同时保持模型的精度。# 参数 :# enabled :布尔值,指示是否启用自动混合精度。默认为 True 。# device :指定要使用的设备,如 "cuda" 或 "cpu" 。如果为 None ,则使用当前上下文中的设备。# dtype :指定要使用的半精度数据类型。默认为 torch.bfloat16 ,也可以使用 torch.float16 。# out :指定输出张量,如果提供,将在此张量中写入结果。# 功能 :# torch.amp.autocast() 函数创建一个上下文管理器,在此上下文中,PyTorch 会自动将计算的数据类型从单精度(float32)切换到半精度(float16 或 bfloat16),以减少内存使用和加速计算。这种切换是动态的,基于运行时的需要。# 注意事项 :# 使用 torch.amp.autocast() 时,需要确保模型和数据已经移动到支持半精度计算的设备上,如 GPU。# 在某些情况下,可能需要手动将模型的权重和偏差转换为半精度,以充分利用 AMP 的优势。# torch.amp.autocast() 通常与 torch.amp.GradScaler 一起使用,以处理半精度计算中的梯度缩放问题。# torch.amp.autocast() 是 PyTorch AMP 工具箱的核心组件之一,它为深度学习模型的训练提供了一个高效且易于使用的精度管理工具。return torch.amp.autocast(device, enabled=enabled)else:# 如果 PyTorch 版本低于 1.13,使用 torch.cuda.amp.autocast ,这时不能指定设备类型,只能启用或禁用自动混合精度。# 返回值。函数返回一个上下文管理器,可以在 with 语句中使用,以在特定代码块中启用或禁用自动混合精度。return torch.cuda.amp.autocast(enabled)# 自动混合精度 (Automatic Mixed Precision,简称 AMP )是一种用于深度学习训练的技术,它结合了单精度(float32)和半精度(float16)浮点数来加速训练过程并减少内存使用。AMP 特别适用于支持半精度计算的 GPU,如 NVIDIA 的 Tensor Core 架构。以下是 AMP 的一些关键点:# 性能提升 :# 半精度浮点数(float16)比单精度浮点数(float32)需要的内存少,因此在 GPU 上可以存储更多的数据,这有助于提高内存带宽利用率和减少数据传输时间。# 某些 GPU 架构,如 NVIDIA 的 Tensor Core,可以更快地执行半精度计算,从而加速训练。# 内存减少 :# 使用半精度可以减少模型参数和中间激活值所需的内存,这对于大型模型或批量训练尤其有用。# 精度保持 :# AMP 通过在需要高精度的计算部分(如权重更新和偏差)使用单精度,在可以容忍较低精度的部分(如中间激活值)使用半精度,来平衡精度和性能。# 动态调整 :# AMP 动态地在单精度和半精度之间切换,以确保模型的稳定性和准确性不会因为精度损失而受到影响。# 易于实现 :# 在 PyTorch 中,AMP 可以通过 torch.cuda.amp 模块轻松实现,无需对代码进行大量修改。# 梯度缩放 :# 由于半精度可能导致数值下溢,AMP 通常包括梯度缩放,以确保梯度在反向传播时不会变为零。# 兼容性 :# AMP 需要与支持半精度计算的硬件和软件框架兼容,如 NVIDIA 的 CUDA 核心和特定的 GPU 架构。# 自动混合精度已经成为深度学习训练中的一种流行技术,特别是在需要处理大规模数据集和复杂模型的场景中,它能够显著提高训练效率和可扩展性。# 自动混合精度(AMP)是一种用于在训练深度学习模型时减少内存消耗和加速计算的技术,同时保持模型的精度。通过使用 autocast 上下文管理器,可以在模型的特定部分启用 AMP,以优化性能。5.def get_cpu_info():

# 这段代码定义了一个名为 get_cpu_info 的函数,其目的是获取并返回系统CPU的信息,例如品牌和型号。

# 定义了一个函数,没有接受任何参数。

def get_cpu_info():# 返回包含系统 CPU 信息的字符串,例如“Apple M2”。"""Return a string with system CPU information, i.e. 'Apple M2'."""# 从 ultralytics 包中导入 PERSISTENT_CACHE ,这是一个用于存储持久缓存数据的字典,以避免重复计算。from ultralytics.utils import PERSISTENT_CACHE # avoid circular import error# 检查 PERSISTENT_CACHE 字典中是否已经缓存了CPU信息。if "cpu_info" not in PERSISTENT_CACHE:# 使用 contextlib.suppress 上下文管理器来捕获并忽略任何异常,这样即使在获取CPU信息过程中出现异常,代码也不会抛出异常。with contextlib.suppress(Exception):# 导入 cpuinfo 模块,这是一个第三方库,用于获取详细的CPU信息。需要通过 pip install py-cpuinfo 安装。import cpuinfo # pip install py-cpuinfo# 定义一个元组 k ,包含按优先级排序的键,用于从CPU信息中获取最合适的字符串表示。k = "brand_raw", "hardware_raw", "arch_string_raw" # keys sorted by preference# 调用 cpuinfo.get_cpu_info() 函数获取CPU信息字典。info = cpuinfo.get_cpu_info() # info dict# 从 info 字典中按优先级获取 CPU信息字符串 ,如果所有键都不存在,则默认为 "unknown"。string = info.get(k[0] if k[0] in info else k[1] if k[1] in info else k[2], "unknown")# 将获取到的CPU信息字符串进行清理,并存储到 PERSISTENT_CACHE 中。PERSISTENT_CACHE["cpu_info"] = string.replace("(R)", "").replace("CPU ", "").replace("@ ", "")# 返回 PERSISTENT_CACHE 中的CPU信息字符串,如果不存在,则返回 "unknown"。return PERSISTENT_CACHE.get("cpu_info", "unknown")

# 这个函数通过使用 cpuinfo 库来获取系统的CPU信息,并将其存储在缓存中,以供后续调用。这样做可以避免重复获取CPU信息,提高效率。同时,通过清理和格式化CPU信息字符串,使得返回的信息更加简洁和易于理解。6.def select_device(device="", batch=0, newline=False, verbose=True):

# 这段代码定义了一个名为 select_device 的函数,它用于根据用户提供的设备字符串选择并返回一个合适的 PyTorch 设备对象。

# 1.device :用户指定的设备字符串,例如 "cuda:0"、"cpu" 或 "mps"。

# 2.batch :批量大小,用于多 GPU 训练时检查是否能够被 GPU 数量整除。

# 3.newline :是否在日志信息后添加换行符。

# 4.verbose :是否打印设备选择的详细信息。

def select_device(device="", batch=0, newline=False, verbose=True):# 根据提供的参数选择适当的 PyTorch 设备。# 该函数接受指定设备的字符串或 torch.device 对象,并返回表示所选设备的 torch.device 对象。该函数还会验证可用设备的数量,如果请求的设备不可用,则会引发异常。"""Selects the appropriate PyTorch device based on the provided arguments.The function takes a string specifying the device or a torch.device object and returns a torch.device objectrepresenting the selected device. The function also validates the number of available devices and raises anexception if the requested device(s) are not available.Args:device (str | torch.device, optional): Device string or torch.device object.Options are 'None', 'cpu', or 'cuda', or '0' or '0,1,2,3'. Defaults to an empty string, which auto-selectsthe first available GPU, or CPU if no GPU is available.batch (int, optional): Batch size being used in your model. Defaults to 0.newline (bool, optional): If True, adds a newline at the end of the log string. Defaults to False.verbose (bool, optional): If True, logs the device information. Defaults to True.Returns:(torch.device): Selected device.Raises:ValueError: If the specified device is not available or if the batch size is not a multiple of the number ofdevices when using multiple GPUs.Examples:>>> select_device("cuda:0")device(type='cuda', index=0)>>> select_device("cpu")device(type='cpu')Note:Sets the 'CUDA_VISIBLE_DEVICES' environment variable for specifying which GPUs to use."""# 检查设备类型。如果 device 已经是一个 PyTorch 设备对象,则直接返回这个设备。if isinstance(device, torch.device):return device# 构建版本信息字符串。 s 变量用于存储版本信息,包括 Ultralytics YOLO 版本、Python 版本和 PyTorch 版本。s = f"Ultralytics YOLOv{__version__} 🚀 Python-{PYTHON_VERSION} torch-{torch.__version__} "# 处理设备字符串。将 device 转换为小写字符串,并移除可能的前缀和括号,以便统一处理。device = str(device).lower()# 清理设备字符串。# 这个循环遍历一个元组,包含所有需要从 device 字符串中移除的字符或字符串。for remove in "cuda:", "none", "(", ")", "[", "]", "'", " ":# 对于元组中的每个元素,使用 replace 方法从 device 字符串中移除它们。# 例如,如果 device 是 'cuda:0' ,经过这个循环后,它将变为 '0' 。 如果 device 是 '(0, 1)' ,经过这个循环后,它将变为 '0,1' 。device = device.replace(remove, "") # to string, 'cuda:0' -> '0' and '(0, 1)' -> '0,1'# 检查 CPU 设备。检查清理后的 device 字符串是否等于 'cpu' ,如果是,则将 cpu 变量设置为 True 。cpu = device == "cpu"# 检查 MPS 设备。检查清理后的 device 字符串是否等于 'mps' 或 'mps:0' ,如果是,则将 mps 变量设置为 True 。 MPS(Metal Performance Shaders)是 Apple 提供的一种用于在 iOS 和 macOS 上进行高性能图形和计算操作的框架。mps = device in {"mps", "mps:0"} # Apple Metal Performance Shaders (MPS) Apple Metal 性能着色器 (MPS)。# 设置 CUDA_VISIBLE_DEVICES 环境变量为 "-1"。# 如果用户请求的是 CPU 或 MPS 设备,设置环境变量 CUDA_VISIBLE_DEVICES 为 "-1",这样做会强制 PyTorch 使用 CPU,因为 CUDA 设备将被隐藏。if cpu or mps:# 这行代码实际上将 CUDA 设备从 PyTorch 的可用设备列表中移除。os.environ["CUDA_VISIBLE_DEVICES"] = "-1" # force torch.cuda.is_available() = False# 处理非 CPU 设备请求。# 如果用户请求的不是 CPU 或 MPS 设备,即用户指定了某个 CUDA 设备。elif device: # non-cpu device requested# 如果用户简单地指定了 "cuda" 而没有指定具体的设备编号,那么默认使用 "0" 号设备。if device == "cuda":# 将 device 变量设置为 "0",表示默认的 CUDA 设备。device = "0"# 获取和设置 CUDA_VISIBLE_DEVICES 环境变量。# 获取当前 CUDA_VISIBLE_DEVICES 环境变量的值,如果未设置,则返回 None 。visible = os.environ.get("CUDA_VISIBLE_DEVICES", None)# 设置 CUDA_VISIBLE_DEVICES 环境变量为用户指定的 device 值,这将决定 PyTorch 可以看到哪些 CUDA 设备。os.environ["CUDA_VISIBLE_DEVICES"] = device # set environment variable - must be before assert is_available() 设置环境变量-必须在 assert is_available() 之前。# 检查 CUDA 设备的可用性。# 检查 PyTorch 是否可以使用 CUDA,并且可用的 CUDA 设备数量是否满足用户请求的设备数量。if not (torch.cuda.is_available() and torch.cuda.device_count() >= len(device.split(","))):# 如果检查失败,记录一条日志信息,其中 s 包含了版本信息和可能的错误消息。LOGGER.info(s)# 提供安装指南。如果没有 CUDA 设备被 PyTorch 看到,提供一个字符串 install ,其中包含了 PyTorch 安装指南的链接。这个链接提供了如何正确安装 PyTorch 的信息。install = ("See https://pytorch.org/get-started/locally/ for up-to-date torch install instructions if no " # 如果没有,请参阅 https://pytorch.org/get-started/locally/ 获取最新的 torch 安装说明。"CUDA devices are seen by torch.\n" # CUDA 设备可以通过torch查看。if torch.cuda.device_count() == 0else "")# 抛出异常。如果 CUDA 设备不可用或数量不满足要求,抛出一个 ValueError 异常,并提供错误信息,包括用户请求的设备、PyTorch 是否可以使用 CUDA、可用的 CUDA 设备数量以及环境变量 CUDA_VISIBLE_DEVICES 的值。raise ValueError(f"Invalid CUDA 'device={device}' requested." # 请求的 CUDA“device={device}”无效。f" Use 'device=cpu' or pass valid CUDA device(s) if available," # 使用“device=cpu”或传递有效的 CUDA 设备(如果可用),f" i.e. 'device=0' or 'device=0,1,2,3' for Multi-GPU.\n" # 即对于多 GPU,为“device=0”或“device=0,1,2,3”。f"\ntorch.cuda.is_available(): {torch.cuda.is_available()}"f"\ntorch.cuda.device_count(): {torch.cuda.device_count()}"f"\nos.environ['CUDA_VISIBLE_DEVICES']: {visible}\n"f"{install}")# 如果用户没有请求 CPU 或 MPS 设备,并且 PyTorch 可以使用 CUDA,则优先选择 GPU 设备。if not cpu and not mps and torch.cuda.is_available(): # prefer GPU if available# 如果用户提供了设备字符串,则将其分割成多个设备编号;如果没有提供,则默认使用 "0" 号设备。devices = device.split(",") if device else "0" # range(torch.cuda.device_count()) # i.e. 0,1,6,7# 计算设备数量。n = len(devices) # device count# 多 GPU 训练检查。# 如果有多个 GPU 设备,检查批量大小是否合法。if n > 1: # multi-GPU# 如果批量大小小于 1,则抛出异常,因为 AutoBatch 需要一个有效的批量大小。if batch < 1:raise ValueError("AutoBatch with batch<1 not supported for Multi-GPU training, ""please specify a valid batch size, i.e. batch=16.")# 如果批量大小不能被 GPU 数量整除,则抛出异常,并建议使用最接近的能被整除的批量大小。if batch >= 0 and batch % n != 0: # check batch_size is divisible by device_countraise ValueError(f"'batch={batch}' must be a multiple of GPU count {n}. Try 'batch={batch // n * n}' or "f"'batch={batch // n * n + n}', the nearest batch sizes evenly divisible by {n}.")space = " " * (len(s) + 1)# 遍历所有设备编号,获取每个设备的属性,并构建设备信息字符串 s 。for i, d in enumerate(devices):p = torch.cuda.get_device_properties(i)s += f"{'' if i == 0 else space}CUDA:{d} ({p.name}, {p.total_memory / (1 << 20):.0f}MiB)\n" # bytes to MB# 默认选择 "cuda:0" 作为返回的设备标识,但实际上会根据 devices 列表中的设备编号动态选择设备。arg = "cuda:0"# 选择 MPS 设备。# 如果用户请求了 MPS 设备,并且 PyTorch 支持 MPS 且 MPS 可用,则选择 MPS 设备。elif mps and TORCH_2_0 and torch.backends.mps.is_available():# Prefer MPS if available# 构建 MPS 设备信息字符串。s += f"MPS ({get_cpu_info()})\n"# 设置返回的设备标识为 "mps"。arg = "mps"# 回退到 CPU 设备。# 如果没有可用的 GPU 或 MPS 设备,则回退到 CPU 设备。else: # revert to CPU# 构建 CPU 设备信息字符串。s += f"CPU ({get_cpu_info()})\n"# 设置返回的设备标识为 "cpu"。arg = "cpu"# 设置线程数。# 如果选择的是 CPU 或 MPS 设备,设置线程数。if arg in {"cpu", "mps"}:# 为 CPU 训练重置 OpenMP 的线程数。# NUM_THREADS 被设置为系统可用 CPU 核心数减去 1 的值(如果大于 1),但不超过 8,且至少为 1。这样的设置旨在在多核系统上平衡并行计算的效率和资源消耗,避免因为线程过多而导致的性能下降。torch.set_num_threads(NUM_THREADS) # reset OMP_NUM_THREADS for cpu training# 打印日志信息。# 如果 verbose 为 True ,则打印设备选择的详细信息。if verbose:# 根据 newline 参数决定是否在日志信息后添加换行符。LOGGER.info(s if newline else s.rstrip())# 返回设备对象。返回一个 PyTorch 设备对象,可以是 GPU、MPS 或 CPU。return torch.device(arg)# 这段代码的目的是确保根据用户的输入和系统的配置选择最合适的计算设备,并提供详细的日志信息以便用户了解设备选择的结果。通过这种方式,可以确保模型在最佳的设备上运行,无论是 GPU、MPS 还是 CPU。7.def time_sync():

# 这段代码定义了一个名为 time_sync 的函数,其目的是在 PyTorch 环境中提供一个准确的时间测量。

# 这行代码定义了一个没有参数的函数 time_sync 。

def time_sync():# PyTorch 精确的时间。"""PyTorch-accurate time."""# 这行代码检查 CUDA(Compute Unified Device Architecture,由 NVIDIA 提供的并行计算平台和编程模型)是否可用。如果可用,意味着我们可能在处理 GPU 加速的计算。if torch.cuda.is_available():# 如果 CUDA 可用,这行代码调用 torch.cuda.synchronize() 函数。这个函数用于确保当前设备上所有先前排队的 CUDA 核心的所有流中的所有核心完成执行。这是必要的,因为在 GPU 上运行的操作可能是异步的,而 synchronize 确保在测量时间之前所有操作都已完成,从而提供准确的时间测量。torch.cuda.synchronize()# 最后,这行代码返回当前的时间戳,这是通过 Python 标准库中的 time 模块的 time 函数获得的。这个时间戳表示自 Unix 纪元(1970年1月1日00:00:00 UTC)以来的秒数。return time.time()

# 总结来说, time_sync 函数确保在 GPU 上运行的操作完成后才测量时间,这对于测量 GPU 上操作的执行时间非常重要,因为这些操作可能不会立即完成。通过这种方式, time_sync 提供了一个更准确的时间测量,特别是在涉及 GPU 计算的情况下。8.def fuse_conv_and_bn(conv, bn):

# 这段代码定义了一个名为 fuse_conv_and_bn 的函数,其目的是将 PyTorch 中的 Conv2d 卷积层和 BatchNorm2d 批量归一化层融合为一个单独的 Conv2d 层。这种融合可以减少模型中的层数,有助于模型的部署和加速推理过程。

# 定义了一个函数,接受两个参数。

# 1.conv :一个 Conv2d 层。

# 2.bn :一个 BatchNorm2d 层。

def fuse_conv_and_bn(conv, bn):# 融合 Conv2d() 和 BatchNorm2d() 层 https://tehnokv.com/posts/fusing-batchnorm-and-conv/。"""Fuse Conv2d() and BatchNorm2d() layers https://tehnokv.com/posts/fusing-batchnorm-and-conv/."""# 创建了一个新的 Conv2d 层,其参数与输入的 conv 层相同,包括输入通道数、输出通道数、卷积核大小、步长、填充、扩张和组数。 bias=True 表示新卷积层包含偏置项。fusedconv = (nn.Conv2d(conv.in_channels,conv.out_channels,kernel_size=conv.kernel_size,stride=conv.stride,padding=conv.padding,dilation=conv.dilation,groups=conv.groups,bias=True,)# 将新卷积层的权重设置为不需要梯度,因为在融合后的层中,权重通常是固定的。.requires_grad_(False)# 确保新卷积层的权重与原始卷积层的权重在同一设备上(例如,CPU或GPU)。.to(conv.weight.device))# Prepare filters# 将原始卷积层的权重重塑为一个矩阵,其中每一行对应一个输出通道的权重。w_conv = conv.weight.view(conv.out_channels, -1)# torch.diag(input: Tensor, diagonal: int = 0, *, out: Optional[Tensor] = None)# torch.diag 是 PyTorch 中的一个函数,它用于从给定的矩阵中提取对角线元素,或者构造一个以给定对角线元素为值的对角矩阵。这个函数对于矩阵分解和转换等操作非常重要。# 参数 :# input (Tensor) :输入张量。如果输入是一个向量(1D张量), torch.diag 会返回一个以该向量为对角线元素的2D方阵。如果输入是一个矩阵(2D张量),则返回一个包含输入矩阵对角线元素的1D张量。# diagonal (int, optional) :指定的对角线。默认为0,即主对角线。如果 diagonal 大于0,则为位于主对角线之上的对角线;如果 diagonal 小于0,则为位于主对角线之下的对角线。# out (Tensor, optional) :输出张量。这是一个可选参数,可以指定一个张量来存储结果。# 功能描述 :# 如果 input 是向量(一维张量),则返回一个以 input 的元素作为对角线的二维方形张量。# 如果 input 是矩阵(二维张量),则返回具有 input 对角线元素的一维张量。# 计算批量归一化层的权重,并将它们放在对角矩阵中,其中对角线上的元素是批量归一化层的权重除以方差的平方根。w_bn = torch.diag(bn.weight.div(torch.sqrt(bn.eps + bn.running_var)))# 将融合后的权重复制到新卷积层的权重中。这一步涉及到将批量归一化层的权重与卷积层的权重相乘,并将结果重塑为新卷积层权重的形状。fusedconv.weight.copy_(torch.mm(w_bn, w_conv).view(fusedconv.weight.shape))# Prepare spatial bias# 如果原始卷积层没有偏置项,则创建一个全零的偏置项;否则,使用原始卷积层的偏置项。b_conv = torch.zeros(conv.weight.shape[0], device=conv.weight.device) if conv.bias is None else conv.bias# 计算批量归一化层的偏置项,考虑到均值和方差的影响。b_bn = bn.bias - bn.weight.mul(bn.running_mean).div(torch.sqrt(bn.running_var + bn.eps))# 将融合后的偏置项复制到新卷积层的偏置项中。这一步涉及到将批量归一化层的偏置项与卷积层的偏置项相加。fusedconv.bias.copy_(torch.mm(w_bn, b_conv.reshape(-1, 1)).reshape(-1) + b_bn)# 返回融合后的卷积层。return fusedconv

# 这个函数的作用是将卷积和批量归一化层的参数合并到一个新的卷积层中,这样可以在不改变网络结构的情况下减少模型的复杂度。这对于模型优化和部署是非常有用的。9.def fuse_deconv_and_bn(deconv, bn):

# 这段代码定义了一个名为 fuse_deconv_and_bn 的函数,用于将转置卷积层( ConvTranspose2d )和批量归一化层( BatchNorm2d )融合为一个单一的转置卷积层。这种融合可以减少模型中的层数,提高推理速度,并可能减少模型大小。

# 这行代码定义了一个名为 fuse_deconv_and_bn 的函数,它接受两个参数。

# 1.deconv :要融合的转置卷积层。

# 2.bn :要融合的批量归一化层。

def fuse_deconv_and_bn(deconv, bn):# 融合 ConvTranspose2d() 和 BatchNorm2d() 层。"""Fuse ConvTranspose2d() and BatchNorm2d() layers."""# 创建一个新的 ConvTranspose2d 层 fuseddconv ,复制原始转置卷积层的参数,并将偏置设置为 True 。这个新的层将包含融合后的权重和偏置。fuseddconv = (nn.ConvTranspose2d(deconv.in_channels,deconv.out_channels,kernel_size=deconv.kernel_size,stride=deconv.stride,padding=deconv.padding,output_padding=deconv.output_padding,dilation=deconv.dilation,groups=deconv.groups,bias=True,)# 这行代码将新层的权重和偏置的 requires_grad 属性设置为 False ,这意味着在训练过程中,这些参数不会更新。.requires_grad_(False)# 这行代码将新层移动到原始转置卷积层权重所在的设备(CPU或GPU)。.to(deconv.weight.device))# Prepare filters# 这行代码将转置卷积层的权重重塑为一个矩阵,其中每一行对应一个输出通道的权重。w_deconv = deconv.weight.view(deconv.out_channels, -1)# 这行代码创建一个对角矩阵,对角线上是 批量归一化层的权重 除以 方差的平方根 。# torch.div()# div_(value) :div() 的 in-place 运算形式。# .torch.div(input, value, out=None)# 将 input 逐元素除以标量值 value ,并返回结果到输出张量 out 。 即 out=tensor/value 。# 如果输入是 FloatTensor or DoubleTensor 类型,则参数 value 必须为实数,否则须为整数。# 参数:# input (Tensor) :输入张量。# value (Number) :除数。# out (Tensor, optional) :输出张量。w_bn = torch.diag(bn.weight.div(torch.sqrt(bn.eps + bn.running_var)))# torch.mm(input, mat2, *, out=None) -> Tensor# torch.mm 是 PyTorch 中的一个函数,用于执行矩阵乘法。这个函数接受两个输入张量,并返回它们的矩阵乘积。# 参数 :# input :第一个输入张量,它必须是一个2维张量(矩阵)。# mat2 :第二个输入张量,它也必须是一个2维张量(矩阵)。# out :可选参数,用于指定输出张量的张量。如果提供,输出结果将被存储在这个张量中。# 返回值 :# 返回一个新的张量,它是输入张量的矩阵乘积。# 要求 :# 输入张量的最后一个维度(对于第一个输入)和倒数第二个维度(对于第二个输入)必须相匹配,即 input 的列数必须等于 mat2 的行数。# torch.mm 函数在需要执行矩阵乘法的场景中非常有用,例如在机器学习模型中计算全连接层的输出、处理线性代数问题等。# 这行代码计算融合后的权重,通过矩阵乘法将批量归一化层的权重应用到转置卷积层的权重上,并将结果复制到新层的权重中。fuseddconv.weight.copy_(torch.mm(w_bn, w_deconv).view(fuseddconv.weight.shape))# Prepare spatial bias# 如果转置卷积层没有偏置,则创建一个全零的偏置向量;否则,使用转置卷积层的偏置。b_conv = torch.zeros(deconv.weight.shape[1], device=deconv.weight.device) if deconv.bias is None else deconv.bias# torch.Tensor.mul(input, other)# 参数 :# input :要进行乘法操作的张量。# other :另一个张量,可以是标量或与 input 形状相同的张量。# 描述 :# 如果 other 是一个标量,则 input 中的每个元素都会乘以这个标量。 如果 other 是一个张量,那么 input 和 other 必须具有相同的形状,或者 other 可以是广播(broadcast)到 input 形状的张量。在这种情况下, input 和 other 会逐元素相乘。# 返回值 :# 返回修改后的 input 张量。# torch.sqrt(input, *, out=None, dtype=None) -> Tensor# torch.sqrt 是 PyTorch 中的一个函数,用于计算输入张量(tensor)的平方根。这个函数对张量中的每个元素分别计算其平方根。# 参数 :# input :输入张量,可以是标量、向量、矩阵等。# out :可选参数,用于指定输出张量的张量。如果提供,输出结果将被存储在这个张量中。# dtype :可选参数,用于指定输出张量的数据类型。如果提供,输出张量将被转换为指定的数据类型。# 返回值 :# 返回一个新的张量,其中包含输入张量中每个元素的平方根。# torch.sqrt 函数在处理需要元素级平方根计算的张量操作时非常有用,例如在机器学习模型中计算激活函数或进行数据预处理时。# 这行代码计算批量归一化层的偏置,考虑了均值和方差的影响。b_bn = bn.bias - bn.weight.mul(bn.running_mean).div(torch.sqrt(bn.running_var + bn.eps))# 这行代码计算融合后的偏置,通过矩阵乘法将批量归一化层的权重应用到转置卷积层的偏置上,并将结果加上批量归一化层的偏置。fuseddconv.bias.copy_(torch.mm(w_bn, b_conv.reshape(-1, 1)).reshape(-1) + b_bn)# 函数返回融合后的转置卷积层。return fuseddconv

# 总结来说, fuse_deconv_and_bn 函数通过计算融合后的权重和偏置,将转置卷积层和批量归一化层合并为一个单一的转置卷积层。这个融合操作可以优化模型的结构,提高推理效率。10.def model_info(model, detailed=False, verbose=True, imgsz=640):

# 这段代码定义了一个名为 model_info 的函数,用于提供模型的详细信息,包括参数数量、梯度数量、层数、FLOPs(浮点运算次数)等。

# 它接受以下参数。

# 1.model :要分析的模型。

# 2.detailed :一个布尔值,默认为 False ,表示是否返回详细的模型信息。

# 3.verbose :一个布尔值,默认为 True ,表示是否打印模型信息。

# 4.imgsz :一个整数或列表,默认为 640 ,表示输入图像的大小。

def model_info(model, detailed=False, verbose=True, imgsz=640):# 模型信息。"""Model information.imgsz may be int or list, i.e. imgsz=640 or imgsz=[640, 320]."""# 如果 verbose 参数为 False ,则函数直接返回,不打印任何信息。if not verbose:return# 这行代码调用 get_num_params 函数计算模型的参数数量。# def get_num_params(model): -> 计算并返回 YOLO 模型中的总参数数量。计算模型中所有参数的总数量。 -> return sum(x.numel() for x in model.parameters())n_p = get_num_params(model) # number of parameters# 这行代码调用 get_num_gradients 函数计算模型的梯度数量。# def get_num_gradients(model): -> 计算并返回 YOLO 模型中需要梯度的参数总数。计算模型中所有需要梯度的参数的总数量。 -> return sum(x.numel() for x in model.parameters() if x.requires_grad)n_g = get_num_gradients(model) # number of gradients# 这行代码计算模型中的层数。n_l = len(list(model.modules())) # number of layers# 如果 detailed 参数为 True ,则打印详细的模型参数信息。if detailed:# 这行代码使用 LOGGER 记录一个标题行,包括层数、名称、梯度、参数数量、形状、均值、标准差和数据类型。LOGGER.info(f"{'layer':>5} {'name':>40} {'gradient':>9} {'parameters':>12} {'shape':>20} {'mu':>10} {'sigma':>10}")# named_parameters()# named_parameters() 是 PyTorch 中 nn.Module 类的一个方法,它返回模型中所有参数的迭代器,每个参数都以其名称作为前缀。这个方法非常有用,因为它允许你访问和操作模型的每个参数,同时知道它们的名称,这在调试和分析模型时尤其有用。# 参数说明 :# prefix :一个字符串,用于指定返回的参数名称的前缀。默认为空字符串,即不添加任何前缀。# recurse :一个布尔值,指示是否递归遍历所有子模块。默认为 True ,即递归遍历所有子模块。# 返回值 :# 一个迭代器,包含元组,每个元组包含两个元素:参数的名称和参数张量本身。# 注意事项 :# 参数名称是唯一的,并且包含了它们在模型中的路径,这有助于区分同名参数(例如,不同层的权重可能有不同的路径)。# 如果模型中有大量的参数,使用 named_parameters() 方法可以有效地管理和访问它们。# 当你想要对特定参数应用特定的操作或修改时, named_parameters() 方法尤其有用,因为它提供了参数的名称和值。# 这行代码遍历模型的所有参数,并记录每个参数的详细信息。for i, (name, p) in enumerate(model.named_parameters()):# 这行代码清理参数名称,移除不必要的前缀。name = name.replace("module_list.", "")# 这行代码记录每个参数的详细信息,包括索引、名称、是否需要梯度、参数数量、形状、均值、标准差和数据类型。LOGGER.info("%5g %40s %9s %12g %20s %10.3g %10.3g %10s"% (i, name, p.requires_grad, p.numel(), list(p.shape), p.mean(), p.std(), p.dtype))# 这行代码调用 get_flops 函数计算模型的浮点运算次数(FLOPs)。# def get_flops(model, imgsz=640):# -> 用于计算 YOLO 模型的浮点运算次数(FLOPs)。 这行代码根据实际输入图像大小调整 FLOPs。/ 这行代码使用 thop.profile 函数计算模型在实际图像大小输入上的 FLOPs,然后将其转换为十亿次(GFLOPs)并乘以 2 。 / 捕获异常并返回 0.0 GFLOPs。# -> return flops * imgsz[0] / stride * imgsz[1] / stride # imgsz GFLOPs / eturn thop.profile(deepcopy(model), inputs=[im], verbose=False)[0] / 1e9 * 2 # imgsz GFLOPs / return 0.0flops = get_flops(model, imgsz)# 这行代码检查模型是否是融合的,并返回相应的字符串。fused = " (fused)" if getattr(model, "is_fused", lambda: False)() else ""# 这行代码根据 FLOPs 的值生成字符串。fs = f", {flops:.1f} GFLOPs" if flops else ""# 这行代码尝试获取模型的 YAML 文件路径。yaml_file = getattr(model, "yaml_file", "") or getattr(model, "yaml", {}).get("yaml_file", "")# 这行代码从 YAML 文件路径中提取模型名称。model_name = Path(yaml_file).stem.replace("yolo", "YOLO") or "Model"# 这行代码记录模型的总结信息,包括名称、层数、参数数量、梯度数量和 FLOPs。LOGGER.info(f"{model_name} summary{fused}: {n_l:,} layers, {n_p:,} parameters, {n_g:,} gradients{fs}")# 函数返回 层数 、 参数数量 、 梯度数量 和 FLOPs 。return n_l, n_p, n_g, flops

# 总结来说, model_info 函数提供了一个详细的模型分析,包括参数数量、梯度数量、层数和 FLOPs。如果 detailed 参数为 True ,它还会打印每个参数的详细信息。这个函数对于理解模型的结构和性能非常有用。11.def get_num_params(model):

# 这段代码定义了一个名为 get_num_params 的函数,其目的是计算并返回 YOLO 模型中的总参数数量。

# 它接受一个参数。

# model :这个参数是一个模型实例,其参数将被用来计算总参数数量。

def get_num_params(model):# 返回 YOLO 模型中的参数总数。"""Return the total number of parameters in a YOLO model."""# torch.Tensor.numel()# numel() 函数是 PyTorch 中的一个方法,用于返回一个张量(tensor)中元素的总数。这个方法是 torch.Tensor 类的一个实例方法,意味着它可以在任何 torch.Tensor 对象上调用。# 参数 :没有参数# 返回值 :# 返回一个整数,表示张量中的元素总数。# numel() 方法在处理张量时非常有用,尤其是当你需要知道张量的大小而不需要知道具体的维度大小时。这个函数返回的是张量中所有元素的总数,不考虑它的维度结构。# 这行代码计算模型中所有参数的总数量。# model.parameters() :这个方法返回模型中所有参数的迭代器,包括所有层的权重和偏置。# x.numel() :这是一个 PyTorch 张量方法,返回张量 x 中元素的总数。# sum(x.numel() for x in model.parameters()) :这是一个生成器表达式,它遍历模型的所有参数,计算每个参数的元素总数,并将它们相加。最终返回模型中所有参数的总元素数量,即总参数数量。return sum(x.numel() for x in model.parameters())

# 总结来说, get_num_params 函数通过遍历模型的所有参数并计算每个参数的元素总数,来返回模型中的总参数数量。这个函数对于评估模型的大小和复杂度非常有用。12.def get_num_gradients(model):

# 这段代码定义了一个名为 get_num_gradients 的函数,其目的是计算并返回 YOLO 模型中需要梯度的参数总数。

# 这行代码定义了一个函数 get_num_gradients ,它接受一个参数。

# 1.model :这个参数是一个模型实例,其参数将被用来计算需要梯度的参数总数量。

def get_num_gradients(model):# 返回 YOLO 模型中具有梯度的参数总数。"""Return the total number of parameters with gradients in a YOLO model."""# 这行代码计算模型中所有需要梯度的参数的总数量。# model.parameters() :这个方法返回模型中所有参数的迭代器,包括所有层的权重和偏置。# x.numel() :这是一个 PyTorch 张量方法,返回张量 x 中元素的总数。# x.requires_grad :这是一个 PyTorch 张量属性,如果张量 x 需要梯度,则返回 True 。# sum(x.numel() for x in model.parameters() if x.requires_grad) :这是一个生成器表达式,它遍历模型的所有参数,检查每个参数是否需要梯度,如果需要,则计算该参数的元素总数,并将它们相加。最终返回模型中所有需要梯度的参数的总元素数量,即需要梯度的参数总数。return sum(x.numel() for x in model.parameters() if x.requires_grad)

# 总结来说, get_num_gradients 函数通过遍历模型的所有参数,筛选出需要梯度的参数,并计算这些参数的元素总数,来返回模型中需要梯度的参数总数。这个函数对于评估模型训练过程中的梯度信息的规模非常有用。13.def model_info_for_loggers(trainer):

# 这段代码定义了一个名为 model_info_for_loggers 的函数,其目的是收集模型信息,以便为日志记录器提供数据。这个函数根据 trainer 对象的配置,收集不同类型的模型性能信息。

# 参数解释。

# 1.trainer :一个训练器对象,包含了训练过程中的各种参数和状态。

def model_info_for_loggers(trainer):# 返回包含有用模型信息的模型信息字典。"""Return model info dict with useful model information.Example:YOLOv8n info for loggers```pythonresults = {"model/parameters": 3151904,"model/GFLOPs": 8.746,"model/speed_ONNX(ms)": 41.244,"model/speed_TensorRT(ms)": 3.211,"model/speed_PyTorch(ms)": 18.755,}```"""# 检查是否需要性能分析。# 检查 trainer 对象的 args 属性中是否设置了 profile 标志。如果设置了,表示需要进行更详细的性能分析。if trainer.args.profile: # profile ONNX and TensorRT times# 性能分析。# 导入 ProfileModels 类,用于分析模型性能。from ultralytics.utils.benchmarks import ProfileModels# 使用 ProfileModels 类对最后一个模型( trainer.last )进行性能分析,并获取结果。results = ProfileModels([trainer.last], device=trainer.device).profile()[0]# 从结果中移除 "model/name" 键值对,可能是为了避免日志信息过于冗长或重复。results.pop("model/name")# 仅返回 PyTorch 性能数据。# 如果没有设置 profile 标志,只收集 PyTorch 相关的性能数据。else: # only return PyTorch times from most recent validation# 创建一个字典,包含模型 参数数量 和 浮点运算次数 (GFLOPs) 。results = {# 调用 get_num_params 函数获取模型参数数量。# def get_num_params(model): -> 计算并返回 YOLO 模型中的总参数数量。这行代码计算模型中所有参数的总数量。 -> return sum(x.numel() for x in model.parameters())"model/parameters": get_num_params(trainer.model),# 调用 get_flops 函数获取模型的浮点运算次数(GFLOPs)。# def get_flops(model, imgsz=640):# -> 用于计算 YOLO 模型的浮点运算次数(FLOPs)。 这行代码根据实际输入图像大小调整 FLOPs。/ 这行代码使用 thop.profile 函数计算模型在实际图像大小输入上的 FLOPs,然后将其转换为十亿次(GFLOPs)并乘以 2 。 / 捕获异常并返回 0.0 GFLOPs。# -> return flops * imgsz[0] / stride * imgsz[1] / stride # imgsz GFLOPs / eturn thop.profile(deepcopy(model), inputs=[im], verbose=False)[0] / 1e9 * 2 # imgsz GFLOPs / return 0.0"model/GFLOPs": round(get_flops(trainer.model), 3),}# 添加 PyTorch 推理速度。将 PyTorch 推理速度(以毫秒为单位)添加到结果字典中,并保留三位小数。results["model/speed_PyTorch(ms)"] = round(trainer.validator.speed["inference"], 3)# 返回结果。返回包含模型信息的字典。return results

# 这个函数非常有用,特别是在训练和验证模型时,需要记录和监控模型的性能指标。通过这个函数,可以轻松地收集和记录模型的参数数量、计算复杂度和推理速度等关键信息。14.def get_flops(model, imgsz=640):

# 这段代码定义了一个名为 get_flops 的函数,用于计算 YOLO 模型的浮点运算次数(FLOPs)。

# 这行代码定义了一个函数 get_flops ,它接受两个参数。

# 1.model :要分析的模型。

# 2.imgsz :输入图像的大小,默认为 640 。

def get_flops(model, imgsz=640):# 返回 YOLO 模型的 FLOP。"""Return a YOLO model's FLOPs."""# 这行代码检查 thop 库是否可用。如果不可用,函数返回 0.0 GFLOPs。if not thop:return 0.0 # if not installed return 0.0 GFLOPstry:# 这行代码去除模型的任何数据并行包装,确保计算 FLOPs 时不会重复计算。# def de_parallel(model): -> 将一个可能处于数据并行(DataParallel)或分布式数据并行(DistributedDataParallel,简称 DDP)状态的模型转换回单GPU模型。 -> return model.module if is_parallel(model) else modelmodel = de_parallel(model)# 这行代码获取模型的第一个参数,用于确定输入图像的通道数。p = next(model.parameters())# 这行代码确保 imgsz 是一个列表,如果它是一个整数或浮点数,则将其扩展为两个元素的列表。if not isinstance(imgsz, list):imgsz = [imgsz, imgsz] # expand if int/floattry:# Use stride size for input tensor# 这行代码确定模型的最大步长。如果模型有 stride 属性,则使用最大步长;否则,默认为 32 。stride = max(int(model.stride.max()), 32) if hasattr(model, "stride") else 32 # max stride# 这行代码创建一个空的输入张量,其尺寸基于通道数、步长和设备。# (1, p.shape[1], stride, stride) : 这是传递给 torch.empty 函数的形状参数,指定了张量的四个维度。# 1 :第一个维度是批量大小(batch size),这里设置为1,表示这个张量将包含一个数据项。# p.shape[1] :第二个维度是通道数(channel),这里使用 p.shape[1] 来获取模型中第一个参数的第二个维度的大小,这通常是输入图像的通道数。# stride :第三和第四个维度是空间维度,即图像的高度和宽度。这里使用 stride 作为这两个维度的大小, stride 通常是模型中的一个属性,表示网络层之间的步长。# 这行代码创建了一个形状为 (1, channels, stride, stride) 的空张量 im ,其中 channels 是模型输入的通道数, stride 是模型的步长,张量被创建在与模型参数相同的设备上。这个张量通常用作模型的输入,用于计算 FLOPs(浮点运算次数)或其他分析。im = torch.empty((1, p.shape[1], stride, stride), device=p.device) # input image in BCHW format# 这行代码使用 thop.profile 函数计算模型在步长大小输入上的 FLOPs,然后将其转换为十亿次(GFLOPs)并乘以 2 。# [0] / 1e9 * 2 :# thop.profile 函数返回一个包含两个元素的元组 :第一个元素是 FLOPs,第二个元素是参数数量。这里通过 [0] 选择第一个元素,即 FLOPs。# 1e9 是十亿(Giga)的科学记数法表示。这里将 FLOPs 除以 1e9 将其转换为十亿次(GFLOPs)。# * 2 :这可能是为了考虑模型的正向和反向传播,将 FLOPs 乘以2。# 这行代码计算模型在给定输入张量 im 上的浮点运算次数(FLOPs),将其转换为十亿次(GFLOPs),并乘以2以考虑正向和反向传播。结果存储在变量 flops 中。flops = thop.profile(deepcopy(model), inputs=[im], verbose=False)[0] / 1e9 * 2 # stride GFLOPs# 这行代码根据实际输入图像大小调整 FLOPs。return flops * imgsz[0] / stride * imgsz[1] / stride # imgsz GFLOPs# 如果计算步长大小输入的 FLOPs 失败,捕获异常并尝试使用实际图像大小的输入。except Exception:# Use actual image size for input tensor (i.e. required for RTDETR models)# 这行代码创建一个空的输入张量,其尺寸基于通道数和实际图像大小。im = torch.empty((1, p.shape[1], *imgsz), device=p.device) # input image in BCHW format# 这行代码使用 thop.profile 函数计算模型在实际图像大小输入上的 FLOPs,然后将其转换为十亿次(GFLOPs)并乘以 2 。return thop.profile(deepcopy(model), inputs=[im], verbose=False)[0] / 1e9 * 2 # imgsz GFLOPs# 如果所有计算 FLOPs 的尝试都失败,捕获异常并返回 0.0 GFLOPs。except Exception:return 0.0

# 总结来说, get_flops 函数尝试计算模型在给定输入图像大小上的 FLOPs。它首先尝试使用步长大小的输入,如果失败,则使用实际图像大小的输入。如果所有尝试都失败,它返回 0.0 GFLOPs。这个函数对于评估模型的计算复杂度非常有用。15.def get_flops_with_torch_profiler(model, imgsz=640):

# 这段代码定义了一个名为 get_flops_with_torch_profiler 的函数,它用于计算模型的浮点运算次数(FLOPs),即模型在进行一次前向传播时所执行的浮点运算总数。这个函数是 thop 包的替代方案,但运行速度可能慢2到10倍。

# 参数解释。

# 1.model :要分析的 PyTorch 模型。

# 2.imgsz :分析中使用的图像大小,默认为640。可以是整数或列表。

def get_flops_with_torch_profiler(model, imgsz=640):# 计算模型 FLOP( thop 包替代品,但不幸的是速度慢了 2-10 倍)。"""Compute model FLOPs (thop package alternative, but 2-10x slower unfortunately)."""# 版本检查。 检查 PyTorch 版本是否至少为2.0。如果不是,则返回0.0,因为 torch.profiler 仅在 PyTorch 2.0 及以上版本中可用。if not TORCH_2_0: # torch profiler implemented in torch>=2.0return 0.0# 模型去并行化。移除模型的 DataParallel 或 DistributedDataParallel 包装,以便正确分析模型。# def de_parallel(model): -> 将一个可能处于数据并行(DataParallel)或分布式数据并行(DistributedDataParallel,简称 DDP)状态的模型转换回单GPU模型。 -> return model.module if is_parallel(model) else modelmodel = de_parallel(model)# 获取模型参数。获取模型的第一个参数,用于确定设备和输入通道数。p = next(model.parameters())# 处理图像大小。检查 imgsz 是否为列表,如果不是,则将其扩展为列表。if not isinstance(imgsz, list):imgsz = [imgsz, imgsz] # expand if int/float# 创建输入张量。try:# Use stride size for input tensor# 计算输入张量的步长。stride = (max(int(model.stride.max()), 32) if hasattr(model, "stride") else 32) * 2 # max stride# 创建一个空的输入张量,形状为 (1, C, H, W) ,其中 C 是通道数, H 和 W 是根据步长计算的高度和宽度。im = torch.empty((1, p.shape[1], stride, stride), device=p.device) # input image in BCHW format# 使用 torch.profiler 分析 FLOPs。# with torch.profiler.profile(activities, schedule, on_trace_ready, record_shapes, profile_memory, with_stack, with_flops, device, profile_memory_until, on_trace_ready_callback) as prof:# torch.profiler.profile() 是 PyTorch 提供的一个上下文管理器,用于性能分析,它可以测量和记录 PyTorch 操作的执行时间,以及 CPU 和 GPU 上的内存分配和释放事件。# 参数说明 :# activities :指定 profiler 需要监视的活动类型,可以是 ProfilerActivity.CPU 、 ProfilerActivity.CUDA 或它们的组合。# schedule :定义了 profiler 的调度策略,可以是 torch.profiler.schedule(wait, warmup, active, repeat) 。# wait :启动 profiler 前的等待时间。# warmup :预热时间,用于预热系统。# active :实际分析的时间。# repeat :重复分析的次数。# on_trace_ready :当跟踪准备好时的回调函数,可以用于将结果输出到文件或其他地方。# record_shapes :是否记录操作的输入和输出张量的形状。# profile_memory :是否分析内存分配和释放事件。# with_stack :是否记录操作的调用栈。# with_flops :是否计算浮点运算次数(FLOPs)。# device :指定要监视的设备,可以是 torch.device 或 torch.profiler.utils.get_device 返回的设备。# profile_memory_until :指定内存分析的持续时间。# on_trace_ready_callback :当跟踪准备好时的回调函数。# 返回值: :# prof :一个 Profile 对象,包含了分析的结果。# torch.profiler.profile() 提供了丰富的配置选项,允许用户根据具体需求定制性能分析的过程。通过合理配置这些参数,可以更有效地进行性能分析和优化。# 创建一个 profiler 上下文,用于记录 FLOPs。with torch.profiler.profile(with_flops=True) as prof:# 执行模型的前向传播。model(im)# prof.key_averages(group_by_input_shape=False, group_by_stack_n=0)# prof.key_averages() 是 PyTorch Profiler 中的一个方法,它用于从 profiler 收集的数据中提取关键的平均统计信息。这个方法返回一个 KeyAverage 对象,该对象包含了按操作分组的性能数据,可以用来分析和优化模型的性能。# 参数说明 :# group_by_input_shape :(可选)一个布尔值,指示是否根据输入张量的形状对结果进行分组。如果设置为 True ,则 profiler 会记录操作的输入形状,并在结果中显示不同形状的操作。这需要在创建 profiler 时设置 record_shapes=True 。# group_by_stack_n :(可选)一个整数,指示根据调用栈的哪一层对结果进行分组。如果设置为 0 ,则不按调用栈分组;如果设置为 1 或更高值,则按调用栈的相应层分组。# 返回值 :# 返回一个 KeyAverage 对象,包含了关键的平均统计信息。# 方法用途 :# prof.key_averages() 方法用于提取 profiler 收集的性能数据,并以表格的形式展示。这些数据可以用来分析模型中各个操作的性能,例如执行时间、内存使用等。# prof.key_averages() 方法是 PyTorch Profiler 的核心功能之一,它提供了一种简便的方式来分析和优化模型的性能。通过这个方法,开发者可以深入了解模型的计算图、内存使用情况以及操作的执行时间,从而识别和解决性能瓶颈。# 计算总 FLOPs,并转换为十亿(G)。flops = sum(x.flops for x in prof.key_averages()) / 1e9# 调整 FLOPs 计算。根据实际图像大小调整 FLOPs 计算。flops = flops * imgsz[0] / stride * imgsz[1] / stride # 640x640 GFLOPs# 异常处理。# 如果在分析过程中发生异常,则捕获异常并使用实际图像大小重新分析。except Exception:# Use actual image size for input tensor (i.e. required for RTDETR models)im = torch.empty((1, p.shape[1], *imgsz), device=p.device) # input image in BCHW formatwith torch.profiler.profile(with_flops=True) as prof:model(im)flops = sum(x.flops for x in prof.key_averages()) / 1e9# 返回 FLOPs。返回计算得到的 FLOPs 值。return flops

# 这个函数提供了一种使用 PyTorch 内置 profiler 来估计模型 FLOPs 的方法,尽管它可能比使用 thop 包慢,但可以作为替代方案。

16.def initialize_weights(model):

# 这段代码定义了一个名为 initialize_weights 的函数,它用于初始化 PyTorch 模型中的权重和偏置。这个函数遍历模型中的所有模块,并根据模块类型应用特定的初始化策略。

# 1.model :即需要初始化权重的 PyTorch 模型。

def initialize_weights(model):# 将模型权重初始化为随机值。"""Initialize model weights to random values."""# 这行代码遍历模型中的所有模块。for m in model.modules():# 这行代码获取当前模块 m 的类型。t = type(m)# 如果模块 m 是二维卷积层( nn.Conv2d ),则应用特定的初始化策略。在这里,注释掉了 Kaiming 正态分布初始化(可能在其他地方进行了初始化)。if t is nn.Conv2d:pass # nn.init.kaiming_normal_(m.weight, mode='fan_out', nonlinearity='relu')# 如果模块 m 是二维批量归一化层( nn.BatchNorm2d ),则设置其 eps 和 momentum 参数。elif t is nn.BatchNorm2d:# 这行代码将批量归一化层的 eps 参数设置为 0.001 ,这是一个小的数值,用于防止除以零。m.eps = 1e-3# 这行代码将批量归一化层的 momentum 参数设置为 0.03 ,这是用于计算运行均值和方差的动量。m.momentum = 0.03# 如果模块 m 是激活函数(Hardswish、LeakyReLU、ReLU、ReLU6 或 SiLU),则设置其 inplace 参数。elif t in {nn.Hardswish, nn.LeakyReLU, nn.ReLU, nn.ReLU6, nn.SiLU}:# 这行代码将激活函数的 inplace 参数设置为 True ,这意味着激活函数将直接在输入张量上操作,而不是创建新的张量。这可以减少内存消耗,但在某些情况下可能会影响梯度计算。m.inplace = True

# 总结来说, initialize_weights 函数为模型中的不同模块应用特定的初始化策略,包括批量归一化层的参数设置和激活函数的 inplace 设置。这个函数确保模型在训练开始前有合适的初始状态。

17.def scale_img(img, ratio=1.0, same_shape=False, gs=32):

# 这段代码定义了一个名为 scale_img 的函数,它用于对图像张量进行缩放和填充,可选地保持纵横比并确保尺寸是特定值 gs 的倍数。

# 它接受四个参数。

# 1.img :输入的图像张量。

# 2.ratio :缩放比例,默认为 1.0 。

# 3.same_shape :布尔值,表示是否保持原始图像的形状,默认为 False 。

# 4.gs :尺寸的倍数,默认为 32 。

def scale_img(img, ratio=1.0, same_shape=False, gs=32):# 缩放并填充图像张量,可选择保持纵横比并填充为 gs 倍数。"""Scales and pads an image tensor, optionally maintaining aspect ratio and padding to gs multiple."""# 如果缩放比例为 1.0 ,则不需要缩放,直接返回原始图像。if ratio == 1.0:return img# 这行代码获取图像张量 img 的高度和宽度。h, w = img.shape[2:]# 根据缩放比例计算新的尺寸。s = (int(h * ratio), int(w * ratio)) # new size# torch.nn.functional.interpolate(input, size=None, scale_factor=None, mode='nearest', align_corners=None, recompute_scale_factor=None, antialiasing=False)# 在PyTorch中, F.interpolate 函数是 torch.nn.functional.interpolate 的别名,它用于对图像或特征图进行上采样(放大)或下采样(缩小)。这个函数非常灵活,支持多种插值方法,可以用于深度学习模型中的特征图尺寸调整。# 参数解释 :# input :要进行插值的输入张量,通常是4维的,形状为 (batch_size, channels, height, width) 。# size :目标输出尺寸,可以是整数或者元组。如果为 None ,则使用 scale_factor 来计算输出尺寸。# scale_factor :缩放因子,可以是浮点数或者元组。如果为 None ,则使用 size 参数。# mode :插值模式,常用的有 :# 'nearest' :最近邻插值。# 'linear' :线性插值(仅适用于1维数据)。# 'bilinear' :双线性插值(适用于2维数据,如图像)。# 'bicubic' :双三次插值(适用于2维数据,比双线性更平滑)。# 'trilinear' :三线性插值(适用于3维数据)。# align_corners :在某些插值模式下,这个参数控制角落对齐的行为。如果设置为 None ,则对于不同的插值模式有不同的默认行为。# recompute_scale_factor :这个参数用于重新计算缩放因子,通常在 align_corners=None 时使用。# antialiasing :在下采样时是否应用反锯齿,以减少混叠效应。# 使用双线性插值对图像进行缩放,得到新的尺寸。img = F.interpolate(img, size=s, mode="bilinear", align_corners=False) # resize# 如果 same_shape 为 False ,则对图像进行填充或裁剪,以确保尺寸是 gs 的倍数。if not same_shape: # pad/crop img# 使用 math.ceil 函数向上取整,确保高度和宽度是 gs 的倍数。h, w = (math.ceil(x * ratio / gs) * gs for x in (h, w))# torch.nn.functional.pad(input, pad, mode='constant', value=0)# F.pad 是 PyTorch 中的一个函数,用于对张量进行填充(padding)。这个函数可以对多维张量进行操作,按照指定的模式在张量的边界或内部添加值(通常是0)。# 参数 :# input :要进行填充的输入张量。# pad :一个元组,指定了每个边界的填充量。对于二维张量(例如图像), pad 元组的形式为 (left, right, top, bottom) 。对于三维张量,形式为 (left, right, top, bottom, front, back) 。# mode :填充模式,可选值为 'constant' 、 'reflect' 、 'replicate' 或 'circular' 。默认为 'constant' 。# 'constant' :填充常数值(由 value 参数指定)。# 'reflect' :反射填充,即张量的边界值会反射到另一边。# 'replicate' :复制填充,即张量的边界值会被复制。# 'circular' :循环填充,即张量的最后一个值会填充到开始位置,反之亦然。# value :用于 'constant' 模式下的填充值,默认为0。# 返回值 :# 返回填充后的张量。# 使用 F.pad 函数对图像进行填充,以确保尺寸与计算出的高度和宽度相匹配。填充值设置为 0.447 ,这是 ImageNet 数据集的均值。return F.pad(img, [0, w - s[1], 0, h - s[0]], value=0.447) # value = imagenet mean

# 总结来说, scale_img 函数对输入图像进行缩放和填充,确保图像尺寸符合特定要求。它提供了灵活的选项,包括保持纵横比和确保尺寸是特定值的倍数。这个函数在图像处理和深度学习模型中非常有用,特别是在处理不同尺寸的输入图像时。

18.def copy_attr(a, b, include=(), exclude=()):

# 这段代码定义了一个名为 copy_attr 的函数,其作用是将一个对象 b 的属性复制到另一个对象 a 。这个函数提供了包含( include )和排除( exclude )特定属性的选项。

# 参数解释。

# 1.a :目标对象,将要接收属性的对象。

# 2.b :源对象,从中复制属性的对象。

# 3.include :一个元组或列表,指定要复制的属性名称。如果为空,则复制所有属性,除非它们被 exclude 。

# 4.exclude :一个元组或列表,指定要排除的属性名称。

def copy_attr(a, b, include=(), exclude=()):# 将属性从对象“b”复制到对象“a”,并可选择包含/排除某些属性。"""Copies attributes from object 'b' to object 'a', with options to include/exclude certain attributes."""# 遍历源对象 b 的属性。遍历源对象 b 的所有属性。 b.__dict__ 返回一个字典,其中包含 b 的所有属性及其值。for k, v in b.__dict__.items():# 检查是否需要复制属性。# 检查当前属性 k 是否需要被复制。# 如果 include 不为空且 k 不在 include 中,跳过该属性。 如果 k 以 _ 开头(通常是私有属性或特殊方法),跳过该属性。 如果 k 在 exclude 列表中,跳过该属性。if (len(include) and k not in include) or k.startswith("_") or k in exclude:continue# 复制属性。如果属性 k 满足复制条件,则使用 setattr 函数将其从源对象 b 复制到目标对象 a 。else:# setattr(object, name, value)# setattr 是 Python 内置的一个函数,用于将属性赋值给对象。这个函数可以用来动态地设置对象的属性值,包括那些在代码运行时才知道名称的属性。# object :要设置属性的对象。# name :要设置的属性的名称,它应该是一个字符串。# value :要赋给属性的值。# 功能 :# setattr 函数将 value 赋给 object 的 name 指定的属性。如果 name 指定的属性在 object 中不存在,则会创建一个新的属性。返回值 setattr 函数没有返回值。# 注意事项 :# 使用 setattr 时需要注意属性名称的字符串格式,因为属性名称会被直接用作对象的属性键。# setattr 可以用于任何对象,包括自定义类的实例、内置类型的对象等。# 如果需要删除对象的属性,可以使用 delattr 函数,其用法与 setattr 类似,但是用于删除属性而不是设置属性。setattr(a, k, v)

# copy_attr 函数是一个通用的工具函数,可以用于在不同的对象之间复制属性,这在对象继承、配置设置或对象克隆等场景中非常有用。19.def get_latest_opset():

# 这段代码定义了一个名为 get_latest_opset 的函数,其目的是获取当前版本 PyTorch 支持的最新的 ONNX opset 版本号,减去一,以确保所选的 opset 版本是稳定的。

# 参数说明。该函数不接受任何参数。

def get_latest_opset():# 返回此版本的 PyTorch 支持的第二个最新的 ONNX opset 版本,并根据成熟度进行调整。"""Return the second-most recent ONNX opset version supported by this version of PyTorch, adjusted for maturity."""# 版本检查。检查 PyTorch 版本是否大于或等于 1.13。if TORCH_1_13:# If the PyTorch>=1.13, dynamically compute the latest opset minus one using 'symbolic_opset'# 动态计算最新 opset 。# 如果 PyTorch 版本大于或等于 1.13,则动态计算最新的 opset 版本号。 torch.onnx 模块中包含了与 ONNX opset 版本相关的变量,如 symbolic_opset11 、 symbolic_opset12 等。# 获取 torch.onnx 模块中所有以 "symbolic_opset" 开头的变量名,提取版本号(假设版本号是字符串形式,位于变量名的第 14 个字符之后),转换为整数,并找到最大值,然后减去 1。return max(int(k[14:]) for k in vars(torch.onnx) if "symbolic_opset" in k) - 1# Otherwise for PyTorch<=1.12 return the corresponding predefined opset# 返回预定义的 opset。# 如果 PyTorch 版本小于 1.13,则返回与当前 PyTorch 版本对应的预定义 opset 版本号。# 获取 PyTorch ONNX 产商版本号,如 '2.3',并只取主版本号(即 '2')。version = torch.onnx.producer_version.rsplit(".", 1)[0] # i.e. '2.3'# 根据 PyTorch 版本号返回对应的 ONNX opset 版本号,如果没有匹配的版本号,则默认返回 12。return {"1.12": 15, "1.11": 14, "1.10": 13, "1.9": 12, "1.8": 12}.get(version, 12)

# 这个函数非常有用,特别是在需要确定与当前 PyTorch 版本兼容的 ONNX opset 版本时。通过动态计算或返回预定义的版本号,可以确保模型导出时使用的 ONNX opset 版本是稳定和兼容的。20.def intersect_dicts(da, db, exclude=()):

# 这段代码定义了一个名为 intersect_dicts 的函数,它用于找出两个字典中键(key)相同且形状(shape)匹配的项,同时排除掉包含特定字符串的键。

# 它接受三个参数。

# 1.da :第一个字典。

# 2.db :第二个字典。

# 3.exclude :一个元组,包含需要排除的键的部分名称,默认为空元组。

def intersect_dicts(da, db, exclude=()):# 这个函数返回一个新字典,包含两个输入字典中键相同且形状匹配的项,排除掉包含 exclude 中字符串的键,并使用 da 字典中的值。"""Returns a dictionary of intersecting keys with matching shapes, excluding 'exclude' keys, using da values."""# 这行代码是一个字典推导式,用于创建一个新的字典。# k: v for k, v in da.items() :遍历 da 字典中的所有键值对。# if k in db :只保留那些在 db 字典中也存在的键。# and all(x not in k for x in exclude) :确保键 k 不包含 exclude 元组中的任何字符串。# and v.shape == db[k].shape :确保 da 字典中的值的形状与 db 字典中对应值的形状相同。return {k: v for k, v in da.items() if k in db and all(x not in k for x in exclude) and v.shape == db[k].shape}

# 综上所述, intersect_dicts 函数用于比较两个字典,并返回一个新的字典,这个新字典只包含那些键相同、形状匹配且不包含排除字符串的项。这个函数在需要比较两个模型或配置的参数时非常有用,例如在模型训练和推理时确保参数的一致性。21.def is_parallel(model):

# 这段代码定义了一个名为 is_parallel 的函数,用于检查一个给定的 PyTorch 模型是否是数据并行(DataParallel)或分布式数据并行(DistributedDataParallel)的实例。

# 这行代码定义了一个函数 is_parallel ,它接受一个参数。

# 1.model :这个参数是一个模型实例。

def is_parallel(model):# 如果模型是 DP 或 DDP 类型,则返回 True。"""Returns True if model is of type DP or DDP."""# 这行代码是函数的核心逻辑,它使用 isinstance 函数来检查 model 是否是 nn.parallel.DataParallel 或 nn.parallel.DistributedDataParallel 类的实例:# isinstance(object, classinfo) :这是 Python 内置的一个函数,用于检查 object 是否是 classinfo 指定的类型或类的子类的实例。# nn.parallel.DataParallel :这是 PyTorch 中的一个类,用于实现模型的数据并行处理。# nn.parallel.DistributedDataParallel :这是 PyTorch 中的另一个类,用于实现模型的分布式数据并行处理。# 如果 model 是 DataParallel 或 DistributedDataParallel 的实例, is_parallel 函数将返回 True ,否则返回 False 。return isinstance(model, (nn.parallel.DataParallel, nn.parallel.DistributedDataParallel))

# 总结来说, is_parallel 函数提供了一个简单的方式来确定一个模型是否被包装为数据并行或分布式数据并行模型,这在需要对模型进行操作或分析时非常有用,例如在计算模型的 FLOPs 或将其传递给其他函数之前。22.def de_parallel(model):

# 这段代码定义了一个名为 de_parallel 的函数,其目的是将一个可能处于数据并行(DataParallel)或分布式数据并行(DistributedDataParallel,简称 DDP)状态的模型转换回单GPU模型。

# 这行代码定义了一个函数 de_parallel ,它接受一个参数。

# 1.model :这个参数是一个模型实例,可能是单GPU模型、数据并行模型或分布式数据并行模型。

def de_parallel(model):# 解除模型并行化:如果模型是 DP 或 DDP 类型,则返回单 GPU 模型。"""De-parallelize a model: returns single-GPU model if model is of type DP or DDP."""# 这行代码是函数的核心逻辑 :# is_parallel(model) :这是一个未在代码中定义的函数,它应该用于检查给定的 model 是否是数据并行(DP)或分布式数据并行(DDP)模型。如果是,它返回 True 。# model.module :如果 model 是 DP 或 DDP 模型, model.module 属性将包含原始的单GPU模型。# else model :如果 model 不是 DP 或 DDP 模型,函数直接返回 model 本身。return model.module if is_parallel(model) else model

# 总结来说, de_parallel 函数用于处理可能处于并行状态的模型,将其转换回原始的单GPU模型,这对于在不同上下文中使用模型(例如,从训练环境转移到推理环境)非常有用。

# 这个函数假设 is_parallel 函数能够正确识别 DP 和 DDP 模型,并且这些模型的 .module 属性包含了原始模型。23.def one_cycle(y1=0.0, y2=1.0, steps=100):

# 这段代码定义了一个名为 one_cycle 的函数,它生成并返回一个 lambda 函数,该 lambda 函数实现了一个从 y1 到 y2 的正弦波形(sinusoidal ramp)变化。这种变化通常用于学习率调整策略中,以实现周期性的学习率变化。

# 参数解释。

# 1.y1 :波形的起始值,默认为 0.0。

# 2.y2 :波形的结束值,默认为 1.0。

# 3.steps :周期内的总步数,默认为 100。

def one_cycle(y1=0.0, y2=1.0, steps=100):# 返回从 y1 到 y2 的正弦斜坡的 lambda 函数 https://arxiv.org/pdf/1812.01187.pdf。"""Returns a lambda function for sinusoidal ramp from y1 to y2 https://arxiv.org/pdf/1812.01187.pdf."""# 生成 lambda 函数。# 返回一个 lambda 函数,该函数接受一个参数 x , x 表示当前的步骤。# 计算正弦波形。# max((1 - math.cos(x * math.pi / steps)) / 2, 0) :计算当前步骤 x 对应的正弦波形值。# 这里使用了余弦函数 math.cos 来生成一个周期内的波形, x * math.pi / steps 计算了当前步骤在周期中的位置(以弧度为单位)。整个表达式的结果是一个在 [0, 1] 范围内的值,表示波形的高度。# 调整波形范围。# * (y2 - y1) :将正弦波形的高度调整到 [y1, y2] 的范围内。# 计算最终值。# + y1 :将调整后的波形值加上 y1 ,以确保波形从 y1 开始。return lambda x: max((1 - math.cos(x * math.pi / steps)) / 2, 0) * (y2 - y1) + y1

# 这个 one_cycle 函数可以用于实现学习率的周期性调整,特别是在训练深度学习模型时,通过周期性地改变学习率,可以帮助模型更好地收敛。24.def init_seeds(seed=0, deterministic=False):

# 这段代码定义了一个名为 init_seeds 的函数,其目的是初始化随机数生成器(RNG)的种子,以确保实验的可重复性。

# 参数解释。

# 1.seed :随机数生成器的种子值,默认为0。

# 2.deterministic :一个布尔值,指示是否启用确定性算法以确保完全可重复的结果。

def init_seeds(seed=0, deterministic=False):# 初始化随机数生成器(RNG)种子https://pytorch.org/docs/stable/notes/randomness.html。"""Initialize random number generator (RNG) seeds https://pytorch.org/docs/stable/notes/randomness.html."""# 设置随机种子。# 为 Python 内置的随机数生成器设置种子。random.seed(seed)# 为 NumPy 的随机数生成器设置种子。np.random.seed(seed)# 为 PyTorch 的随机数生成器设置种子。torch.manual_seed(seed)# 为 PyTorch CUDA(GPU)随机数生成器设置种子。torch.cuda.manual_seed(seed)# 为所有 CUDA 设备设置种子,用于多 GPU 环境。torch.cuda.manual_seed_all(seed) # for Multi-GPU, exception safe# torch.backends.cudnn.benchmark = True # AutoBatch problem https://github.com/ultralytics/yolov5/issues/9287# 设置确定性算法。# 如果 deterministic 为 True 。if deterministic:# TORCH_2_0 是一个全局变量,用于检查 PyTorch 版本是否至少为 2.0.0。if TORCH_2_0:# torch.use_deterministic_algorithms(mode=True)# torch.use_deterministic_algorithms() 是 PyTorch 提供的一个函数,用于设置是否强制 PyTorch 在执行操作时使用确定性算法。当设置为 True 时,PyTorch 将尽可能使用确定性算法,如果没有确定性算法可用,则会抛出错误。# 这个设置有助于确保在相同的输入和相同的软件硬件环境下,算法总是产生相同的输出,从而提高实验的可重复性。# 参数说明 :# mode :一个布尔值,指示是否启用确定性算法。默认为 True 。# 功能描述 :# 当 mode=True 时,PyTorch 将尽可能使用确定性算法,这有助于确保操作的可重复性。# 如果某个操作没有确定性算法可用,PyTorch 将抛出 RuntimeError 。# 这个设置对于确保深度学习模型训练的可重复性非常有用,尤其是在进行研究和开发时。# 注意事项 :# 仅启用 torch.use_deterministic_algorithms(True) 并不总是足以确保应用程序完全可重现。其他因素,如随机种子的设置和硬件差异,也可能影响结果的可重复性。# 在某些情况下,启用确定性算法可能会降低性能,因为某些优化的、非确定性算法被禁用。# 对于 CUDA 操作,可能需要额外设置环境变量 CUBLAS_WORKSPACE_CONFIG 以确保可重复性,尤其是在 CUDA 版本 10.2 及以上时。# torch.use_deterministic_algorithms() 提供了一个简单的方式来控制 PyTorch 操作的确定性,有助于提高实验的可重复性,尤其是在需要确保结果一致性的研究和开发环境中。# 启用 PyTorch 的确定性算法,这有助于确保每次运行代码时结果都是相同的。 warn_only=True 表示如果不能保证确定性,则发出警告。torch.use_deterministic_algorithms(True, warn_only=True) # warn if deterministic is not possible# torch.backends.cudnn.deterministic = True# torch.backends.cudnn.deterministic 是 PyTorch 中的一个设置项,用于控制 CUDA 深度神经网络库(cuDNN)的行为,以确保每次执行操作时使用的算法是确定性的。当设置为 True 时,PyTorch 将指示 cuDNN 仅使用确定性算法,这有助于确保每次运行代码时的结果都是相同的,从而提高实验的可重复性。# 功能描述 :# 当设置为 True 时,PyTorch 将确保 cuDNN 仅使用确定性算法,这意味着每次执行相同操作时,结果将是一致的。# 这对于那些需要确保结果可重复性的应用非常重要,尤其是在调试和优化模型时。# 注意事项 :# 设置 torch.backends.cudnn.deterministic = True 可能会降低性能,因为某些优化的、非确定性算法被禁用。# 某些 cuDNN 函数可能受到限制,因为固定种子可能会降低某些算法的效率。# 为了确保完全的确定性,通常还需要设置其他相关的随机种子,如 torch.manual_seed() 和 np.random.seed() 。# torch.backends.cudnn.deterministic 提供了一个简单的方式来控制 cuDNN 的行为,以确保在使用 GPU 时的确定性,这对于需要高度可重复性的深度学习研究和应用至关重要。# 设置 PyTorch 的 cuDNN 后端为确定性模式,这有助于确保 GPU 上的操作是可重复的。torch.backends.cudnn.deterministic = True# 设置 CUDA 的工作空间配置,这有助于控制 CUDA 在 GPU 上的内存使用。os.environ["CUBLAS_WORKSPACE_CONFIG"] = ":4096:8"# 设置 Python 的哈希种子,确保 Python 内置的哈希函数产生可重复的结果。os.environ["PYTHONHASHSEED"] = str(seed)else:LOGGER.warning("WARNING ⚠️ Upgrade to torch>=2.0.0 for deterministic training.") # 警告⚠️升级到 torch>=2.0.0 进行确定性训练。# 如果 deterministic 为 False 。else:# 禁用确定性算法。torch.use_deterministic_algorithms(False)# 设置 PyTorch 的 cuDNN 后端为非确定性模式。torch.backends.cudnn.deterministic = False

# 这个函数非常有用,特别是在需要确保实验结果可重复性的研究和开发中。通过设置随机种子和确定性算法,可以减少随机性对结果的影响,从而提高实验的可靠性。25.class ModelEMA:

# 这段代码定义了一个名为 ModelEMA 的类,它实现了模型指数移动平均(Exponential Moving Average, EMA)的功能。EMA是一种技术,用于在训练过程中平滑模型参数,通常可以提高模型的稳定性和性能。

# 类定义和初始化。

class ModelEMA:# 更新了 https://github.com/rwightman/pytorch-image-models 中的指数移动平均线 (EMA)。保留模型 state_dict(参数和缓冲区)中所有内容的移动平均值。# 要禁用 EMA,请将 `enabled` 属性设置为 `False`。"""Updated Exponential Moving Average (EMA) from https://github.com/rwightman/pytorch-image-models. Keeps a movingaverage of everything in the model state_dict (parameters and buffers).For EMA details see https://www.tensorflow.org/api_docs/python/tf/train/ExponentialMovingAverageTo disable EMA set the `enabled` attribute to `False`."""# 这段代码是一个类的初始化方法 __init__ ,它属于 ModelEMA 类,用于设置模型的指数移动平均(Exponential Moving Average, EMA)。# 参数解释。# 1.model :要应用 EMA 的原始模型。# 2.decay :EMA 的衰减率,默认为 0.9999。这个值越接近1,EMA参数更新的越慢。# 3.tau :用于指数衰减率计算的参数,默认为 2000。这个值越大,衰减越慢。# 4.updates :EMA 更新的次数,默认为 0。def __init__(self, model, decay=0.9999, tau=2000, updates=0):# 使用给定的参数初始化“模型”的 EMA。"""Initialize EMA for 'model' with given arguments."""# 创建 EMA 模型的副本。# 使用 deepcopy 创建模型的一个深拷贝,以避免修改原始模型。# de_parallel 函数用于移除模型的 DataParallel 或 DistributedDataParallel 包装,确保 EMA 操作的是模型的原始版本。# 然后调用 eval() 方法将模型设置为评估模式,这会关闭 Dropout 和 Batch Normalization 等对训练和评估行为不同的层。# def de_parallel(model): -> 将一个可能处于数据并行(DataParallel)或分布式数据并行(DistributedDataParallel,简称 DDP)状态的模型转换回单GPU模型。 -> return model.module if is_parallel(model) else modelself.ema = deepcopy(de_parallel(model)).eval() # FP32 EMA# 初始化更新次数。记录 EMA 更新的次数。self.updates = updates # number of EMA updates# 定义衰减函数。# 定义一个 lambda 函数来计算指数衰减率。这个衰减率随训练迭代次数 x 的增加而逐渐稳定,有助于在训练初期更平滑地更新 EMA 参数。self.decay = lambda x: decay * (1 - math.exp(-x / tau)) # decay exponential ramp (to help early epochs) 0.9999*(1-e^(-x/2000))# 禁用 EMA 模型参数的梯度。# 遍历 EMA 模型的所有参数,并将它们的 requires_grad 属性设置为 False ,这样在反向传播时不会计算这些参数的梯度,因为 EMA 参数不需要通过反向传播来更新。for p in self.ema.parameters():p.requires_grad_(False)# 设置 EMA 启用标志。设置一个标志,指示 EMA 是否启用。这个标志可以在训练过程中动态控制 EMA 的启用和禁用。self.enabled = True# 这个初始化方法为模型 EMA 的使用做好了准备,确保了 EMA 参数的正确初始化和配置。通过这种方式,可以在训练过程中维护一个平滑的模型参数版本,有助于提高模型的稳定性和最终性能。# 这段代码是 ModelEMA 类中的 update 方法,它用于更新模型的指数移动平均(EMA)参数。# 参数解释。# 1.model :当前训练中的模型,用于更新 EMA 参数。def update(self, model):# 更新 EMA 参数。"""Update EMA parameters."""# 检查 EMA 是否启用。检查 EMA 是否被启用,如果未启用,则不执行更新。if self.enabled:# 增加更新次数。增加 EMA 更新的次数。self.updates += 1# 计算衰减率。使用之前定义的衰减函数计算当前的衰减率。d = self.decay(self.updates)# 获取模型的状态字典。获取去除了 DataParallel 或 DistributedDataParallel 包装的模型的状态字典。msd = de_parallel(model).state_dict() # model state_dict# 更新 EMA 参数。# 遍历 EMA 模型的状态字典中的所有参数。for k, v in self.ema.state_dict().items():# 检查参数是否为浮点类型(包括 FP16 和 FP32)。if v.dtype.is_floating_point: # true for FP16 and FP32# 将 EMA 参数乘以衰减率 d 。v *= d# 将 EMA(指数移动平均)参数加上一部分当前模型参数是指数移动平均更新策略的核心。这种策略的目的是逐渐将模型参数向 EMA 参数靠拢,同时保留一些原始参数的特性。# 平滑参数变化 :# 在训练过程中,模型参数可能会由于随机梯度下降而发生剧烈波动,尤其是在训练初期或面对复杂的数据分布时。EMA 参数通过逐渐融合当前模型参数,有助于平滑这些波动,从而减少过拟合的风险。# 提高稳定性 :# EMA 参数提供了一种稳定化的机制,它们通常比原始参数更稳定,因为它们是过去参数的加权平均。这种稳定性可以帮助模型在面对噪声和异常值时保持鲁棒性。# 避免局部最小值 :# 由于 EMA 参数是过去参数的平滑版本,它们不太可能陷入局部最小值。这意味着 EMA 参数可以帮助模型逃离不良的局部最优解,从而有可能找到更好的全局最优解。# 提高泛化能力 :# EMA 参数通常能够提高模型的泛化能力。由于它们减少了训练过程中的噪声和波动,EMA 参数可以帮助模型学习到更一般化的特征表示。# 保持训练动态 :# 通过逐渐更新 EMA 参数,而不是在每次迭代中完全替换它们,可以保持训练过程中的动态平衡。这允许模型在保持过去信息的同时,也对新信息做出响应。# 实现“慢启动”效果 :# 在训练初期,EMA 参数更新较慢,这有助于模型在初始阶段不会受到过多历史数据的影响,从而允许模型从训练数据中快速学习。随着训练的进行,EMA 参数逐渐包含了更多的最新信息,这有助于模型在后期稳定下来。# 总之,将 EMA 参数加上一部分当前模型参数是一种有效的方法,用于在训练过程中维护模型参数的稳定性和鲁棒性,同时提高模型的泛化能力。这种方法在实践中被广泛用于提高深度学习模型的性能。# 将 EMA 参数加上一部分当前模型参数,这部分的权重为 (1 - d) 。使用 detach() 方法是为了确保添加的参数不会在反向传播中计算梯度。v += (1 - d) * msd[k].detach()# 注释掉的断言。这一行被注释掉的代码是一个断言,用于确保 EMA 参数和模型参数的数据类型都是 torch.float32 。如果类型不匹配,将抛出错误。# assert v.dtype == msd[k].dtype == torch.float32, f'{k}: EMA {v.dtype}, model {msd[k].dtype}'# 这个方法的核心作用是将模型的参数以一定的衰减率 d 融合到 EMA 参数中,使得 EMA 参数成为模型参数的指数移动平均。这种更新方式有助于平滑模型参数的变化,减少训练过程中的波动,从而提高模型的稳定性和性能。# 通过在训练过程中定期更新 EMA 参数,可以在模型训练完成后使用这些平滑的参数进行推理,可能会得到更好的结果。# 这段代码是 ModelEMA 类中的 update_attr 方法,它用于将模型的某些属性复制到 EMA 模型中,并保存一个去除优化器的精简模型。# 参数解释 :# 1.model :当前训练中的模型,从中复制属性。# 2.include :一个元组或列表,指定要复制的属性名称。如果为空,则复制所有非排除的属性。# 3.exclude :一个元组或列表,指定要排除的属性名称,默认排除 "process_group" 和 "reducer" 。def update_attr(self, model, include=(), exclude=("process_group", "reducer")):# 更新属性并保存已删除优化器的剥离模型。"""Updates attributes and saves stripped model with optimizer removed."""# 检查 EMA 是否启用。# 检查 EMA 是否被启用,如果未启用,则不执行属性复制。if self.enabled:# 复制属性。调用 copy_attr 函数,将 model 的属性复制到 self.ema (EMA 模型)。 include 参数指定了要复制的属性, exclude 参数指定了要排除的属性。# def copy_attr(a, b, include=(), exclude=()): -> 将一个对象 b 的属性复制到另一个对象 a 。这个函数提供了包含( include )和排除( exclude )特定属性的选项。copy_attr(self.ema, model, include, exclude)# update_attr 方法的目的是更新 EMA 模型,使其不仅包含平滑的参数,还包含原始模型的其他相关属性,如训练历史、额外的层或元数据等。# 通过排除某些属性(如分布式训练相关的 "process_group" 和 "reducer" ),可以确保 EMA 模型保持轻量级,并且不会在保存或推理时引起问题。# 这种方法在保存模型时特别有用,因为它允许我们将一个精简的、不含优化器状态的模型版本保存到磁盘,这对于模型部署和推理是必要的。

# ModelEMA 类提供了一种机制,通过在训练过程中维护模型参数的指数移动平均,来平滑模型参数的变化。这可以帮助提高模型的泛化能力,并可能提高最终模型的性能。通过 update 方法,可以在每个训练迭代后更新 EMA 参数,而 update_attr 方法可以用来同步其他模型属性到 EMA 模型。26.def strip_optimizer(f: Union[str, Path] = "best.pt", s: str = "", updates: dict = None) -> dict:

# 这段代码定义了一个名为 strip_optimizer 的函数,其目的是从 PyTorch 模型的检查点文件中移除优化器状态,并保存一个精简的模型文件。

# 参数解释。

# 1.f :要处理的检查点文件的路径,默认为 "best.pt"。

# 2.s :保存精简模型的路径,默认为空,此时将覆盖原文件。

# 3.updates :要更新到检查点中的额外信息,默认为 None。

def strip_optimizer(f: Union[str, Path] = "best.pt", s: str = "", updates: dict = None) -> dict:# 从 'f' 中剥离优化器以完成训练,可选择保存为 's'。# 注意:# 使用 `ultralytics.nn.torch_safe_load` 查找缺失模块,其中 `x = torch_safe_load(f)[0]`"""Strip optimizer from 'f' to finalize training, optionally save as 's'.Args:f (str): file path to model to strip the optimizer from. Default is 'best.pt'.s (str): file path to save the model with stripped optimizer to. If not provided, 'f' will be overwritten.updates (dict): a dictionary of updates to overlay onto the checkpoint before saving.Returns:(dict): The combined checkpoint dictionary.Example:```pythonfrom pathlib import Pathfrom ultralytics.utils.torch_utils import strip_optimizerfor f in Path("path/to/model/checkpoints").rglob("*.pt"):strip_optimizer(f)```Note:Use `ultralytics.nn.torch_safe_load` for missing modules with `x = torch_safe_load(f)[0]`"""# 这段代码是 strip_optimizer 函数的一部分,它负责从指定的文件路径加载 PyTorch 模型的检查点,并验证其有效性。# 加载检查点。try:# 使用 PyTorch 的 torch.load 函数从文件路径 f 加载检查点,并将所有张量映射到 CPU 设备上。x = torch.load(f, map_location=torch.device("cpu"))# 验证检查点。断言检查点 x 是一个 Python 字典。如果不是字典,则抛出异常。assert isinstance(x, dict), "checkpoint is not a Python dictionary"# 断言检查点字典中包含 "model" 键。如果不包含,则抛出异常。assert "model" in x, "'model' missing from checkpoint"# 异常处理。# 捕获加载和验证过程中可能出现的任何异常。except Exception as e:# 使用日志记录器 LOGGER 记录一条警告信息,指出文件 f 不是一个有效的 Ultralytics 模型检查点,并包含异常信息 e 。LOGGER.warning(f"WARNING ⚠️ Skipping {f}, not a valid Ultralytics model: {e}")# 如果出现异常,函数返回一个空字典。return {}# 准备元数据。创建一个包含元数据的字典,包括当前日期和时间(ISO 格式)、版本号 __version__ 、许可证信息和文档链接。metadata = {"date": datetime.now().isoformat(),"version": __version__,"license": "AGPL-3.0 License (https://ultralytics.com/license)","docs": "https://docs.ultralytics.com",}# 这段代码确保了函数能够正确地加载和验证模型检查点,并且在检查点无效时提供有用的日志信息。元数据字典 metadata 用于存储关于检查点的额外信息,这些信息可能会在后续步骤中添加到检查点字典中或用于记录模型的相关信息。# Update model# 这段代码是 strip_optimizer 函数中用于更新模型部分的代码,它处理加载的检查点字典 x 中的模型数据。# 替换为 EMA 模型。# 检查检查点字典中是否存在键 "ema" ,它代表指数移动平均(EMA)模型。if x.get("ema"):# 如果存在 EMA 模型,则用 EMA 模型替换原模型。EMA 模型通常在训练过程中用于平滑模型参数,提高模型的泛化能力。x["model"] = x["ema"] # replace model with EMA# 转换模型参数。# 检查模型是否有 "args" 属性。if hasattr(x["model"], "args"):# 如果有,则将 "args" 属性从 IterableSimpleNamespace 转换为普通的 Python 字典。这是因为 SimpleNamespace 在序列化(如保存为文件)时可能会遇到问题。x["model"].args = dict(x["model"].args) # convert from IterableSimpleNamespace to dict# 移除损失函数。# 检查模型是否有 "criterion" 属性,它代表损失函数。if hasattr(x["model"], "criterion"):# 如果有,则将损失函数设置为 None 。这是因为在模型部署时通常不需要损失函数。x["model"].criterion = None # strip loss criterion# 转换模型为 FP16 。将模型的所有参数转换为 FP16(半精度浮点数),这有助于减少模型大小并可能提高推理速度,特别是在 GPU 上。x["model"].half() # to FP16# 禁用梯度计算。# 遍历模型的所有参数。for p in x["model"].parameters():# 将每个参数的 requires_grad 属性设置为 False ,这意味着在后续的操作中不会计算这些参数的梯度。这在模型部署或固定模型参数时是常用的做法。p.requires_grad = False# 这段代码的目的是准备模型以用于推理或进一步的处理,通过移除不必要的部分(如优化器状态和损失函数),并确保模型参数是最新的(如果使用了 EMA),以及将模型转换为更高效的格式(如 FP16)。这些步骤有助于提高模型的运行效率,并确保模型在不同环境中的兼容性。# Update other keys# 这段代码继续处理 strip_optimizer 函数中的检查点字典 x ,目的是更新或移除某些键,以便精简检查点并准备用于模型部署。# 合并训练参数。# 创建一个新的字典 args ,它合并了默认配置 DEFAULT_CFG_DICT 和检查点中的训练参数 train_args 。如果检查点中没有 train_args ,则使用一个空字典。args = {**DEFAULT_CFG_DICT, **x.get("train_args", {})} # combine args# 移除特定键。# 遍历一个元组,包含要移除的键名。for k in "optimizer", "best_fitness", "ema", "updates": # keys# 将这些键的值设置为 None ,实际上从检查点中移除了这些键,因为它们通常包含优化器状态或其他不需要在部署中使用的参数。x[k] = None# 设置 epoch 为 -1。将 epoch 键的值设置为 -1 ,表示模型已经训练完成或不在训练过程中。x["epoch"] = -1# 精简训练参数。# 更新 train_args 键,只保留那些在 DEFAULT_CFG_KEYS 中的键值对。这有助于移除任何非默认的配置参数,这些参数可能在模型部署中不需要。x["train_args"] = {k: v for k, v in args.items() if k in DEFAULT_CFG_KEYS} # strip non-default keys# 注释掉的代码。这一行被注释掉了,如果取消注释,它会将模型的 args 属性设置为精简后的训练参数。这可能是一个用于确保模型参数与训练参数保持一致的步骤。# x['model'].args = x['train_args']# 这段代码的目的是确保检查点中不包含不必要的信息,如优化器状态和特定的训练参数,同时保留模型部署所需的关键信息。通过这种方式,可以减少检查点的大小,并确保模型在不同环境和平台上的兼容性和效率。# Save# 这段代码是 strip_optimizer 函数的最后一部分,它负责将更新后的检查点字典保存到文件,并记录相关信息。# 合并字典。# 创建一个新的字典 combined ,它合并了元数据 metadata 、检查点字典 x 和任何额外的更新 updates 。如果 updates 为 None ,则使用一个空字典。这确保了保存的检查点包含了所有必要的信息。combined = {**metadata, **x, **(updates or {})}# 保存检查点。# 使用 PyTorch 的 torch.save 函数将合并后的字典 combined 保存到文件。如果提供了 s (新的文件路径),则保存到 s ;否则,保存到原始路径 f 。 use_dill=False 参数指定不使用 dill 库进行序列化, dill 是一个用于序列化 Python 对象的库,有时可能不是必须的。# 设置 use_dill=False 是推荐的做法,因为它确保了代码的安全性、兼容性和稳定性,同时利用了 PyTorch 的优化和默认行为。如果你没有特别需要 dill 提供的额外功能,通常最好坚持使用 PyTorch 的默认序列化设置。torch.save(combined, s or f, use_dill=False) # combine dicts (prefer to the right)# 计算文件大小。计算保存的文件大小(以兆字节为单位)。 os.path.getsize 函数获取文件的大小(以字节为单位),然后除以 1e6 转换为兆字节。mb = os.path.getsize(s or f) / 1e6 # file size# 记录日志信息。使用日志记录器 LOGGER 记录一条信息级别的日志,说明优化器已从原始检查点 f 中移除,并提供了新文件的路径(如果提供了 s ),以及文件的大小(以兆字节为单位)。LOGGER.info(f"Optimizer stripped from {f},{f' saved as {s},' if s else ''} {mb:.1f}MB")# 返回结果。函数返回合并后的检查点字典 combined ,这样调用者可以进一步处理或使用这个字典。return combined# 这段代码确保了检查点文件被正确地更新和保存,同时提供了关于文件操作的详细日志信息。通过这种方式,可以确保模型文件只包含必要的参数和配置,便于在不同环境和平台上使用。

# 这个函数非常有用,特别是在模型部署阶段,因为部署时通常不需要优化器状态,这样可以减少模型文件的大小,并且提高加载速度。通过这种方式,可以确保模型文件只包含必要的参数和配置,便于在不同环境和平台上使用。

27.def convert_optimizer_state_dict_to_fp16(state_dict):

# 这段代码定义了一个名为 convert_optimizer_state_dict_to_fp16 的函数,它用于将优化器的状态字典( state_dict )中的浮点数张量转换为半精度浮点数(FP16)。

# 参数解释。

# 1.state_dict :优化器的状态字典,包含了优化器的所有参数和状态信息。

def convert_optimizer_state_dict_to_fp16(state_dict):# 将给定优化器的 state_dict 转换为 FP16,重点关注张量转换的“state”键。# 此方法旨在减少存储大小而不改变“param_groups”,因为它们包含非张量数据。"""Converts the state_dict of a given optimizer to FP16, focusing on the 'state' key for tensor conversions.This method aims to reduce storage size without altering 'param_groups' as they contain non-tensor data."""# 遍历状态字典。# 遍历状态字典中的 "state" 键对应的值,这个值是一个包含所有参数组状态的字典。for state in state_dict["state"].values():# 遍历每个参数组的状态。# 遍历当前参数组状态的每个键值对。for k, v in state.items():# 检查键和数据类型。# 检查键 k 是否不是 "step" (因为 "step" 通常用于记录优化器的迭代步数,不需要转换),检查值 v 是否是 torch.Tensor 类型,并且数据类型是否为 torch.float32 。if k != "step" and isinstance(v, torch.Tensor) and v.dtype is torch.float32:# 转换为 FP16。如果条件满足,将张量 v 转换为 FP16 格式,并更新状态字典中的对应值。state[k] = v.half()# 返回状态字典。返回更新后的状态字典。return state_dict

# 转换为 FP16 可以减少模型和优化器状态的内存占用,这在资源受限的环境中非常有用,如在 GPU 上进行训练或推理时。

# 这种转换通常在模型部署或推理前进行,因为这些场景下不需要进行梯度更新,因此可以使用半精度浮点数来减少内存占用。

# 在某些情况下,保持优化器状态为 FP32 可能有助于保持数值稳定性,尤其是在训练过程中。因此,这种转换通常在训练完成后进行。28.def profile(input, ops, n=10, device=None):

# 这段代码定义了一个名为 profile 的函数,它用于评估模型或操作(ops)在不同输入下的性能和资源消耗。

# 1.input :输入数据,可以是单个张量或张量列表。

# 2.ops :要评估的操作或模型,可以是单个操作或操作列表。

# 3.n :重复执行操作的次数,默认为 10。

# 4.device :执行操作的设备,默认为 None,如果为 None,则使用 select_device 函数选择设备。

def profile(input, ops, n=10, device=None):# Ultralytics 速度、内存和 FLOP 分析器。"""Ultralytics speed, memory and FLOPs profiler.Example:```pythonfrom ultralytics.utils.torch_utils import profileinput = torch.randn(16, 3, 640, 640)m1 = lambda x: x * torch.sigmoid(x)m2 = nn.SiLU()profile(input, [m1, m2], n=100) # profile over 100 iterations```"""# 初始化结果列表。用于存储每个输入和操作的性能结果。results = []# 检查设备。如果 device 为 None,则使用 select_device 函数选择设备。if not isinstance(device, torch.device):# def select_device(device="", batch=0, newline=False, verbose=True): -> 它用于根据用户提供的设备字符串选择并返回一个合适的 PyTorch 设备对象。返回一个 PyTorch 设备对象,可以是 GPU、MPS 或 CPU。 -> return torch.device(arg)device = select_device(device)# 日志信息。使用 LOGGER.info 记录 参数 、 GFLOPs 、 GPU 内存 、 前向传播时间 、 反向传播时间 、 输入 和 输出 的形状信息。LOGGER.info(f"{'Params':>12s}{'GFLOPs':>12s}{'GPU_mem (GB)':>14s}{'forward (ms)':>14s}{'backward (ms)':>14s}"f"{'input':>24s}{'output':>24s}")# 这段代码是 profile 函数的一部分,它负责对每个输入和模型(或操作)组合进行性能评估。# 遍历输入。# 这行代码检查 input 是否是一个列表。如果是列表,则直接遍历 input 中的每个元素;如果不是列表,则将 input 包装成一个列表,这样就可以统一处理单个输入和输入列表。for x in input if isinstance(input, list) else [input]:# 准备输入数据。# 将输入数据 x 移动到指定的设备(如 GPU)上。x = x.to(device)# 设置 x 的 requires_grad 属性为 True ,这样在反向传播时会计算关于 x 的梯度。这对于评估模型的反向传播性能是必要的。x.requires_grad = True# 遍历模型或操作。# 类似地,这行代码检查 ops 是否是一个列表。如果是列表,则直接遍历 ops 中的每个元素;如果不是列表,则将 ops 包装成一个列表。for m in ops if isinstance(ops, list) else [ops]:# 准备模型或操作。# 如果 m 有 to 方法(即是一个模型或张量),则将其移动到指定的设备上。m = m.to(device) if hasattr(m, "to") else m # device# 如果 m 支持半精度运算(即有 half 方法),且输入 x 是一个张量且数据类型为 torch.float16 (半精度浮点数),则将 m 转换为半精度。这有助于评估模型在半精度下的性能。m = m.half() if hasattr(m, "half") and isinstance(x, torch.Tensor) and x.dtype is torch.float16 else m# 初始化计时变量。初始化三个变量 tf 和 tb 用于存储 前向传播 和 反向传播 的平均时间(以毫秒为单位), t 是一个列表,用于存储 每次迭代的前向传播和反向传播时间 。tf, tb, t = 0, 0, [0, 0, 0] # dt forward, backward# 这段代码的目的是为每个输入和模型(或操作)组合设置必要的条件,以便进行性能评估。通过移动数据和模型到指定设备、设置 requires_grad 属性、以及可能的半精度转换,确保了评估的准确性和效率。# 这段代码是 profile 函数中用于计算模型或操作的浮点运算次数(FLOPs)的部分。# 尝试计算 FLOPs。# 开始一个 try 块,用于捕获在计算 FLOPs 过程中可能出现的任何异常。try:# thop.profile(m, inputs=[x], verbose=False) : 使用 thop 库(如果可用)的 profile 函数来计算模型或操作 m 在输入 x 下的浮点运算次数。 inputs=[x] 指定了模型或操作的输入。 verbose=False 表示不打印详细的分析信息。# [0] :从 thop.profile 返回的结果中提取第一个元素,这通常是总的浮点运算次数。# / 1e9 :将浮点运算次数从原始单位(通常是 FLOPs)转换为十亿(GFLOPs)。# * 2 :乘以 2,这可能是为了考虑每次操作的两个输入或输出。# if thop else 0 :如果 thop 库可用,则计算 FLOPs;如果不可用,则将 FLOPs 设置为 0。flops = thop.profile(m, inputs=[x], verbose=False)[0] / 1e9 * 2 if thop else 0 # GFLOPs# 异常处理。如果在计算 FLOPs 过程中出现任何异常,将捕获这些异常并将 flops 设置为 0。except Exception:# 变量 flops 将存储计算出的 FLOPs 值,或者在出现异常时存储 0。flops = 0# 这段代码的目的是尝试计算模型或操作的浮点运算次数,这是衡量模型计算复杂性和资源消耗的一个重要指标。通过这种方式,可以了解模型在前向和反向传播过程中的计算负载,从而优化模型性能和资源分配。# 如果 thop 库不可用或计算过程中出现异常,FLOPs 将被设置为 0,以避免错误的计算结果。# 这段代码是 profile 函数的核心部分,它负责测量模型或操作在前向和反向传播过程中的时间消耗、内存使用、参数数量等性能指标。# 计时和性能评估。# 开始一个 try 块,用于捕获在性能评估过程中可能出现的任何异常。try:# 重复测量。重复 n 次性能评估,以获得更稳定的结果。for _ in range(n):# 记录前向传播时间。记录当前时间作为前向传播的开始时间。# def time_sync(): -> 在 PyTorch 环境中提供一个准确的时间测量。 -> return time.time()t[0] = time_sync()# 执行模型或操作的前向传播。y = m(x)# 记录当前时间作为前向传播的结束时间。t[1] = time_sync()# 记录反向传播时间。# 尝试执行反向传播。try:# 如果输出 y 是列表,则对每个元素求和;否则直接对 y 求和。然后执行反向传播。(sum(yi.sum() for yi in y) if isinstance(y, list) else y).sum().backward()# 记录当前时间作为反向传播的结束时间。t[2] = time_sync()# 如果没有反向传播方法(例如,模型或操作不支持反向传播),则捕获异常并将 t[2] 设置为 nan 。except Exception: # no backward method# print(e) # for debugt[2] = float("nan")# 计算平均时间。# 计算前向传播的平均时间(以毫秒为单位)。tf += (t[1] - t[0]) * 1000 / n # ms per op forward# 计算反向传播的平均时间(以毫秒为单位)。tb += (t[2] - t[1]) * 1000 / n # ms per op backward# 记录内存使用。如果 CUDA 可用,计算当前保留的内存(以吉字节为单位)。mem = torch.cuda.memory_reserved() / 1e9 if torch.cuda.is_available() else 0 # (GB)# 记录输入和输出形状。获取输入 x 和输出 y 的形状,如果它们不是张量,则记录为 "list"。s_in, s_out = (tuple(x.shape) if isinstance(x, torch.Tensor) else "list" for x in (x, y)) # shapes# 记录参数数量。如果 m 是一个模块(例如 PyTorch 模型),计算其参数总数。p = sum(x.numel() for x in m.parameters()) if isinstance(m, nn.Module) else 0 # parameters# 记录日志信息。使用日志记录器记录 参数数量 、 GFLOPs 、 内存使用 、 前向传播时间 、 反向传播时间 、 输入 和 输出的形状 。LOGGER.info(f"{p:12}{flops:12.4g}{mem:>14.3f}{tf:14.4g}{tb:14.4g}{str(s_in):>24s}{str(s_out):>24s}")# 存储结果。将性能评估结果添加到 results 列表。results.append([p, flops, mem, tf, tb, s_in, s_out])# 异常处理。如果在性能评估过程中出现任何异常,记录异常信息,并将 None 添加到 results 列表。except Exception as e:LOGGER.info(e)results.append(None)# 内存清理。尝试收集未使用的内存。gc.collect() # attempt to free unused memory# 清空 CUDA 缓存,以释放未使用的内存。torch.cuda.empty_cache()# 返回结果。返回包含所有性能评估结果的 results 列表。return results# 这段代码的目的是为模型或操作提供详细的性能分析,包括参数数量、浮点运算次数(GFLOPs)、内存使用和时间消耗,这对于优化模型性能和资源管理非常有用。通过这种方式,可以识别性能瓶颈和资源消耗较高的操作,从而进行针对性的优化。

# 这个方法的目的是为模型或操作提供详细的性能分析,包括参数数量、浮点运算次数(GFLOPs)、内存使用和时间消耗,这对于优化模型性能和资源管理非常有用。通过这种方式,可以识别性能瓶颈和资源消耗较高的操作,从而进行针对性的优化。29.class EarlyStopping:

# 这段代码定义了一个名为 EarlyStopping 的类,它用于实现早停(early stopping)策略,这是一种在训练机器学习模型时用于避免过拟合的技术。

# 类定义和初始化。

class EarlyStopping:# 当经过指定数量的 epoch 而没有改进时,提前停止训练的类。"""Early stopping class that stops training when a specified number of epochs have passed without improvement."""# 1.patience :一个整数,表示在模型性能停止提升后等待的epoch数,如果在这段时间内性能没有改善,则停止训练。def __init__(self, patience=50):# 初始化提前停止对象。"""Initialize early stopping object.Args:patience (int, optional): Number of epochs to wait after fitness stops improving before stopping."""# 初始化 best_fitness 为 0.0(通常用于存储最佳模型性能,如 mAP)。self.best_fitness = 0.0 # i.e. mAP# 初始化 best_epoch 为 0,用于记录最佳模型性能发生的epoch。self.best_epoch = 0# 设置 patience 属性,如果 patience 参数未提供,则默认为 50 或无穷大(如果设置为 None )。self.patience = patience or float("inf") # epochs to wait after fitness stops improving to stop# 初始化 possible_stop 为 False ,表示是否可能在下一个epoch停止训练。self.possible_stop = False # possible stop may occur next epoch# 调用方法 __call__ 。# 这段代码是 EarlyStopping 类中的 __call__ 方法的实现,它用于确定是否应该根据早停策略停止训练。# 这个方法使得 EarlyStopping 类的实例可以像函数一样被调用,接受当前的训练 epoch 和模型的 fitness 值作为参数。# 参数说明 :# 1.epoch :当前训练的轮数(整数)。# 2.fitness :当前轮的训练效果指标值(浮点数)。def __call__(self, epoch, fitness):# 检查是否停止训练。"""Check whether to stop training.Args:epoch (int): Current epoch of trainingfitness (float): Fitness value of current epochReturns:(bool): True if training should stop, False otherwise"""# 检查 fitness 是否为 None 。# 如果 fitness 为 None ,则返回 False ,表示不停止训练。这通常发生在没有验证集( val=False )的情况下。if fitness is None: # check if fitness=None (happens when val=False)return False# 更新最佳 fitness 。# 如果当前 fitness 值大于或等于之前记录的最佳 fitness 值,则更新 best_epoch 和 best_fitness 。if fitness >= self.best_fitness: # >= 0 to allow for early zero-fitness stage of trainingself.best_epoch = epochself.best_fitness = fitness# 计算没有改善的轮数。计算从最佳 fitness 以来经过的轮数。delta = epoch - self.best_epoch # epochs without improvement# 设置可能停止的标志。如果经过的轮数接近 patience 值,则设置 possible_stop 为 True 。self.possible_stop = delta >= (self.patience - 1) # possible stop may occur next epoch# 确定是否停止训练。如果经过的轮数超过 patience 值,则设置 stop 为 True ,表示应该停止训练。stop = delta >= self.patience # stop training if patience exceeded# 记录日志信息。# 如果 stop 为 True ,则使用 LOGGER 记录一条信息级别的日志,说明训练提前停止,并提供如何更新 EarlyStopping 参数的说明。if stop:prefix = colorstr("EarlyStopping: ")LOGGER.info(f"{prefix}Training stopped early as no improvement observed in last {self.patience} epochs. "f"Best results observed at epoch {self.best_epoch}, best model saved as best.pt.\n"f"To update EarlyStopping(patience={self.patience}) pass a new patience value, "f"i.e. `patience=300` or use `patience=0` to disable EarlyStopping.")# 返回是否停止的结果。返回 stop 值,表示是否停止训练。return stop# __call__ 方法提供了一种机制,通过监控模型在训练过程中的性能来决定是否提前停止训练。这种方法有助于避免过拟合,节省计算资源,并确保模型在验证集上的性能不再提升时及时停止训练。通过记录详细的日志信息,用户可以了解训练停止的原因和最佳模型的性能。

# EarlyStopping 类提供了一种机制,通过监控模型在验证集上的性能来提前停止训练,以防止过拟合。这在机器学习和深度学习中是一种常见的正则化技术。通过动态监控模型性能并在性能不再提升时停止训练,可以节省计算资源并提高模型的泛化能力。

相关文章:

YOLOv8-ultralytics-8.2.103部分代码阅读笔记-torch_utils.py

torch_utils.py ultralytics\utils\torch_utils.py 目录 torch_utils.py 1.所需的库和模块 2.def torch_distributed_zero_first(local_rank: int): 3.def smart_inference_mode(): 4.def autocast(enabled: bool, device: str "cuda"): 5.def get_cpu_i…...

Java中的数据存储结构解析与应用

一、引言 在Java编程中,数据存储结构是程序设计的基础。合理选择和使用数据结构可以提高程序的性能和可维护性。本文将带您了解Java中的各种数据存储结构,并探讨其优缺点及适用场景。 二、基本数据类型 Java提供了8种基本数据类型,分别是b…...

【链表】力扣 141. 环形链表

一、题目 二、思路 龟兔进行赛跑 龟的速度是 1,兔的速度是 2龟兔从同一起点出发,若 龟追上兔 则说明 有环 存在;若追不上,则说明无环。 三、代码 /*** Definition for singly-linked list.* class ListNode {* int val;* …...

Hbase整合Mapreduce案例2 hbase数据下载至hdfs中——wordcount

目录 整合结构准备数据下载pom.xmlMain.javaReduce.javaMap.java操作 总结 整合结构 和案例1的结构差不多,Hbase移动到开头,后面跟随MR程序。 因此对于输入的K1 V1会进行一定的修改 准备 在HBASE中创建表,并写入数据 create "wunaii…...

diff算法

vue的diff算法详解 vue: diff 算法是一种通过同层的树节点进行比较的高效算法 其有两个特点: 比较只会在同层级进行, 不会跨层级比较 在diff比较的过程中,循环从两边向中间比较 diff 算法在很多场景下都有应用,在 vue 中&…...

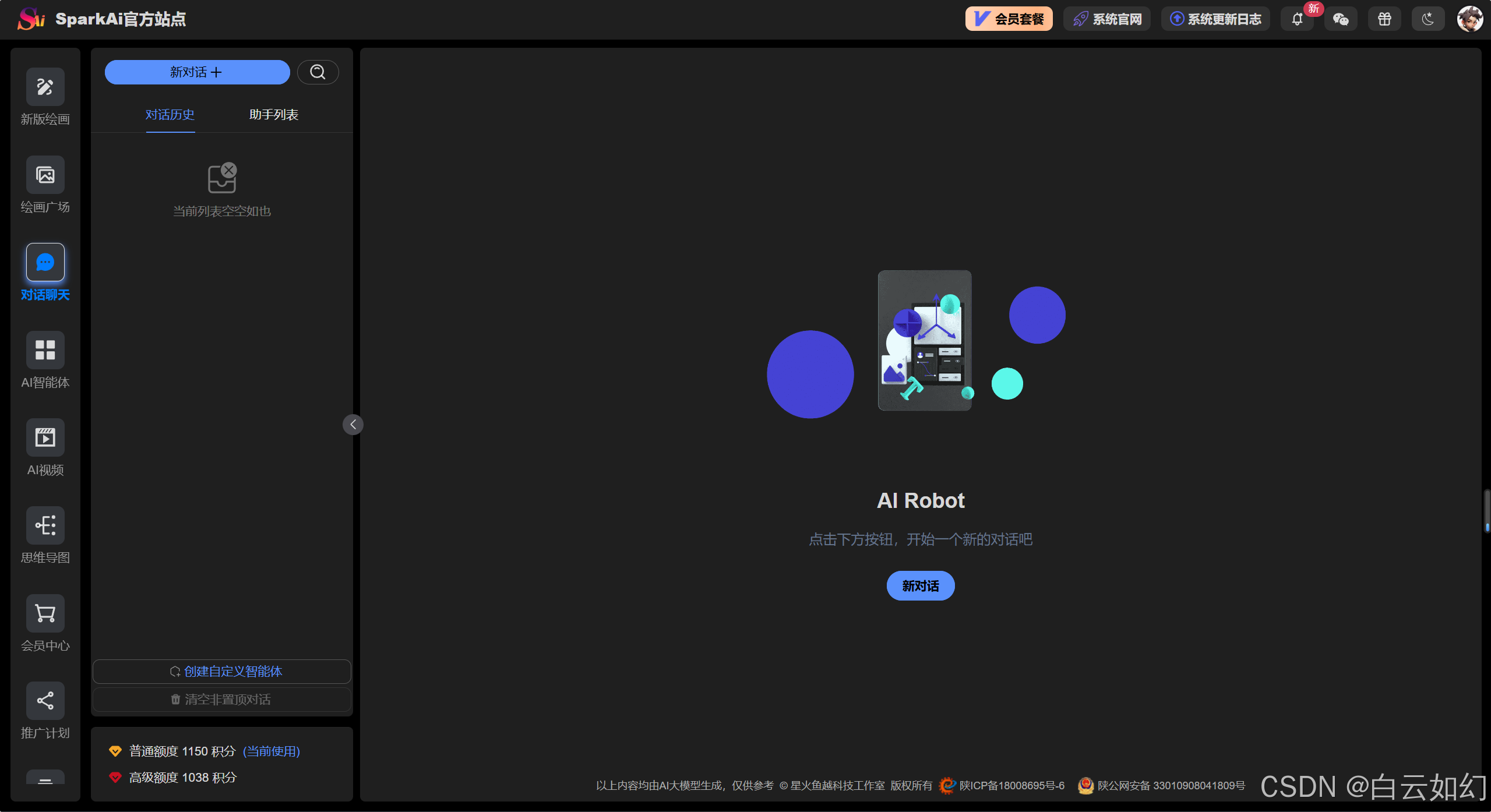

最新AI问答创作运营系统(SparkAi系统),GPT-4.0/GPT-4o多模态模型+联网搜索提问+问答分析+AI绘画+管理后台系统

目录 一、人工智能 系统介绍文档 二、功能模块介绍 系统快速体验 三、系统功能模块 3.1 AI全模型支持/插件系统 AI大模型 多模态模型文档分析 多模态识图理解能力 联网搜索回复总结 3.2 AI智能体应用 3.2.1 AI智能体/GPTs商店 3.2.2 AI智能体/GPTs工作台 3.2.3 自…...

docker应用

docker version docker info docker images# 查看主机所以镜像 docker search# 搜索镜像 docker pull# 下载镜像 docker rmi# 删除镜像 docker tag 镜像名:版本 新镜像名:版本 # 复制镜像并改名 docker commit # 提交镜像 docker load -i /XXX/XXX.tar # 导入镜像 docker sav…...

COCO数据集理解

COCO(Common Objects in Context)数据集是一个用于计算机视觉研究的广泛使用的数据集,特别是在物体检测、分割和图像标注等任务中。COCO数据集由微软研究院开发,其主要特点包括: 丰富的标签:COCO数据集包含…...

C# 向上取整多种实现方法

1.使用 Math.Ceiling 方法: 在 C# 中,可以利用 System.Math 类下的 Math.Ceiling 方法来实现向上取整。它接受一个 double 或 decimal 类型的参数,并返回大于或等于该参数的最小整数(以 double 或 decimal 类型表示)。…...

Elastic Cloud Serverless:深入探讨大规模自动扩展和性能压力测试

作者:来自 Elastic David Brimley, Jason Bryan, Gareth Ellis 及 Stewart Miles 深入了解 Elasticsearch Cloud Serverless 如何动态扩展以处理海量数据和复杂查询。我们探索其在实际条件下的性能,深入了解其可靠性、效率和可扩展性。 简介 Elastic Cl…...

新一代零样本无训练目标检测

🏡作者主页:点击! 🤖编程探索专栏:点击! ⏰️创作时间:2024年12月2日21点02分 神秘男子影, 秘而不宣藏。 泣意深不见, 男子自持重, 子夜独自沉。 论文链接 点击开启你的论文编程之旅h…...

es 3期 第13节-多条件组合查询实战运用

#### 1.Elasticsearch是数据库,不是普通的Java应用程序,传统数据库需要的硬件资源同样需要,提升性能最有效的就是升级硬件。 #### 2.Elasticsearch是文档型数据库,不是关系型数据库,不具备严格的ACID事务特性ÿ…...

全局token验证

全局token验证 简介 通俗地说,JWT的本质就是一个字符串,它是将用户信息保存到一个Json字符串中,然后进行编码后得到一个JWT token,并且这个JWT token带有签名信息,接收后可以校验是否被篡改,所以可以用…...

实时美颜技术详解:美颜SDK与直播APP开发实践

通过集成美颜SDK(软件开发工具包),开发者能够轻松为直播APP提供实时美颜效果,改善用户的直播体验。本篇文章,小编将深入探讨实时美颜技术,重点分析美颜SDK的核心技术及其在直播APP中的应用实践。 一、实时…...

电子应用设计方案-41:智能微波炉系统方案设计

智能微波炉系统方案设计 一、引言 随着科技的不断进步,人们对于厨房电器的智能化需求日益增长。智能微波炉作为现代厨房中的重要设备,应具备更便捷、高效、个性化的功能,以满足用户多样化的烹饪需求。 二、系统概述 1. 系统目标 - 提供精确…...

P5736 【深基7.例2】质数筛

题目描述 输入 𝑛个不大于 105 的正整数。要求全部储存在数组中,去除掉不是质数的数字,依次输出剩余的质数。 输入格式 第一行输入一个正整数 𝑛,表示整数个数。 第二行输入 𝑛 个正整数 𝑎…...

数据结构初阶1 时间复杂度和空间复杂度

本章重点 算法效率时间复杂度空间复杂度常见时间复杂度以及复杂度OJ练习 1.算法效率 1.1 如何衡量一个算法的好坏 如何衡量一个算法的好坏呢?比如对于以下斐波那契数列: long long Fib(int N) { if(N < 3) return 1;return Fib(N-1) Fib(N-2); }斐…...

E130 PHP+MYSQL+动漫门户网站的设计与实现 视频网站系统 在线点播视频 源码 配置 文档 全套资料

动漫门户网站 1.摘要2. 开发背景和意义3.项目功能4.界面展示5.源码获取 1.摘要 21世纪是信息的时代,随着信息技术与网络技术的发展,其已经渗透到人们日常生活的方方面面,与人们是日常生活已经建立密不可分的联系。本网站利用Internet网络, M…...

OSCP - Proving Grounds - Fanatastic

主要知识点 CVE-2021-43798漏洞利用 具体步骤 执行nmap 扫描,22/3000/9090端口开放,应该是ssh,grafana 和Prometheus Nmap scan report for 192.168.52.181 Host is up (0.00081s latency). Not shown: 65532 closed tcp ports (reset) PORT STA…...

ArcMap 分享统计点要素、路网、降雨量等功能操作

ArcMap 分享统计点要素、路网等功能等功能操作今天进行 一、按格网统计点要素 1、创建公里网格统计单元 点击确定后展示 打开连接 点击后 展示 2、处理属性 1)查看属性表 每个小格都统计出了点的数量 2)查看属性 符号系统 点击应用后展示结果&#x…...

深入剖析AI大模型:大模型时代的 Prompt 工程全解析

今天聊的内容,我认为是AI开发里面非常重要的内容。它在AI开发里无处不在,当你对 AI 助手说 "用李白的风格写一首关于人工智能的诗",或者让翻译模型 "将这段合同翻译成商务日语" 时,输入的这句话就是 Prompt。…...

Redis相关知识总结(缓存雪崩,缓存穿透,缓存击穿,Redis实现分布式锁,如何保持数据库和缓存一致)

文章目录 1.什么是Redis?2.为什么要使用redis作为mysql的缓存?3.什么是缓存雪崩、缓存穿透、缓存击穿?3.1缓存雪崩3.1.1 大量缓存同时过期3.1.2 Redis宕机 3.2 缓存击穿3.3 缓存穿透3.4 总结 4. 数据库和缓存如何保持一致性5. Redis实现分布式…...

遍历 Map 类型集合的方法汇总

1 方法一 先用方法 keySet() 获取集合中的所有键。再通过 gey(key) 方法用对应键获取值 import java.util.HashMap; import java.util.Set;public class Test {public static void main(String[] args) {HashMap hashMap new HashMap();hashMap.put("语文",99);has…...

测试markdown--肇兴

day1: 1、去程:7:04 --11:32高铁 高铁右转上售票大厅2楼,穿过候车厅下一楼,上大巴车 ¥10/人 **2、到达:**12点多到达寨子,买门票,美团/抖音:¥78人 3、中饭&a…...

[10-3]软件I2C读写MPU6050 江协科技学习笔记(16个知识点)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16...

现代密码学 | 椭圆曲线密码学—附py代码

Elliptic Curve Cryptography 椭圆曲线密码学(ECC)是一种基于有限域上椭圆曲线数学特性的公钥加密技术。其核心原理涉及椭圆曲线的代数性质、离散对数问题以及有限域上的运算。 椭圆曲线密码学是多种数字签名算法的基础,例如椭圆曲线数字签…...

USB Over IP专用硬件的5个特点

USB over IP技术通过将USB协议数据封装在标准TCP/IP网络数据包中,从根本上改变了USB连接。这允许客户端通过局域网或广域网远程访问和控制物理连接到服务器的USB设备(如专用硬件设备),从而消除了直接物理连接的需要。USB over IP的…...

【Android】Android 开发 ADB 常用指令

查看当前连接的设备 adb devices 连接设备 adb connect 设备IP 断开已连接的设备 adb disconnect 设备IP 安装应用 adb install 安装包的路径 卸载应用 adb uninstall 应用包名 查看已安装的应用包名 adb shell pm list packages 查看已安装的第三方应用包名 adb shell pm list…...

群晖NAS如何在虚拟机创建飞牛NAS

套件中心下载安装Virtual Machine Manager 创建虚拟机 配置虚拟机 飞牛官网下载 https://iso.liveupdate.fnnas.com/x86_64/trim/fnos-0.9.2-863.iso 群晖NAS如何在虚拟机创建飞牛NAS - 个人信息分享...

STM32---外部32.768K晶振(LSE)无法起振问题

晶振是否起振主要就检查两个1、晶振与MCU是否兼容;2、晶振的负载电容是否匹配 目录 一、判断晶振与MCU是否兼容 二、判断负载电容是否匹配 1. 晶振负载电容(CL)与匹配电容(CL1、CL2)的关系 2. 如何选择 CL1 和 CL…...