超越传统AI 新型多智能体系统MESA,探索效率大幅提升

探索多智能体强化学习的协同元探索 —— MESA 算法深度解读在多智能体强化学习(MARL)的征途中,如何高效探索以发现最优策略一直是研究者们面临的挑战。特别是在稀疏奖励的环境中,这一问题变得更加棘手。《MESA: Cooperative Meta-Exploration in Multi-Agent Learning through Exploiting State-Action Space Structure》这篇论文为我们带来了一种新颖的解决方案——MESA算法,它通过利用状态-动作空间的结构,实现了多智能体间的协同元探索,显著提升了在复杂任务中的探索效率。Zhicheng Zhang、Yancheng Liang、Yi Wu和Fei Fang等研究者们精心设计的MESA算法,在多步矩阵游戏和连续控制任务中展现了其卓越的性能。它不仅能够有效地促进智能体在测试任务中的学习,还能泛化至更具挑战性的未见任务。

通过这篇文章,您将获得:

高效探索策略:了解MESA如何通过元探索方法提升多智能体学习的探索效率。

结构化学习方法:探索MESA如何识别高奖励的状态-动作子空间,并训练多样化的探索策略。

实际应用案例:通过MESA在多智能体粒子环境和MuJoCo环境中的实验,见证其在实际应用中的显著成效。

引言:多智能体系统中的探索挑战

在多智能体系统(MAS)中,探索是一个核心问题,尤其是在合作或竞争环境下。有效的探索策略可以显著提高学习效率,帮助智能体更快地适应环境并找到最优策略。然而,多智能体环境的复杂性,如状态空间的指数增长和部分可观测性,使得传统的单智能体探索方法往往不再适用。

在多智能体环境中,每个智能体的行为不仅影响自己的收益,还可能影响其他智能体的收益,这增加了探索的难度。例如,一个智能体的探索行为可能会导致环境状态变化,从而影响到其他智能体的决策。此外,智能体需要在探索新策略和利用已知策略之间找到平衡,这在多智能体设置中尤为复杂。

为了应对这些挑战,研究者们提出了多种多智能体探索策略,旨在通过协作或竞争来优化整体或个体的性能。这些方法通常需要在探索效率和计算复杂性之间做出权衡。有效的多智能体探索不仅能加速学习过程,还能在复杂的环境中促进更高级别的策略和协作形成。

论文基本信息

标题:MESA: Cooperative Meta-Exploration in Multi-Agent Learning through Exploiting State-Action Space Structure

作者:

- Zhicheng Zhang, Carnegie Mellon University, Pittsburgh, Pennsylvania, United States

- Yancheng Liang, University of Washington, Seattle, Washington, United States

- Yi Wu, Tsinghua University, Beijing, China

- Fei Fang, Carnegie Mellon University, Pittsburgh, Pennsylvania, United States

机构:

- Carnegie Mellon University

- University of Washington

- Tsinghua University

论文链接:https://arxiv.org/pdf/2405.00902.pdf

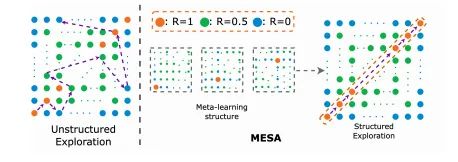

MESA方法概述

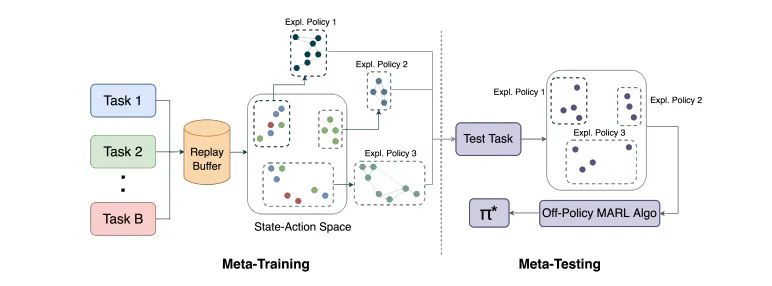

MESA(Cooperative Meta-Exploration in Multi-Agent Learning through Exploiting State-Action Space Structure)是一种针对多智能体学习的元探索方法,旨在通过利用状态-动作空间结构来提高探索效率。在多智能体强化学习(MARL)中,探索效率尤为关键,因为环境的复杂性和智能体间的交互增加了学习的难度。MESA通过在元训练阶段识别高奖励的状态-动作子空间,并训练一组多样化的探索策略来覆盖这一子空间,从而实现高效的探索。这些探索策略在元测试阶段被用来辅助智能体在新任务中的学习。

元训练阶段详解

1. 高奖励状态-动作子空间的识别

在元训练阶段的第一步,MESA需要确定哪些状态-动作对能够带来高奖励。这一过程涉及到在多个训练任务中收集数据,并从中筛选出奖励高于某个阈值的状态-动作对。这些被认为是有价值的状态-动作对将被存储在一个数据集M*中,用于后续的探索策略训练。对于目标导向的任务,这个阈值可以是达到目标状态的奖励。

2. 探索策略的训练和奖励机制

在识别了高奖励的状态-动作子空间后,MESA将训练一组探索策略来有效覆盖这一子空间。这些探索策略的训练使用了基于距离高奖励子空间的距离来诱导的奖励机制。具体来说,如果一个访问的状态-动作对足够接近已识别的高奖励子空间(即,它与子空间中的某个点的距离小于某个阈值ε),它将获得一个正的派生奖励。为了鼓励探索策略覆盖更广泛的子空间并避免模式崩溃,MESA采用了一种奖励分配方案,确保对相似的状态-动作对的重复访问会得到递减的奖励。

通过这种方式,MESA不仅提高了探索的效率,还通过元学习框架使得智能体能够在面对新任务时迅速适应,展现出良好的泛化能力。这一方法已在多种任务中得到了验证,包括矩阵攀爬游戏和连续控制任务,与现有的多智能体学习和探索算法相比,MESA显示出了优越的性能。

元测试阶段应用

在元测试阶段,MESA(Cooperative Meta-Exploration in Multi-Agent Learning through Exploiting State-Action Space Structure)利用在元训练阶段学习到的探索策略来辅助多智能体在未见过的任务中的学习。这些探索策略是从一组训练任务中学习得到的,这些任务在状态-动作空间中具有内在的结构特征。在元测试阶段,MESA通过随机选择已学习的探索策略来收集有价值的经验,从而帮助智能体更有效地学习良好的联合策略。

1. 探索策略的应用:在每个回合中,MESA以一定的概率执行一个随机选取的探索策略。这些探索策略在初始阶段提供更多的回合,以帮助智能体快速适应新环境,随后逐渐减少探索策略的使用,转而让智能体依赖其自身的学习成果。

2. 策略的效果评估:MESA的探索策略在多个环境中表现出色,包括矩阵攀登游戏及其多阶段变体和连续控制任务。这些策略不仅提高了探索效率,还显示出对未见测试任务的泛化能力,这些测试任务比任何训练任务都要具有挑战性。

实验设计与评估

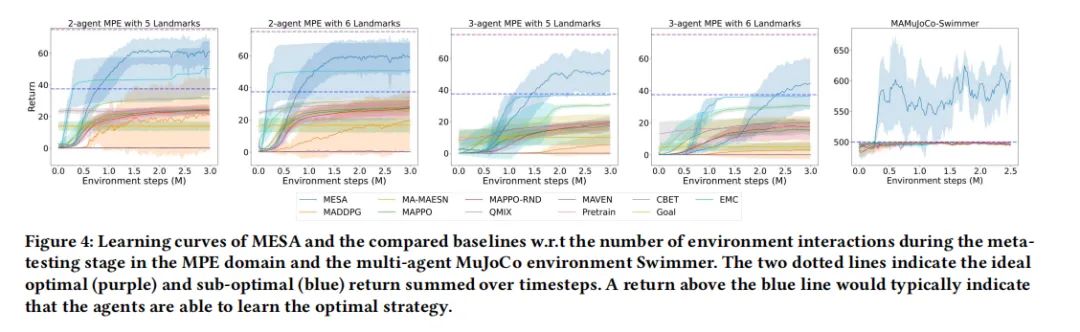

MESA的实验设计旨在评估元学习探索策略在新任务中的表现,并与其他多智能体学习和探索算法进行比较。实验在不同的环境中进行,包括矩阵攀登游戏的变体、多智能体粒子环境(MPE)和多智能体MuJoCo基准测试。

1. 实验设置:实验比较了MESA与其他几种多智能体强化学习算法,如MADDPG、MAPPO和QMIX,以及几种探索算法,如MAVEN和基于RND的探索。此外,还测试了几种采用类似元训练阶段的基线方法,包括未条件共享策略和目标条件策略。

2. 评估方法:评估主要关注探索策略在元测试阶段的表现,特别是它们在新采样任务中的探索效率。通过与基线方法的比较,展示了MESA在攀登游戏变体和高维领域任务中的优势。此外,还研究了这些探索策略在更具挑战性的测试任务分布中的泛化性能。

通过这些详尽的实验设计和评估,MESA证明了其在多智能体学习中应用元探索方法的有效性,尤其是在处理结构化探索任务和高维控制问题时的优势。

结果分析与讨论

1. MESA在Climb Game变体中的表现

MESA在Climb Game的变体中表现出色。在单步Climb Game中,MESA能够在一些更困难的任务中找到最优解,而其他基线方法则几乎在所有任务中停留在次优解。在多阶段Climb Game中,由于任务空间指数级增长,MESA的表现远超其他算法。通过已学习的探索策略,MESA能够迅速学习每个阶段的最优联合动作,避免陷入次优解。

2. MESA在多智能体MuJoCo环境中的应用

在多智能体MuJoCo环境中,MESA同样展现了优异的性能。特别是在2-agent Swimmer环境中,MESA通过学习的探索策略,频繁地达到目标角度,显著优于其他基线方法。这一环境极为复杂,因为智能体很可能收敛到次优的奖励,但MESA通过有效的探索策略,成功地学习到了最终策略,频繁地达到目标状态。

3. MESA的泛化能力评估

MESA在未见测试任务上的泛化能力表现突出。尤其是在任务分布更具挑战性的情况下,MESA展现了良好的零样本泛化能力。通过在简单任务上训练的探索策略,MESA能够在更难的测试任务上加速训练性能,连续达到高奖励区域,而标准的MADDPG算法则只能学习到次优平衡。

MESA方法的优势与局限

优势

- 结构化探索策略:MESA通过在训练阶段识别高奖励的状态-动作子空间,并训练一组探索策略来覆盖这一子空间,从而实现高效的结构化探索。

- 优异的泛化能力:MESA展现了在从简单任务到复杂任务的泛化能力,这得益于其能够利用训练任务中学到的结构化探索策略。

- 与现有算法的兼容性:MESA可以与任何离策略的多智能体强化学习算法结合使用,提高了其适用性。

局限

- 依赖于任务结构的显式识别:MESA的性能高度依赖于在训练阶段正确识别出高奖励的状态-动作子空间。如果这一子空间识别不准确,可能会影响探索策略的有效性。

- 计算资源需求:由于需要在多个任务上训练探索策略,MESA可能需要较多的计算资源,尤其是在任务空间较大时。

- 对高奖励状态的依赖:MESA的探索策略训练依赖于高奖励状态的采集,这在奖励稀疏的环境中可能是一个挑战。

总结与未来展望

在本文中,我们介绍了一种新的多智能体元探索方法MESA(Cooperative Meta-Exploration in Multi-Agent Learning through Exploiting State-Action Space Structure),该方法通过利用状态-动作空间结构来提高多智能体学习的探索效率。MESA框架在元训练阶段通过一系列训练任务学习探索策略,并在元测试阶段利用这些策略帮助智能体在未见过的任务中进行学习。我们的实验结果显示,MESA在多种环境和任务中均优于现有的多智能体学习和探索算法,尤其是在需要协调探索的复杂环境中。

1. 主要贡献

MESA的主要贡献在于其能够有效地识别和利用训练任务中的高奖励状态-动作子空间,从而训练出一组多样化的探索策略。这些策略在元测试阶段被用来引导智能体探索新任务,显著提高了学习效率和策略性能。此外,MESA展示了良好的泛化能力,能够将在相对简单的任务中学到的探索策略成功应用于更复杂的测试任务,从而解决了多智能体系统中的探索难题。

2. 实验验证

通过在不同的游戏和控制任务中进行广泛的实验,包括Climb Game变体和多智能体MuJoCo环境,MESA不仅在学习效率上超过了其他基线方法,还在多阶段游戏和高维任务中表现出卓越的性能。这些结果验证了MESA探索策略的有效性和适应性。

3. 未来工作

尽管MESA已经取得了一定的成功,但仍有一些潜在的改进空间和未来的研究方向。例如,如何进一步优化探索策略的学习过程,减少所需的训练任务数量,以及如何更好地处理动态变化的环境和任务。此外,探索如何将MESA扩展到非合作或竞争性的多智能体环境中也是未来研究的一个重要方向。

总之,MESA为解决多智能体系统中的协同探索问题提供了一个有效的框架,并为未来在更广泛的应用领域中推广元探索策略奠定了基础。我们期待看到MESA在更多实际应用中的表现,并希望它能激发更多关于多智能体学习和探索的研究。

相关文章:

超越传统AI 新型多智能体系统MESA,探索效率大幅提升

探索多智能体强化学习的协同元探索 —— MESA 算法深度解读在多智能体强化学习(MARL)的征途中,如何高效探索以发现最优策略一直是研究者们面临的挑战。特别是在稀疏奖励的环境中,这一问题变得更加棘手。《MESA: Cooperative Meta-…...

[SWPU 2019]神奇的二维码、buuctf部分web题

目录 [SWPU 2019]神奇的二维码 [LitCTF 2023]Http pro max plus [SWPUCTF 2021 新生赛]finalrce [鹏城杯 2022]简单包含 [SWPUCTF 2022 新生赛]ez_ez_php(revenge) [GKCTF 2020]cve版签到 cve-2020-7066: [SWPU 2019]神奇的二维码 解码看看,是…...

Python正则表达式匹配中文:深入解析与实战应用

Python正则表达式匹配中文:深入解析与实战应用 在Python编程中,正则表达式是一种强大的工具,它可以用来处理和分析字符串数据。对于需要处理包含中文字符的文本数据的场景,掌握如何使用正则表达式匹配中文就显得尤为重要。本文将…...

实例Python对比两个word文档并找出不同

首先确保已经有了安装包docx 与 difflib,如果没有先用pip命令安装如下 pip install python-docx案例代码 import docx import difflib import os 在文件目录中存在两个待对比的word文档,必须是docx格式 # 获取文档对象 # path input(请输入文件目录:…...

)

2.1 QT随手简记(三)

新建QT工程 1.方法 第一种:点击new project按钮,弹出对话框,新建即可 第二种;点击文件菜单,选择新建文件或者工程 2.QT工程文件介绍 (1).pro文件 --》QT工程配置文件 QT …...

TechM-技术网站

介绍 你将为⼀个技术社区设计并实现⼀个官⽹。该社区旨在为软件⼯程师、开发⼈员和技术 爱好者提供⼀个交流平台,分享最新的技术动态、⽂章、项⽬案例。 项目模块 项目分为三个模块 : 主页展示模块,文章详情模块,文章专栏模块…...

SpringBoot: 使用GraalVM编译native应用

曾今Go语言里让我最艳羡的两个特性,一个是Goroutine,一个是native编译。 Java 21的虚线程实现了类似Goroutine的能力。Spring Boot 3.x开始提供了GraalVM的支持,现在Spring Boot也能打包成native文件了。 这一篇文章的目标是用一个案例讲解如…...

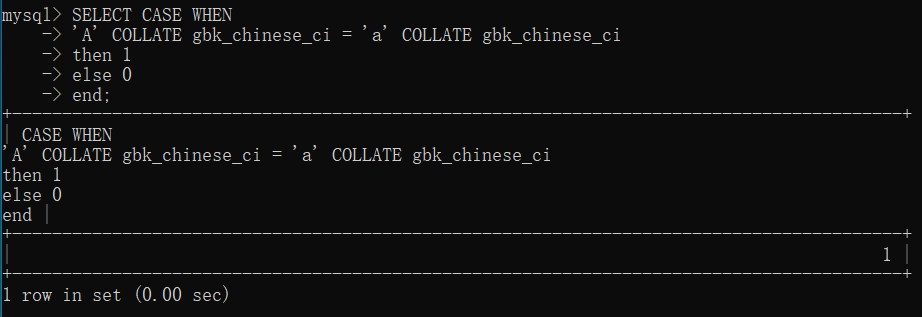

9. MySQL事务、字符集

文章目录 【 1. 事务 Transaction 】1.1 事务的基本原理1.2 MySQL 执行事务的语法和流程1.2.1 开始事务1.2.2 提交事务1.2.3 回滚(撤销)事务实例1:一致性实例2:原子性 【 2. 字符集 和 校对规则 】2.1 基本原理2.2 查看字符集查看…...

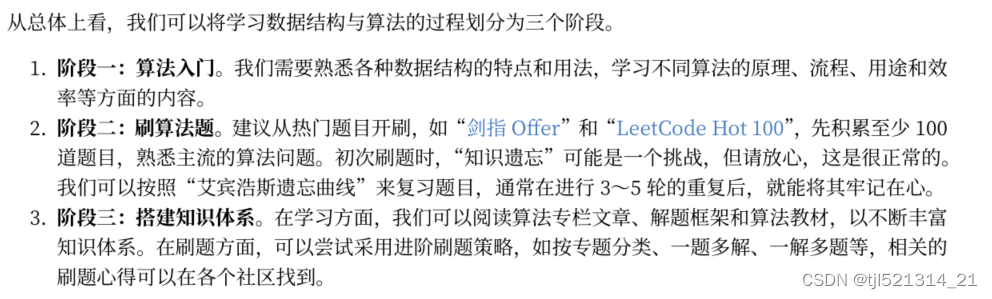

为什么要学习数据结构和算法

前言 控制专业转码学习记录,本科没学过这门课,但是要从事软件行业通过相关面试笔试基础还是要打牢固的,所以通过写博客记录一下。 必要性 1.越是厉害的公司,越是注重考察数据结构与算法这类基础知识 2.作为业务开发,…...

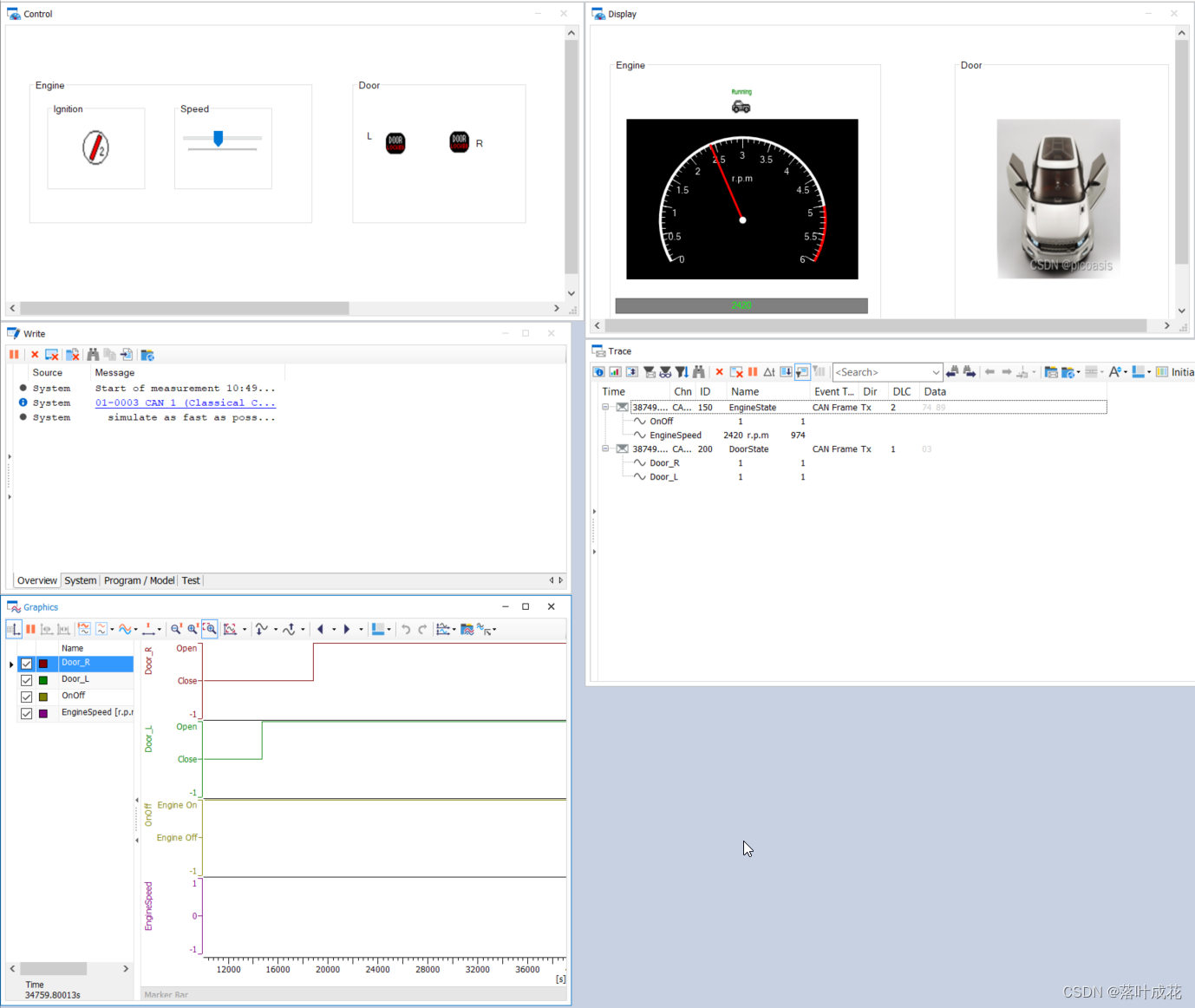

CANoe仿真工程Switch控件关联dbc信号出现的问题及解决思路

小白学习CANoe仿真,参考CANoe-第2个仿真工程-XVehicle—1总线数据库设计(思路)_canoe vehicle-CSDN博客 CANoe-第2个仿真工程-XVehicle1总线数据库设计(操作)_canoe factor 参数什么意思-CSDN博客CANoe-第2个仿真工程…...

用开源模型MusicGen制作六一儿童节专属音乐

使用的是开源模型MusicGen,它可以根据文字描述或者已有旋律生成高质量的音乐(32kHz),其原理是通过生成Encodec token然后再解码为音频,模型利用EnCodec神经音频编解码器来从原始波形中学习离散音频token。EnCodec将音频信号映射到一个或多个并…...

Ps:批处理

Ps菜单:文件/自动/批处理 Automate/Batch 批处理 Batch命令可以对一个文件夹中的文件执行事先创建的动作 Actions,从而快速地完成大量的重复性操作,提升工作效率。 提示 1: 可以从 Adobe Bridge 中调用 Photoshop 的批处理命令。 …...

前端框架中的虚拟DOM和实际DOM之间的关系

聚沙成塔每天进步一点点 本文回顾 ⭐ 专栏简介前端框架中的虚拟DOM和实际DOM之间的关系1. 实际DOM(Real DOM)1.1 定义1.2 特点 2. 虚拟DOM(Virtual DOM)2.1 定义2.2 特点 3. 虚拟DOM的工作流程3.1 创建虚拟DOM3.2 比较虚拟DOM&…...

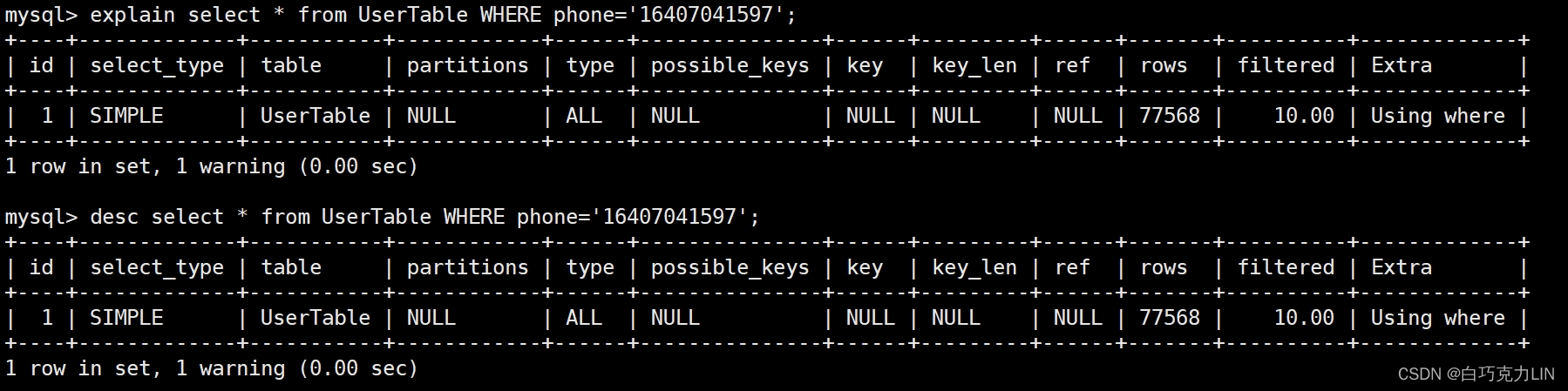

MySQL进阶——SQL性能分析

在上篇文章我们学习了MySQL进阶——存储引擎,这篇文章学习MySQL进阶——SQL性能分析。 SQL性能分析主要是从SQL语句执行频率、耗时时间、CPU使用情况和执行时表连接情况进行分析,常用的方法工具有:SQL执行频率、慢查询日志、profile详情和ex…...

在RT-Thread下为MPU手搓以太网MAC驱动-4

文章目录 MAC驱动里面对MDIO的支持MAC驱动与MDIO总线 这是个人驱动开发过程中做的一些记录,仅代表个人意见和理解,不喜勿喷 MAC驱动需要支持不同的PHY芯片 MAC驱动里面对MDIO的支持 在第一篇文章中提到对MAC设备做出了抽象,其中MAC抽象里面有…...

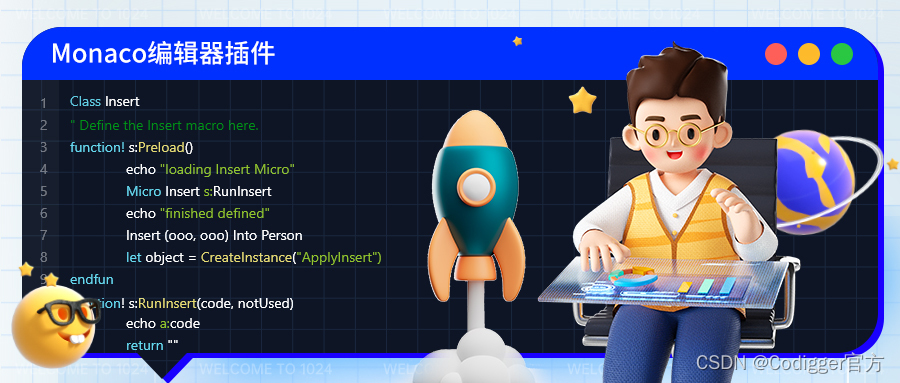

可的哥(Codigger)推出Monaco编辑器插件,提升编程体验

Monaco编辑器,作为业界领先的代码编辑器,在编程体验中发挥着不可或缺的重要作用,能够在多种编程语言和开发环境中表现出色,为开发者提供高效、便捷的编程环境。可的哥(Codigger)在应用商店上线Monaco编辑器…...

为什么选择mobx

对于React而言,大家熟能而详的是redux,但我们的项目用的是mobx,接下来就让我给你详细说下它的优势和不足,可以参考。 MobX是什么? MobX 是一种简单易用的状态管理库,它采用基于观察者的模式,可…...

如何解决段转储问题

非常恶心 ,这个问题困了我一个月,怀疑过代码有问题 ,怀疑过数据集没处理好,怀疑过环境没有配置好,尝试改动,跑过很多次,还是段转储报错卡住。。。 然后一个月荒废,打算放弃这个模型…...

【杂谈】AIGC之ChatGPT-与智能对话机器人的奇妙对话之旅

与智能对话机器人的奇妙对话之旅 引言 在数字时代的浪潮中,ChatGPT如同一位智慧的旅伴,它不仅能够与我们畅谈古今,还能解答我们的疑惑,成为我们探索知识海洋的得力助手。今天,就让我们走进ChatGPT的世界,…...

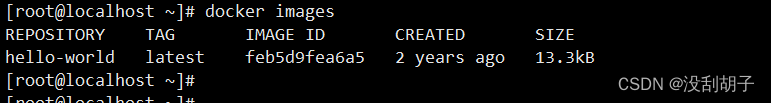

CentOS7配置国内清华源并安装docker-ce以及配置docker加速

说明 由于国内访问国外的网站包括docker网站,由于种种的原因经常打不开,或无法访问,所以替换成国内的软件源和国内镜像就是非常必要的了,这里整理了我安装配置的基本的步骤。 国内的软件源有很多,这里选择清华源作为…...

)

uniapp 对接腾讯云IM群组成员管理(增删改查)

UniApp 实战:腾讯云IM群组成员管理(增删改查) 一、前言 在社交类App开发中,群组成员管理是核心功能之一。本文将基于UniApp框架,结合腾讯云IM SDK,详细讲解如何实现群组成员的增删改查全流程。 权限校验…...

大数据学习栈记——Neo4j的安装与使用

本文介绍图数据库Neofj的安装与使用,操作系统:Ubuntu24.04,Neofj版本:2025.04.0。 Apt安装 Neofj可以进行官网安装:Neo4j Deployment Center - Graph Database & Analytics 我这里安装是添加软件源的方法 最新版…...

ES6从入门到精通:前言

ES6简介 ES6(ECMAScript 2015)是JavaScript语言的重大更新,引入了许多新特性,包括语法糖、新数据类型、模块化支持等,显著提升了开发效率和代码可维护性。 核心知识点概览 变量声明 let 和 const 取代 var…...

解锁数据库简洁之道:FastAPI与SQLModel实战指南

在构建现代Web应用程序时,与数据库的交互无疑是核心环节。虽然传统的数据库操作方式(如直接编写SQL语句与psycopg2交互)赋予了我们精细的控制权,但在面对日益复杂的业务逻辑和快速迭代的需求时,这种方式的开发效率和可…...

YSYX学习记录(八)

C语言,练习0: 先创建一个文件夹,我用的是物理机: 安装build-essential 练习1: 我注释掉了 #include <stdio.h> 出现下面错误 在你的文本编辑器中打开ex1文件,随机修改或删除一部分,之后…...

大数据零基础学习day1之环境准备和大数据初步理解

学习大数据会使用到多台Linux服务器。 一、环境准备 1、VMware 基于VMware构建Linux虚拟机 是大数据从业者或者IT从业者的必备技能之一也是成本低廉的方案 所以VMware虚拟机方案是必须要学习的。 (1)设置网关 打开VMware虚拟机,点击编辑…...

React---day11

14.4 react-redux第三方库 提供connect、thunk之类的函数 以获取一个banner数据为例子 store: 我们在使用异步的时候理应是要使用中间件的,但是configureStore 已经自动集成了 redux-thunk,注意action里面要返回函数 import { configureS…...

网站指纹识别

网站指纹识别 网站的最基本组成:服务器(操作系统)、中间件(web容器)、脚本语言、数据厍 为什么要了解这些?举个例子:发现了一个文件读取漏洞,我们需要读/etc/passwd,如…...

Python+ZeroMQ实战:智能车辆状态监控与模拟模式自动切换

目录 关键点 技术实现1 技术实现2 摘要: 本文将介绍如何利用Python和ZeroMQ消息队列构建一个智能车辆状态监控系统。系统能够根据时间策略自动切换驾驶模式(自动驾驶、人工驾驶、远程驾驶、主动安全),并通过实时消息推送更新车…...

深入理解Optional:处理空指针异常

1. 使用Optional处理可能为空的集合 在Java开发中,集合判空是一个常见但容易出错的场景。传统方式虽然可行,但存在一些潜在问题: // 传统判空方式 if (!CollectionUtils.isEmpty(userInfoList)) {for (UserInfo userInfo : userInfoList) {…...