基于Seatunnel最新2.3.5版本分布式集群安装部署指南(小白版)

基于Seatunnel2.3.5版本分布式集群安装部署

- 1.环境准备

- 2.JDK安装

- 3.Maven安装

- 4.Seatunnel在master节点安装部署配置

- 4.1.下载Seatunnel安装包

- 4.2.解压下载好的tar.gz包

- 4.3.下载连接器

- 4.4.配置Seatunnel的系统环境变量

- 4.5.配置 SeaTunnel Engine服务 JVM参数

- 4.6.配置文件中集群相关参数修改

- 4.6.1.SEATUNNEL配置文件修改

- 4.6.2.SEATUNNEL Engine服务配置文件修改

- 4.6.3.SEATUNNEL Engine客户端配置文件修改

- 5.分布式集群安装部署

- 5.1.创建日志目录

- 5.2.添加服务分发集群脚本

- 5.3.Seatunnel服务分发到集群其他主机

- 5.4.Seatunnel服务系统环境配置文件分发到集群其他主机

- 6.基于Spark/flink引擎的Seatunnel集群配置

- 7.Seatunnel集群常用管理命令

- 8.Seatunnel集群任务测试验证

1.环境准备

分布式集群基本环境准备,请参考我的另一篇文章dolphinscheduler分布式集群部署指南(小白版)中的环境准备小节进行配置

| IP地址 | 主机名 | 角色说明 |

|---|---|---|

| 10.10.3.10 | hadoop1001 | master节点 |

| 10.10.3.11 | hadoop1002 | slave节点 |

| 10.10.3.12 | hadoop1003 | slave节点 |

| 10.10.3.13 | hadoop1004 | slave节点 |

| 10.10.3.14 | hadoop1005 | slave节点 |

2.JDK安装

这部分跳过,很简单,基本随便找个博客文章照着配置就能搞定。

3.Maven安装

这部分跳过,很简单,基本随便找个博客文章照着配置就能搞定。

也可以不安装, 直接将Seatunnel2.3.5的源码下载到本地, 通过本地的mave把所有需要用到的连接器插件先下载下来再上传到安装目录下的$SEATUNNEL_HOME/lib目录和$SEATUNNEL_HOME/connectors/seatunnel目录下也是可以的, 这样就不需要安装Maven了。

4.Seatunnel在master节点安装部署配置

4.1.下载Seatunnel安装包

Seatunnel安装包下载

下载Seatunnel安装包上传到master节点hadoop1001的/opt/packages目录下

4.2.解压下载好的tar.gz包

tar -zxvf /opt/packages/apache-seatunnel-2.3.5-bin.tar.gz -C /opt/software

(3)查看Seatunnel使用的脚本

进入Seatunnel安装目录

cd /opt/software/apache-seatunnel-2.3.5

install-plugin.sh --安装连接器脚本seatunnel-cluster.sh -–集群模式启动脚本seatunnel-cluster.sh --本地模式启动脚本start-seatunnel-flink-13-connector-v2.sh –-flink1.2-1.4版本引擎启动脚本start-seatunnel-flink-15-connector-v2.sh –-flink1.5-1.6版本引擎启动脚本start-seatunnel-spark-2-connector-v2.sh –-saprk2.x版本引擎启动脚本start-seatunnel-spark-3-connector-v2.sh –-saprk3.x版本引擎启动脚本

4.3.下载连接器

这里可以直接将Seatunnel2.3.5的源码下载到本地,

修改install-plugin.cmd脚本,通过调用本地的mave把所有需要用到的连接器插件先下载下来再上传到安装目录下的$SEATUNNEL_HOME/lib目录和$SEATUNNEL_HOME/connectors/seatunnel目录下也可以

进入Seatunnel安装目录

cd /opt/software/apache-seatunnel-2.3.5

修改install-plugin.sh脚本, 切换成本地自定义安装的maven进行插件下载安装。

注意,如果你需要使用这种方式需要保证你的本地已经安装了apache-maven(>=3.6.3),并且已经给maven配置了系统环境变量。

下载完成之后将/opt/software/seatunnel-2.3.5/connectors下的所有的jar包都拷贝到·/opt/software/seatunnel-2.3.5/connectors/seatunnel目录下以及/opt/software/seatunnel-2.3.5/lib目录下

mkdir -p /opt/software/apache-seatunnel-2.3.5/connectors/seatunnel/cp /opt/software/apache-seatunnel-2.3.5/connectors/*.jar /opt/software/apache-seatunnel-2.3.5/connectors/seatunnel/cp /opt/software/apache-seatunnel-2.3.5/connectors/seatunnel/* /opt/software/seatunnel-2.3.5/lib/

操作完成结果如下:

/opt/software/apache-seatunnel-2.3.5/connectors/seatunnel/目录下如下图:

/opt/software/seatunnel-2.3.5/lib/目录下如下图:

4.4.配置Seatunnel的系统环境变量

- 编辑

/etc/profile.d/seatunnel.sh

vim /etc/profile.d/seatunnel.sh

- 在文件中添加以下内容配置环境变量

export SEATUNNEL_HOME=/opt/software/apache-seatunnel-2.3.5

export PATH=$PATH:$SEATUNNEL_HOME/bin

wq!保存退出, 一定要保存退出。

- 系统环境变量立即生效

source /etc/profile

- 验证系统环境变量是否生效

echo $SEATUNNEL_HOME

命令行输出如下,说明配置成功

4.5.配置 SeaTunnel Engine服务 JVM参数

将 JVM 参数选项添加到$SEATUNNEL_HOME/bin/seatunnel-cluster.sh文件的开头

JAVA_OPTS="-Xms2G -Xmx2G"

4.6.配置文件中集群相关参数修改

主要针对``$SEATUNNEL_HOME/config/`以下三个文件进行修改

修改具体说明一下每个文件都要修改的配置项

现在seatunnel的官方已经出了中文版本的文档, 如果觉得我写的很乱,或者有问题,可以直接查看官方文档 Apache Seatunnel官网中文文档传送门

4.6.1.SEATUNNEL配置文件修改

SEATUNNEL配置$SEATUNNEL_HOME/config/seatunnel.yaml文件

因为我这里已经按照了hadoop的集群, 可以直接使用HDFS api 读写文件,存储直接使用默认的HDFS,当然你也可以使用其他的存储类型,具体的参数配置可以参考官网说明。

修改参数如下:

seatunnel:engine:history-job-expire-minutes: 1440backup-count: 1queue-type: blockingqueueprint-execution-info-interval: 60print-job-metrics-info-interval: 60slot-service:dynamic-slot: truecheckpoint:interval: 10000timeout: 60000storage:type: hdfsmax-retained: 3plugin-config:namespace: /tmp/seatunnel/checkpoint_snapshotstorage.type: hdfs# 主要就是修改了hdfs的URI,其它参数使用了系统默认参数fs.defaultFS: hdfs://hadoop1001:8020

4.6.2.SEATUNNEL Engine服务配置文件修改

SEATUNNEL Engine配置$SEATUNNEL_HOME/config/hazelcast.yaml文件

具体的配置项的解释说明请查看 配置 SeaTunnel Engine 服务

hazelcast:# seatunnel集群的名称, 这这个集群名称需要和SEATUNNEL Engine客户端配置文件中集群名称保持一致cluster-name: st-etlnetwork:rest-api:enabled: trueendpoint-groups:CLUSTER_WRITE:enabled: trueDATA:enabled: truejoin:tcp-ip:enabled: true# 需要部署Seatunnel集群的主机列表member-list:- hadoop1001- hadoop1002- hadoop1003- hadoop1004- hadoop1005port:auto-increment: false# 默认的端口是5801,需要确认这个端口未被系统占用port: 5801properties:hazelcast.invocation.max.retry.count: 20hazelcast.tcp.join.port.try.count: 30hazelcast.logging.type: log4j2hazelcast.operation.generic.thread.count: 50

4.6.3.SEATUNNEL Engine客户端配置文件修改

SEATUNNEL Engine配置$SEATUNNEL_HOME/config/hazelcast-client.yaml文件

具体的配置项的解释说明请查看 配置 SeaTunnel Engine 客户端

hazelcast-client:# seatunnel集群的名称, 这这个集群名称需要和SEATUNNEL Engine服务配置文件中集群名称保持一致cluster-name: st-etlproperties:hazelcast.logging.type: log4j2connection-strategy:connection-retry:cluster-connect-timeout-millis: 3000network:# SEATUNNEL Engine服务列表cluster-members:- hadoop1001:5801- hadoop1002:5801- hadoop1003:5801- hadoop1004:5801- hadoop1005:5801

通过以上操作, 单台机器上的seatunnel服务就安装配置完成了。现在我们进行分布式集群部署。

5.分布式集群安装部署

5.1.创建日志目录

我们提前在seatunnel的安装目录下创建一个日志目录,后续seatunnel集群启动之后日志文件会保存再改目录下,在seatunnel服务分发到其他节点之前,先进行该操作。

mkdir -p /opt/software/apache-seatunnel-2.3.5/logs

5.2.添加服务分发集群脚本

这个脚本可以生效需要满足以下三点:

- 需要分发服务的每台主机上都已经安装了

rsync服务 - 集群的域名都已经进行映射

- 脚本执行的主机上已经设置了SSH免密登录其他节点

在hadoop1001主机上添加集群服务分发脚本,直接添加到/usr/bin目录(免得还需要配合子系统环境变量)

vim /usr/bin/data_rsync

脚本内容如下:

#!/bin/bash

#1 获取输入参数个数,如果没有参数,直接退出

pcount=$#

if((pcount==0)); then

echo no args;

exit;

fi#2 获取文件名称

p1=$1

fname=`basename $p1`

echo fname=$fname#3 获取上级目录到绝对路径

pdir=`cd -P $(dirname $p1); pwd`

echo pdir=$pdir#4 获取当前用户名称

user=`whoami`#5 循环()

for((host=2; host<=5; host++)); doecho ------------------- hadoop$host --------------rsync -av $pdir/$fname $user@hadoop100$host:$pdir

done

配置脚本的执行权限

chmod 777 /usr/bin/data_rsync

5.3.Seatunnel服务分发到集群其他主机

执行以下命令完成服务分发

data_rsync /opt/software/seatunnel-2.3.5

如下图说明同步分发完成

检查hadoop1001~1005的主机上/opt/software/目录下是否成功同步了seatunnel-2.3.5安装包

5.4.Seatunnel服务系统环境配置文件分发到集群其他主机

执行以下命令完成服务分发

data_rsync /etc/profile.d/seatunnel.sh

分发完成之后, 登录依次ssh登录到每台服务(hadoop1001~hadoop1004)上,让Seatunnel的系统环境变量立即生效。

- 系统环境变量立即生效

source /etc/profile

- 验证系统环境变量是否生效

echo $SEATUNNEL_HOME

命令行输出如下,说明配置成功

通过以上操作,我们的Seatunnel分布式集群基本就安装完毕了,下面我们继续完成spark引擎和flink引擎配置。

6.基于Spark/flink引擎的Seatunnel集群配置

首先需要部署spark和Flink集群, 这个应该也挺简单了,不会可以自行百度, 实在搞不定私信留言我再输出一个spark和Flink集群安装部署的文章。

我这里已经安装部署了spark和Flink集群, 所以不需要再进行spark集群的部署配置了,这里直接说明如何完成基于spark/Flink引擎的Seatunnel集群配置。

其他这个也很简单, 我们只需要修改seatunnel的环境配置脚本即可,将里面的spark的安装目录路径修改成我们本地的spark安装目录即可

vim $SEATUNNEL_HOME/config/seatunnel-env.sh

脚本内容如下:

#设置spark分布式集群的安装目录

SPARK_HOME=${SPARK_HOME:-/opt/software/spark}

#设置flink分布式集群的安装目录

FLINK_HOME=${FLINK_HOME:-/opt/software/flink}

保存退出。

然后将这个配置文件的修改同步到集群其他主机

data_rsync /opt/software/seatunnel-2.3.5/config/seatunnel-env.sh

重启Seatunnel集群即可。

7.Seatunnel集群常用管理命令

- 1)启动集群(需要在集群每台节点上都执行)

nohup $SEATUNNEL_HOME/bin/seatunnel-cluster.sh 2>&1 &

- 2)停止集群(需要在集群每台节点上都执行)

$SEATUNNEL_HOME/bin/stop-seatunnel-cluster.sh

3)默认引擎任务提交命令

$SEATUNNEL_HOME/bin/seatunnel.sh --config /opt/software/seatunnel-2.3.5/config/app-config/v2.batch.config.template

4)spark2.X版本引擎任务提交命令

$SEATUNNEL_HOME/bin/start-seatunnel-spark-2-connector-v2.sh --master local[4] --deploy-mode client --config /opt/software/seatunnel-2.3.5/config/app-config/v2.batch.config.template

5)spark3.X版本引擎任务提交命令

$SEATUNNEL_HOME/bin/start-seatunnel-spark-3-connector-v2.sh --master local[4] --deploy-mode client --config /opt/software/seatunnel-2.3.5/config/app-config/v2.batch.config.template

6)flink低版本引擎任务提交命令(Flink版本1.12.x到1.14.x)

$SEATUNNEL_HOME/bin/start-seatunnel-flink-13-connector-v2.sh --config /opt/software/seatunnel-2.3.5/config/app-config/v2.streaming.conf.template

7)flink高版本引擎任务提交命令(Flink版本1.15.x到1.16.x)

$SEATUNNEL_HOME/bin/start-seatunnel-flink-15-connector-v2.sh --config /opt/software/seatunnel-2.3.5/config/app-config/v2.streaming.conf.template

8.Seatunnel集群任务测试验证

在hadoop1001上执行基于spark引擎的任务提交进行测试验证, 验证之前需要保证集群服务正常启动

ps -ef|grep seatunnel

如下图,说明集群正常启动

提交测试任务

$SEATUNNEL_HOME/bin/start-seatunnel-spark-2-connector-v2.sh --master local[4] --deploy-mode client --config /opt/software/seatunnel-2.3.5/config/app-config/v2.batch.config.template

任务处理过程打印如下日志,说明集群配置正常,就可以创建其他数据处理的任务。

通过以上部署及验证,Seatunnel集群已经全部安装配置好了, 用起来吧。后续计划把Seatunnel结合Dolphinscheduler任务调度在实际业务中的使用再输出一篇文章。

如果觉得文章写的还不错,喜欢的童鞋们请点赞收藏,送你一送小红花哈。~

相关文章:

基于Seatunnel最新2.3.5版本分布式集群安装部署指南(小白版)

基于Seatunnel2.3.5版本分布式集群安装部署 1.环境准备2.JDK安装3.Maven安装4.Seatunnel在master节点安装部署配置4.1.下载Seatunnel安装包4.2.解压下载好的tar.gz包4.3.下载连接器4.4.配置Seatunnel的系统环境变量4.5.配置 SeaTunnel Engine服务 JVM参数4.6.配置文件中集群相关…...

SSM小区疫情防控系统-计算机毕业设计源码03748

摘 要 随着社会的发展,社会的各行各业都在利用信息化时代的优势。计算机的优势和普及使得各种信息系统的开发成为必需。 小区疫情防控系统,主要的模块包括查看首页、轮播图(轮播图管理)、社区公告管理(社区公告&#…...

英伟达算法岗面试,问的贼专业。。。

节前,我们星球组织了一场算法岗技术&面试讨论会,邀请了一些互联网大厂朋友、参加社招和校招面试的同学。 针对算法岗技术趋势、大模型落地项目经验分享、新手如何入门算法岗、该如何准备、面试常考点分享等热门话题进行了深入的讨论。 合集&#x…...

GIS之arcgis系列09:arcpy实现克里金差值

矢量点数据经过克里金差值后可以转换成栅格数据,那么就需要了解一下什么是克里金差值。 什么是克里金法? IDW(反距离加权法)和样条函数法插值工具被称为确定性插值方法,因为这些方法直接基于周围的测量值或确定生成表面的平滑度的指定数学公式。第二类…...

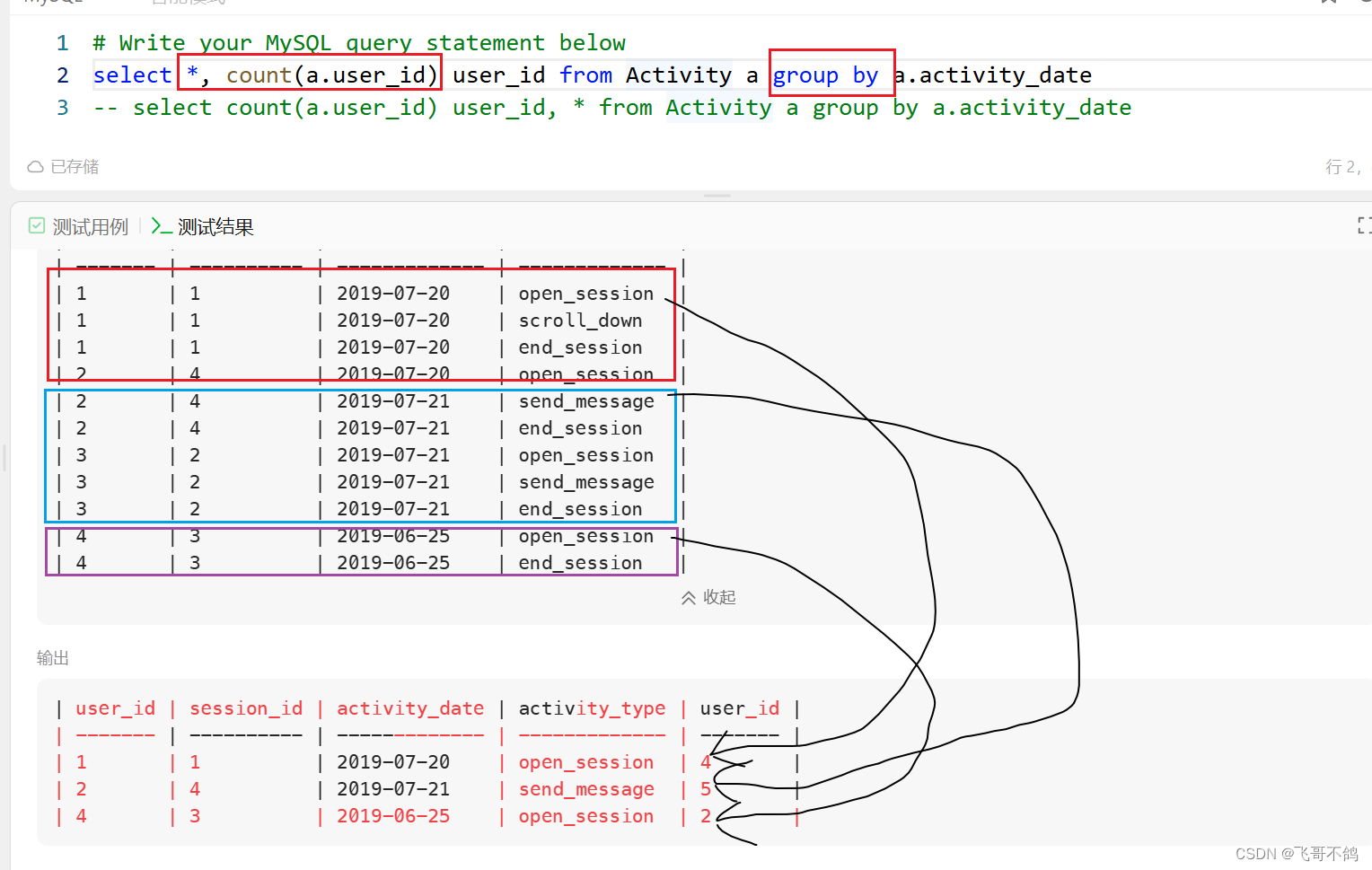

MySQL的group by与count(), *字段使用问题

文章目录 问题group by到底做了什么举个例子简单来说为什么select字段,count()不能和*共同使用总结 问题 这是一段摘抄自MySQL官网的文字。其大致意思是MySQL拓展了group by的使用,MySQL允许选择没有出现在group by中的字段。换句话说,标准SQ…...

Java——面向对象进阶(二)

前言: 多态,包,final关键字,权限修饰符和代码块 文章目录 一、多态1.1 概念1.2 多态存在条件1.3 多态中调用成员的特点1.4 instanceof关键字 二、包三、权限修饰符四、final 关键字4.1 修饰类4.2 修饰方法4.3 修饰变量 五、代码块…...

49.Python-web框架-Django解决多语言redirect时把post改为get的问题

目录 1.背景 2.思路 3.寻找 Find and Replace 4.再次运行程序,POST来了 5.小结 1.背景 昨天在练习一个Django功能时,把form的method设置为POST,但是实际提交时,一直是GET方法。最后发现这是与多语言相关,django前面…...

【数据结构】【版本1.1】【线性时代】——单链表

快乐的流畅:个人主页 个人专栏:《算法神殿》《数据结构世界》《进击的C》 远方有一堆篝火,在为久候之人燃烧! 文章目录 引言一、顺序表的问题二、链表的概念三、单链表的模拟实现3.1 定义3.2 打印3.3 创建新节点3.4 头插3.5 尾插3…...

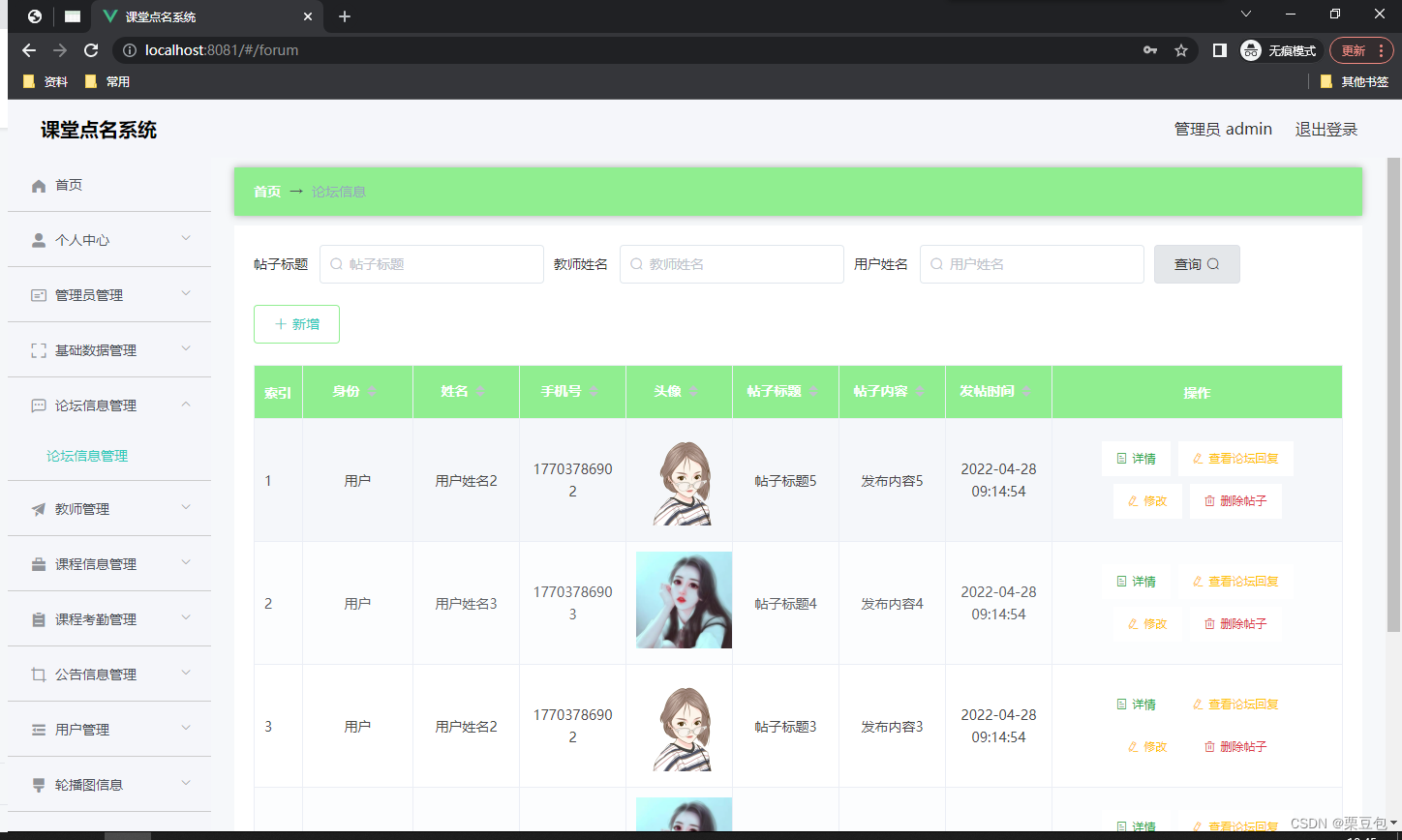

【计算机毕业设计】258基于微信小程序的课堂点名系统

🙊作者简介:拥有多年开发工作经验,分享技术代码帮助学生学习,独立完成自己的项目或者毕业设计。 代码可以私聊博主获取。🌹赠送计算机毕业设计600个选题excel文件,帮助大学选题。赠送开题报告模板ÿ…...

common.js和es6中模块引入的区别

common.js CommonJS 是一种模块系统,主要用于 Node.js 环境。它使用 require 函数来引入模块,并使用 module.exports 来导出模块。 语法: 导出模块: // moduleA.js const name Jo; module.exports name;// 或者导出一个对象…...

关于对pagination.js源代码进行修改且引入项目使用

实现效果 使用定时器对组件进行每秒请求,每过固定时间之后,进行下一页项目请求,进行到最后一页请求的时候返回第一页。 首先引入js插件 <script src"./js/pagination.js" type"text/javascript"></script>…...

《思考总结》

思考总结 ==标题==:卷积操作的作用1. **特征提取**2. **参数共享**3. **降维和数据压缩**4. **提升计算效率**5. **平滑和去噪**卷积操作示例输入图像卷积核卷积过程总结==标题==:上卷积什么是上卷积(反卷积/转置卷积)上卷积的作用上卷积的实现1. **最近邻插值(Nearest Ne…...

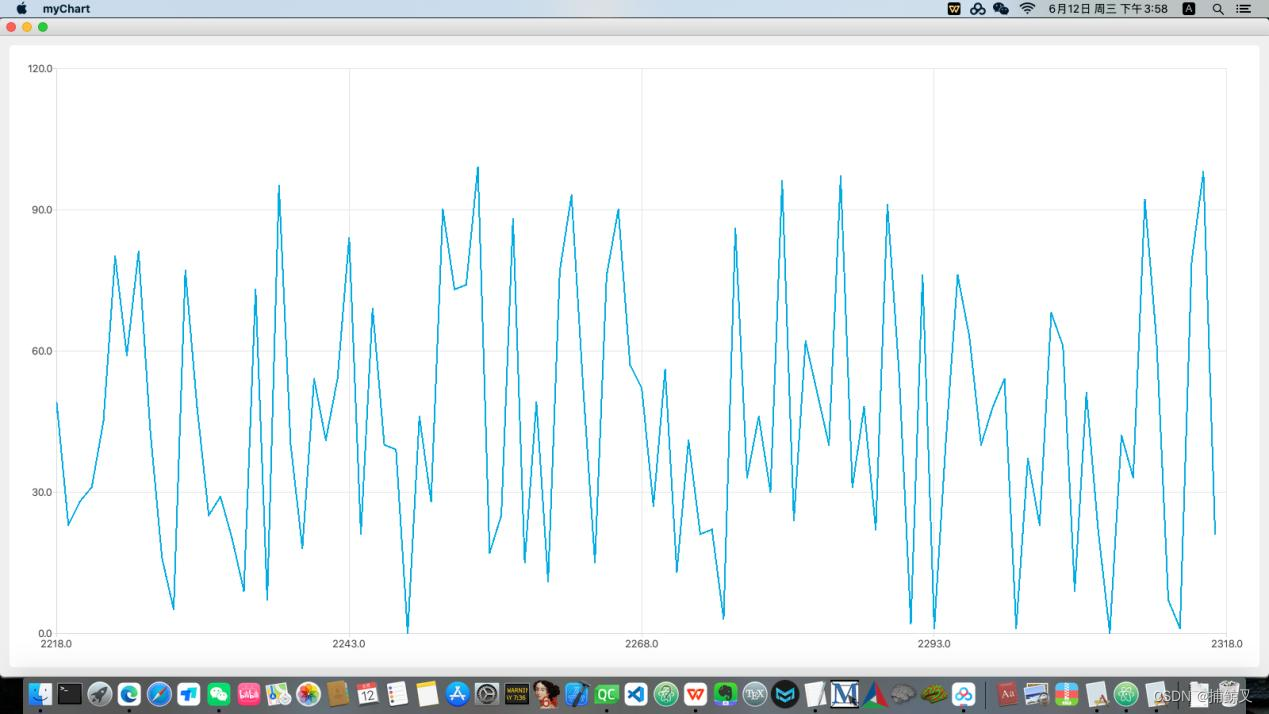

使用QT绘制简单的动态数据折线图

两个核心类时QChart和QLineSeries 下面这个示例代码中,定时器每隔一段时间将曲线图中的数据点向右移动 一个单位,同时调整横坐标轴的范围,实现了一次滚动对应移动一个数据点的效果。 QLineSeries最多容纳40961024个点 #include <QtWidg…...

Linux-centos7 nvm使用

NVM下载使用 文件夹创建拉取nvm包在~/.bashrc的末尾,添加如下语句验证nvm是否安装成功 文件夹创建 mkdir /root/home/software/拉取nvm包 cd /root/home/software/ wget https://github.com/nvm-sh/nvm/archive/refs/tags/v0.38.0.tar.gz tar xvzf v0.38.0.tar.g…...

【Linux】Linux环境基础开发工具_6

文章目录 四、Linux环境基础开发工具gdb 未完待续 四、Linux环境基础开发工具 gdb 我们已经可以写代码了,也能够执行代码了,但是代码错了该如何调试呢?Linux中可以使用 gdb 工具进行调试。 我们写一个简单的程序: 但是我们尝试…...

Redis宣布商用后,Redis国产化替代方案有那些?

一、背景 Redis作为使用最为广泛的开源缓存中间件,现已成为IT开发中必不可少的核心组件。官方修改协议印证了“开源”不意味着“无偿使用”,相关限制或将对基于开源Redis提供中间件产品的厂商,及提供Redis服务的云厂商产生一定影响。 二、国…...

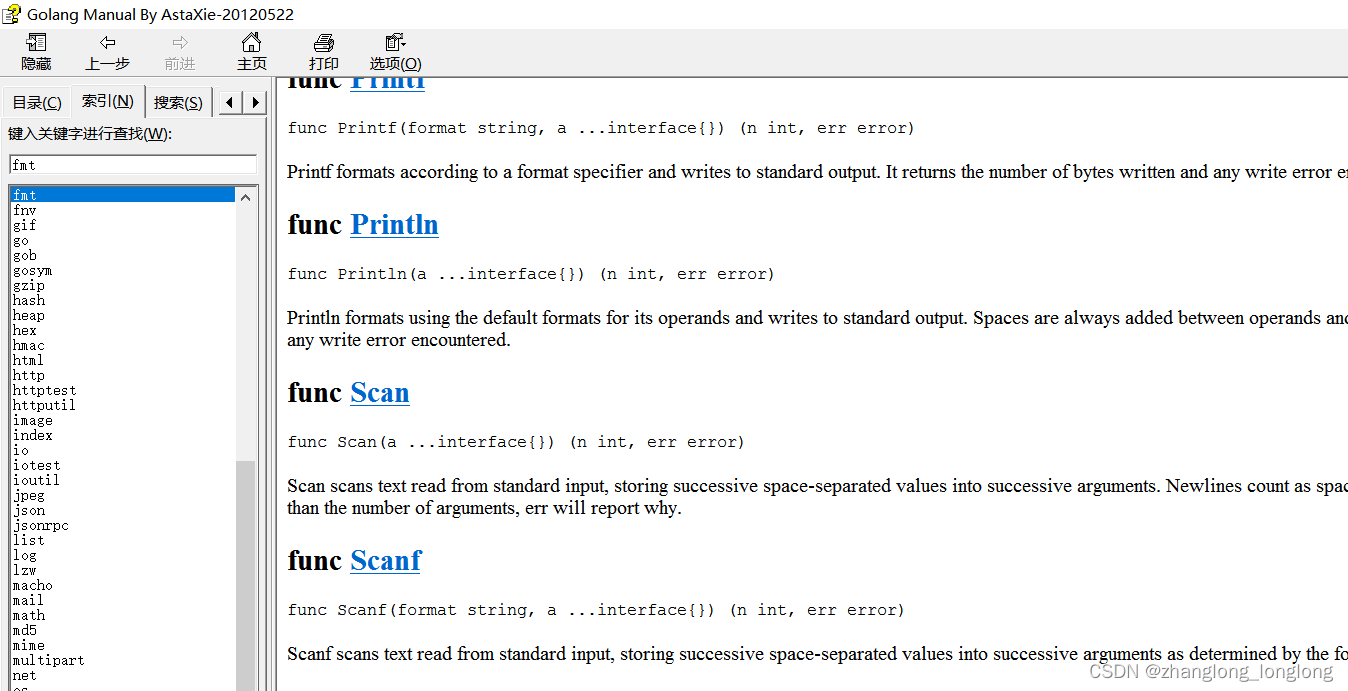

Go API

Go语言提供了大量的标准库,因此 google 公司也为这些标准库提供了相应的API文档,用于告诉开发者如何使用这些标准库,以及标准库包含的方法。官方位置:https://golang.org Golang中文网在线标准库文档: https://studygolang.com/p…...

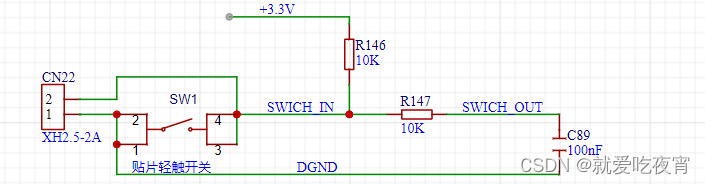

基于STM32的简易智能家居设计(嘉立创支持)

一、项目功能概述 1、OLED显示温湿度、空气质量,并可以设置报警阈值 2、设置4个继电器开关,分别控制灯、空调、开关、风扇 3、设计一个离线语音识别系统,可以语音控制打开指定开关、并且可以显示识别命令词到OLED屏上 4、OLED实时显示&#…...

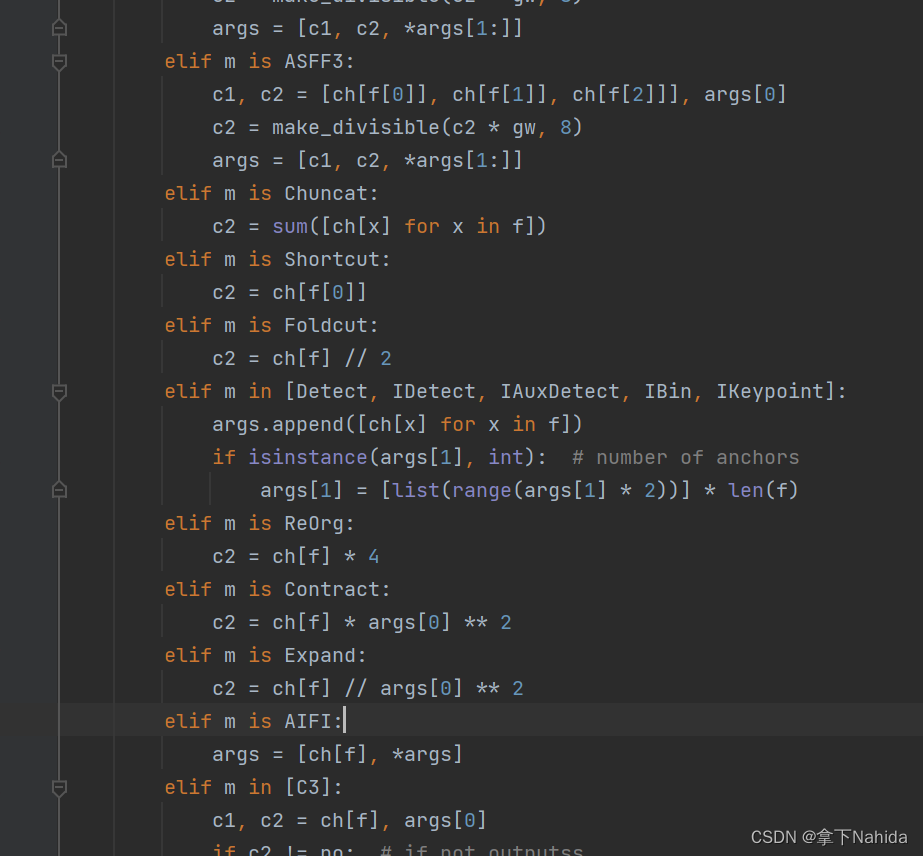

【YOLOv5/v7改进系列】改进池化层为RT-DETR的AIFI

一、导言 Real-Time DEtection TRansformer(RT-DETR),是一种实时端到端目标检测器,克服了Non-Maximum Suppression(NMS)对速度和准确性的影响。通过设计高效的混合编码器和不确定性最小化查询选择…...

使用Python和Matplotlib绘制复杂数学函数图像

本文介绍了如何使用Python编程语言和Matplotlib库来绘制复杂的数学函数图像。通过引入NumPy库的数学函数,我们可以处理包括指数函数在内的各种复杂表达式。本文详细讲解了如何设置中文字体以确保在图像中正确显示中文标题和标签,并提供了一个完整的代码示例,用户可以通过输入…...

Android Wi-Fi 连接失败日志分析

1. Android wifi 关键日志总结 (1) Wi-Fi 断开 (CTRL-EVENT-DISCONNECTED reason3) 日志相关部分: 06-05 10:48:40.987 943 943 I wpa_supplicant: wlan0: CTRL-EVENT-DISCONNECTED bssid44:9b:c1:57:a8:90 reason3 locally_generated1解析: CTR…...

模型参数、模型存储精度、参数与显存

模型参数量衡量单位 M:百万(Million) B:十亿(Billion) 1 B 1000 M 1B 1000M 1B1000M 参数存储精度 模型参数是固定的,但是一个参数所表示多少字节不一定,需要看这个参数以什么…...

【Linux】C语言执行shell指令

在C语言中执行Shell指令 在C语言中,有几种方法可以执行Shell指令: 1. 使用system()函数 这是最简单的方法,包含在stdlib.h头文件中: #include <stdlib.h>int main() {system("ls -l"); // 执行ls -l命令retu…...

iPhone密码忘记了办?iPhoneUnlocker,iPhone解锁工具Aiseesoft iPhone Unlocker 高级注册版分享

平时用 iPhone 的时候,难免会碰到解锁的麻烦事。比如密码忘了、人脸识别 / 指纹识别突然不灵,或者买了二手 iPhone 却被原来的 iCloud 账号锁住,这时候就需要靠谱的解锁工具来帮忙了。Aiseesoft iPhone Unlocker 就是专门解决这些问题的软件&…...

Frozen-Flask :将 Flask 应用“冻结”为静态文件

Frozen-Flask 是一个用于将 Flask 应用“冻结”为静态文件的 Python 扩展。它的核心用途是:将一个 Flask Web 应用生成成纯静态 HTML 文件,从而可以部署到静态网站托管服务上,如 GitHub Pages、Netlify 或任何支持静态文件的网站服务器。 &am…...

基础光照(Basic Lighting))

C++.OpenGL (10/64)基础光照(Basic Lighting)

基础光照(Basic Lighting) 冯氏光照模型(Phong Lighting Model) #mermaid-svg-GLdskXwWINxNGHso {font-family:"trebuchet ms",verdana,arial,sans-serif;font-size:16px;fill:#333;}#mermaid-svg-GLdskXwWINxNGHso .error-icon{fill:#552222;}#mermaid-svg-GLd…...

)

相机Camera日志分析之三十一:高通Camx HAL十种流程基础分析关键字汇总(后续持续更新中)

【关注我,后续持续新增专题博文,谢谢!!!】 上一篇我们讲了:有对最普通的场景进行各个日志注释讲解,但相机场景太多,日志差异也巨大。后面将展示各种场景下的日志。 通过notepad++打开场景下的日志,通过下列分类关键字搜索,即可清晰的分析不同场景的相机运行流程差异…...

鱼香ros docker配置镜像报错:https://registry-1.docker.io/v2/

使用鱼香ros一件安装docker时的https://registry-1.docker.io/v2/问题 一键安装指令 wget http://fishros.com/install -O fishros && . fishros出现问题:docker pull 失败 网络不同,需要使用镜像源 按照如下步骤操作 sudo vi /etc/docker/dae…...

Mobile ALOHA全身模仿学习

一、题目 Mobile ALOHA:通过低成本全身远程操作学习双手移动操作 传统模仿学习(Imitation Learning)缺点:聚焦与桌面操作,缺乏通用任务所需的移动性和灵活性 本论文优点:(1)在ALOHA…...

html css js网页制作成品——HTML+CSS榴莲商城网页设计(4页)附源码

目录 一、👨🎓网站题目 二、✍️网站描述 三、📚网站介绍 四、🌐网站效果 五、🪓 代码实现 🧱HTML 六、🥇 如何让学习不再盲目 七、🎁更多干货 一、👨…...