Pytorch | 从零构建GoogleNet对CIFAR10进行分类

Pytorch | 从零构建GoogleNet对CIFAR10进行分类

- CIFAR10数据集

- GoogleNet

- 网络结构特点

- 网络整体架构

- 应用与影响

- Inceptionv1到Inceptionv2

- GoogleNet结构代码详解

- 结构代码

- 代码详解

- Inception 类

- 初始化方法

- 前向传播 forward

- GoogleNet 类

- 初始化方法

- 前向传播 forward

- 训练过程和测试结果

- 代码汇总

- googlenet.py

- train.py

- test.py

前面文章我们构建了AlexNet、Vgg对CIFAR10进行分类:

Pytorch | 从零构建AlexNet对CIFAR10进行分类

Pytorch | 从零构建Vgg对CIFAR10进行分类

这篇文章我们来构建GoogleNet(或称GoogleNet-BN, Inception v2).

CIFAR10数据集

CIFAR-10数据集是由加拿大高级研究所(CIFAR)收集整理的用于图像识别研究的常用数据集,基本信息如下:

- 数据规模:该数据集包含60,000张彩色图像,分为10个不同的类别,每个类别有6,000张图像。通常将其中50,000张作为训练集,用于模型的训练;10,000张作为测试集,用于评估模型的性能。

- 图像尺寸:所有图像的尺寸均为32×32像素,这相对较小的尺寸使得模型在处理该数据集时能够相对快速地进行训练和推理,但也增加了图像分类的难度。

- 类别内容:涵盖了飞机(plane)、汽车(car)、鸟(bird)、猫(cat)、鹿(deer)、狗(dog)、青蛙(frog)、马(horse)、船(ship)、卡车(truck)这10个不同的类别,这些类别都是现实世界中常见的物体,具有一定的代表性。

下面是一些示例样本:

GoogleNet

GoogleNet是由Google团队在2014年提出的一种深度卷积神经网络架构,以下是对它的详细介绍:

网络结构特点

- Inception模块:这是GoogleNet的核心创新点。Inception模块通过并行使用不同大小的卷积核(如1×1、3×3、5×5)和池化操作,然后将它们的结果在通道维度上进行拼接,从而可以同时提取不同尺度的特征。例如,1×1卷积核可以用于在不改变特征图尺寸的情况下进行降维或升维,减少计算量;3×3和5×5卷积核则可以捕捉不同感受野的特征。

- 深度和宽度:GoogleNet网络很深,共有22层,但它的参数量却比同层次的一些网络少很多,这得益于Inception模块的高效设计。同时,网络的宽度也较大,能够学习到丰富的特征表示。

- 辅助分类器:为了缓解梯度消失问题,GoogleNet在网络中间层添加了两个辅助分类器。这些辅助分类器在训练过程中与主分类器一起进行反向传播,帮助梯度更好地传播到浅层网络,加快训练速度并提高模型的泛化能力。在测试时,辅助分类器的结果会被加权融合到主分类器的结果中。

网络整体架构

-

输入层:接收大小为 H × W × 3 H×W×3 H×W×3的图像数据,其中 H H H和 W W W表示图像的高度和宽度,3表示图像的RGB通道数。

-

卷积层和池化层:网络的前面几层主要由卷积层和池化层组成,用于提取图像的基本特征。这些层逐渐降低图像的分辨率,同时增加特征图的通道数。

-

Inception模块组:网络的主体部分由多个Inception模块组构成,每个模块组包含多个Inception模块。随着网络的深入,Inception模块的输出通道数逐渐增加,以学习更高级的特征。

-

池化层和全连接层:在Inception模块组之后,网络通过一个平均池化层将特征图的尺寸缩小到1×1,然后将其展平并连接到一个全连接层,最后通过一个Softmax层输出分类结果。

应用与影响

- 图像分类:GoogleNet在图像分类任务上取得了非常好的效果,在ILSVRC 2014图像分类竞赛中获得了冠军。它能够准确地识别各种自然图像中的物体类别,如猫、狗、汽车、飞机等。

- 目标检测:GoogleNet也可以应用于目标检测任务,通过在网络中添加一些额外的检测层和算法,可以实现对图像中物体的定位和检测。

- 后续研究基础:GoogleNet的成功推动了深度学习领域的发展,其Inception模块的设计思想为后来的许多网络架构提供了灵感,如Inception系列的后续版本以及其他一些基于多分支结构的网络。

Inceptionv1到Inceptionv2

上面所提到的 Inception 模块组,我们称之为 Inception v1,而后谷歌又对其进行优化,体现在本文的代码中的即:

- 引入了Batch Normalization (BN)层:Inception v1 没有 BN 层,而 Inception v2 在每个卷积层之后引入了 BN 层。这有助于解决深层网络中的梯度消失问题,使每一层的输入更加稳定,从而加快训练过程并提高模型的收敛速度.

- 优化卷积核组合:Inception v1 中使用 1x1、3x3、5x5 的卷积核和 3x3 的池化操作并行组合。Inception v2 学习 VGG 网络的做法,用两个 3x3 的卷积核替代 Inception 模块中的 5x5 卷积核,减少了参数数量,同时增加了网络的非线性表达能力

GoogleNet结构代码详解

结构代码

import torch

import torch.nn as nnclass Inception(nn.Module):def __init__(self, in_channels, ch1x1, ch3x3reduc, ch3x3, ch5x5reduc, ch5x5, pool_proj):super().__init__()self.branch1x1 = nn.Sequential(nn.Conv2d(in_channels, ch1x1, kernel_size=1),nn.BatchNorm2d(ch1x1),nn.ReLU(inplace=True))self.branch3x3 = nn.Sequential(nn.Conv2d(in_channels, ch3x3reduc, kernel_size=1),nn.BatchNorm2d(ch3x3reduc),nn.ReLU(inplace=True),nn.Conv2d(ch3x3reduc, ch3x3, kernel_size=3, padding=1),nn.ReLU(inplace=True))self.branch5x5 = nn.Sequential(nn.Conv2d(in_channels, ch5x5reduc, kernel_size=1),nn.BatchNorm2d(ch5x5reduc),nn.ReLU(inplace=True),nn.Conv2d(ch5x5reduc, ch5x5, kernel_size=3, padding=1),nn.BatchNorm2d(ch5x5),nn.ReLU(inplace=True),nn.Conv2d(ch5x5, ch5x5, kernel_size=3, padding=1),nn.BatchNorm2d(ch5x5),nn.ReLU(inplace=True))self.branch_pool = nn.Sequential(nn.MaxPool2d(kernel_size=3, stride=1, padding=1),nn.Conv2d(in_channels, pool_proj, kernel_size=1),nn.BatchNorm2d(pool_proj),nn.ReLU(inplace=True))def forward(self, x):branch1x1 = self.branch1x1(x)branch3x3 = self.branch3x3(x)branch5x5 = self.branch5x5(x)branch_pool = self.branch_pool(x)return torch.cat([branch1x1, branch3x3, branch5x5, branch_pool], 1)class GoogleNet(nn.Module):def __init__(self, num_classes):super(GoogleNet, self).__init__()self.prelayers = nn.Sequential(nn.Conv2d(3, 64, kernel_size=3, padding=1),nn.BatchNorm2d(64),nn.ReLU(inplace=True),nn.Conv2d(64, 64, kernel_size=3, padding=1),nn.BatchNorm2d(64),nn.ReLU(inplace=True),nn.Conv2d(64, 192, kernel_size=3, padding=1),nn.BatchNorm2d(192),nn.ReLU(inplace=True))self.maxpool2 = nn.MaxPool2d(kernel_size=3, stride=2, padding=1)self.inception3a = Inception(192, 64, 96, 128, 16, 32, 32)self.inception3b = Inception(256, 128, 128, 192, 32, 96, 64)self.maxpool3 = nn.MaxPool2d(kernel_size=3, stride=2, padding=1)self.inception4a = Inception(480, 192, 96, 208, 16, 48, 64)self.inception4b = Inception(512, 160, 112, 224, 24, 64, 64)self.inception4c = Inception(512, 128, 128, 256, 24, 64, 64)self.inception4d = Inception(512, 112, 144, 288, 32, 64, 64)self.inception4e = Inception(528, 256, 160, 320, 32, 128, 128)self.maxpool4 = nn.MaxPool2d(kernel_size=3, stride=2, padding=1)self.inception5a = Inception(832, 256, 160, 320, 32, 128, 128)self.inception5b = Inception(832, 384, 192, 384, 48, 128, 128)self.avgpool = nn.AdaptiveAvgPool2d((1, 1))self.dropout = nn.Dropout(0.4)self.fc = nn.Linear(1024, num_classes)def forward(self, x):x = self.prelayers(x)x = self.maxpool2(x)x = self.inception3a(x)x = self.inception3b(x)x = self.maxpool3(x)x = self.inception4a(x)x = self.inception4b(x)x = self.inception4c(x)x = self.inception4d(x)x = self.inception4e(x)x = self.maxpool4(x)x = self.inception5a(x)x = self.inception5b(x)x = self.avgpool(x)x = self.dropout(x)x = x.view(x.size()[0], -1)x = self.fc(x)return x

代码详解

以下是对上述代码的详细解释,这段Python代码使用PyTorch库构建了经典的GoogleNet(Inception v1)网络结构,用于图像分类任务,以下从不同部分展开介绍:

Inception 类

这个类定义了GoogleNet中的Inception模块,它的作用是通过不同尺寸的卷积核等操作来并行提取特征,然后将这些特征在通道维度上进行拼接。

初始化方法

- 参数说明:

in_channels:输入特征图的通道数,即输入数据的深度维度。ch1x1、ch3x3reduc、ch3x3、ch5x5reduc、ch5x5、pool_proj:分别对应不同分支中卷积操作涉及的通道数等参数,用于配置每个分支的结构。

- 网络结构构建:

self.branch1x1:构建了一个包含1×1卷积、批归一化(BatchNorm)和ReLU激活函数的顺序结构。1×1卷积用于在不改变特征图尺寸的情况下调整通道数,批归一化有助于加速训练和提高模型稳定性,ReLU激活函数引入非线性变换。self.branch3x3:先是一个1×1卷积进行通道数的降维(减少计算量),接着经过批归一化和ReLU激活,然后是一个3×3卷积(通过padding=1保证特征图尺寸不变),最后再接ReLU激活。self.branch5x5:结构相对更复杂些,先是1×1卷积和批归一化、ReLU激活,然后连续两个3×3卷积(都通过合适的padding保证尺寸不变),中间穿插批归一化和ReLU激活,用于提取更复杂的特征。self.branch_pool:先进行最大池化(MaxPool2d,通过特定参数设置保证尺寸基本不变),然后接1×1卷积来调整通道数,再进行批归一化和ReLU激活。

前向传播 forward

- 接收输入张量

x,分别将其传入上述四个分支结构中,得到四个分支的输出branch1x1、branch3x3、branch5x5、branch_pool。 - 最后通过

torch.cat函数沿着通道维度(维度1,即参数中的1)将这四个分支的输出特征图拼接在一起,作为整个Inception模块的输出。

GoogleNet 类

这是整个网络的主体类,将多个Inception模块以及其他必要的层组合起来构建完整的GoogleNet架构。

初始化方法

- 参数说明:

num_classes:表示分类任务的类别数量,用于最终全连接层输出对应数量的类别预测结果。

- 网络结构构建:

self.prelayers:由一系列的卷积、批归一化和ReLU激活函数组成的顺序结构,用于对输入图像进行初步的特征提取,逐步将输入的3通道(对应RGB图像)特征图转换为192通道的特征图。self.maxpool2:一个最大池化层,用于下采样,减小特征图尺寸,同时增大感受野,步长为2,按一定的padding设置来控制输出尺寸。- 接下来依次定义了多个Inception模块,如

self.inception3a、self.inception3b等,它们的输入通道数和各分支的配置参数不同,随着网络的深入逐渐提取更高级、更复杂的特征,并且中间穿插了几个最大池化层(self.maxpool3、self.maxpool4等)进行下采样操作。 self.avgpool:自适应平均池化层,将不同尺寸的特征图转换为固定大小(这里是1×1)的特征图,方便后续的全连接层处理。self.dropout:引入Dropout层,概率设置为0.4,在训练过程中随机丢弃部分神经元连接,防止过拟合。self.fc:全连接层,将经过前面处理后的特征映射到指定的num_classes个类别上,用于最终的分类预测。

前向传播 forward

- 首先将输入

x传入self.prelayers进行初步特征提取,然后经过self.maxpool2下采样。 - 接着依次将特征图传入各个Inception模块,并穿插经过最大池化层进行下采样,不断提取和整合特征。

- 经过最后的Inception模块后,特征图通过

self.avgpool进行平均池化,再经过self.dropout进行随机失活处理,然后通过x.view函数将特征图展平成一维向量(方便全连接层处理),最后传入self.fc全连接层得到最终的分类预测结果并返回。

训练过程和测试结果

训练过程损失函数变化曲线:

训练过程准确率变化曲线:

测试结果:

代码汇总

项目github地址

项目结构:

|--data

|--models|--__init__.py|--googlenet.py|--...

|--results

|--weights

|--train.py

|--test.py

googlenet.py

import torch

import torch.nn as nnclass Inception(nn.Module):def __init__(self, in_channels, ch1x1, ch3x3reduc, ch3x3, ch5x5reduc, ch5x5, pool_proj):super().__init__()self.branch1x1 = nn.Sequential(nn.Conv2d(in_channels, ch1x1, kernel_size=1),nn.BatchNorm2d(ch1x1),nn.ReLU(inplace=True))self.branch3x3 = nn.Sequential(nn.Conv2d(in_channels, ch3x3reduc, kernel_size=1),nn.BatchNorm2d(ch3x3reduc),nn.ReLU(inplace=True),nn.Conv2d(ch3x3reduc, ch3x3, kernel_size=3, padding=1),nn.ReLU(inplace=True))self.branch5x5 = nn.Sequential(nn.Conv2d(in_channels, ch5x5reduc, kernel_size=1),nn.BatchNorm2d(ch5x5reduc),nn.ReLU(inplace=True),nn.Conv2d(ch5x5reduc, ch5x5, kernel_size=3, padding=1),nn.BatchNorm2d(ch5x5),nn.ReLU(inplace=True),nn.Conv2d(ch5x5, ch5x5, kernel_size=3, padding=1),nn.BatchNorm2d(ch5x5),nn.ReLU(inplace=True))self.branch_pool = nn.Sequential(nn.MaxPool2d(kernel_size=3, stride=1, padding=1),nn.Conv2d(in_channels, pool_proj, kernel_size=1),nn.BatchNorm2d(pool_proj),nn.ReLU(inplace=True))def forward(self, x):branch1x1 = self.branch1x1(x)branch3x3 = self.branch3x3(x)branch5x5 = self.branch5x5(x)branch_pool = self.branch_pool(x)return torch.cat([branch1x1, branch3x3, branch5x5, branch_pool], 1)class GoogleNet(nn.Module):def __init__(self, num_classes):super(GoogleNet, self).__init__()self.prelayers = nn.Sequential(nn.Conv2d(3, 64, kernel_size=3, padding=1),nn.BatchNorm2d(64),nn.ReLU(inplace=True),nn.Conv2d(64, 64, kernel_size=3, padding=1),nn.BatchNorm2d(64),nn.ReLU(inplace=True),nn.Conv2d(64, 192, kernel_size=3, padding=1),nn.BatchNorm2d(192),nn.ReLU(inplace=True))self.maxpool2 = nn.MaxPool2d(kernel_size=3, stride=2, padding=1)self.inception3a = Inception(192, 64, 96, 128, 16, 32, 32)self.inception3b = Inception(256, 128, 128, 192, 32, 96, 64)self.maxpool3 = nn.MaxPool2d(kernel_size=3, stride=2, padding=1)self.inception4a = Inception(480, 192, 96, 208, 16, 48, 64)self.inception4b = Inception(512, 160, 112, 224, 24, 64, 64)self.inception4c = Inception(512, 128, 128, 256, 24, 64, 64)self.inception4d = Inception(512, 112, 144, 288, 32, 64, 64)self.inception4e = Inception(528, 256, 160, 320, 32, 128, 128)self.maxpool4 = nn.MaxPool2d(kernel_size=3, stride=2, padding=1)self.inception5a = Inception(832, 256, 160, 320, 32, 128, 128)self.inception5b = Inception(832, 384, 192, 384, 48, 128, 128)self.avgpool = nn.AdaptiveAvgPool2d((1, 1))self.dropout = nn.Dropout(0.4)self.fc = nn.Linear(1024, num_classes)def forward(self, x):x = self.prelayers(x)x = self.maxpool2(x)x = self.inception3a(x)x = self.inception3b(x)x = self.maxpool3(x)x = self.inception4a(x)x = self.inception4b(x)x = self.inception4c(x)x = self.inception4d(x)x = self.inception4e(x)x = self.maxpool4(x)x = self.inception5a(x)x = self.inception5b(x)x = self.avgpool(x)x = self.dropout(x)x = x.view(x.size()[0], -1)x = self.fc(x)return x

train.py

import torch

import torch.nn as nn

import torch.optim as optim

import torchvision

import torchvision.transforms as transforms

from models import *

import matplotlib.pyplot as pltimport ssl

ssl._create_default_https_context = ssl._create_unverified_context# 定义数据预处理操作

transform = transforms.Compose([transforms.ToTensor(),transforms.Normalize((0.491, 0.482, 0.446), (0.247, 0.243, 0.261))])# 加载CIFAR10训练集

trainset = torchvision.datasets.CIFAR10(root='./data', train=True,download=False, transform=transform)

trainloader = torch.utils.data.DataLoader(trainset, batch_size=128,shuffle=True, num_workers=2)# 定义设备(GPU优先,若可用)

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")# 实例化模型

model_name = 'GoogleNet'

if model_name == 'AlexNet':model = AlexNet(num_classes=10).to(device)

elif model_name == 'Vgg_A':model = Vgg(cfg_vgg='A', num_classes=10).to(device)

elif model_name == 'Vgg_A-LRN':model = Vgg(cfg_vgg='A-LRN', num_classes=10).to(device)

elif model_name == 'Vgg_B':model = Vgg(cfg_vgg='B', num_classes=10).to(device)

elif model_name == 'Vgg_C':model = Vgg(cfg_vgg='C', num_classes=10).to(device)

elif model_name == 'Vgg_D':model = Vgg(cfg_vgg='D', num_classes=10).to(device)

elif model_name == 'Vgg_E':model = Vgg(cfg_vgg='E', num_classes=10).to(device)

elif model_name == 'GoogleNet':model = GoogleNet(num_classes=10).to(device)criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)# 训练轮次

epochs = 15def train(model, trainloader, criterion, optimizer, device):model.train()running_loss = 0.0correct = 0total = 0for i, data in enumerate(trainloader, 0):inputs, labels = data[0].to(device), data[1].to(device)optimizer.zero_grad()outputs = model(inputs)loss = criterion(outputs, labels)loss.backward()optimizer.step()running_loss += loss.item()_, predicted = outputs.max(1)total += labels.size(0)correct += predicted.eq(labels).sum().item()epoch_loss = running_loss / len(trainloader)epoch_acc = 100. * correct / totalreturn epoch_loss, epoch_accif __name__ == "__main__":loss_history, acc_history = [], []for epoch in range(epochs):train_loss, train_acc = train(model, trainloader, criterion, optimizer, device)print(f'Epoch {epoch + 1}: Train Loss: {train_loss:.4f}, Train Acc: {train_acc:.2f}%')loss_history.append(train_loss)acc_history.append(train_acc)# 保存模型权重,每5轮次保存到weights文件夹下if (epoch + 1) % 5 == 0:torch.save(model.state_dict(), f'weights/{model_name}_epoch_{epoch + 1}.pth')# 绘制损失曲线plt.plot(range(1, epochs+1), loss_history, label='Loss', marker='o')plt.xlabel('Epoch')plt.ylabel('Loss')plt.title('Training Loss Curve')plt.legend()plt.savefig(f'results\\{model_name}_train_loss_curve.png')plt.close()# 绘制准确率曲线plt.plot(range(1, epochs+1), acc_history, label='Accuracy', marker='o')plt.xlabel('Epoch')plt.ylabel('Accuracy (%)')plt.title('Training Accuracy Curve')plt.legend()plt.savefig(f'results\\{model_name}_train_acc_curve.png')plt.close()

test.py

import torch

import torch.nn as nn

import torchvision

import torchvision.transforms as transforms

from models import *import ssl

ssl._create_default_https_context = ssl._create_unverified_context

# 定义数据预处理操作

transform = transforms.Compose([transforms.ToTensor(),transforms.Normalize((0.491, 0.482, 0.446), (0.247, 0.243, 0.261))])# 加载CIFAR10测试集

testset = torchvision.datasets.CIFAR10(root='./data', train=False,download=False, transform=transform)

testloader = torch.utils.data.DataLoader(testset, batch_size=128,shuffle=False, num_workers=2)# 定义设备(GPU优先,若可用)

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")# 实例化模型

model_name = 'GoogleNet'

if model_name == 'AlexNet':model = AlexNet(num_classes=10).to(device)

elif model_name == 'Vgg_A':model = Vgg(cfg_vgg='A', num_classes=10).to(device)

elif model_name == 'Vgg_A-LRN':model = Vgg(cfg_vgg='A-LRN', num_classes=10).to(device)

elif model_name == 'Vgg_B':model = Vgg(cfg_vgg='B', num_classes=10).to(device)

elif model_name == 'Vgg_C':model = Vgg(cfg_vgg='C', num_classes=10).to(device)

elif model_name == 'Vgg_D':model = Vgg(cfg_vgg='D', num_classes=10).to(device)

elif model_name == 'Vgg_E':model = Vgg(cfg_vgg='E', num_classes=10).to(device)

elif model_name == 'GoogleNet':model = GoogleNet(num_classes=10).to(device)criterion = nn.CrossEntropyLoss()# 加载模型权重

weights_path = f"weights/{model_name}_epoch_15.pth"

model.load_state_dict(torch.load(weights_path, map_location=device))def test(model, testloader, criterion, device):model.eval()running_loss = 0.0correct = 0total = 0with torch.no_grad():for data in testloader:inputs, labels = data[0].to(device), data[1].to(device)outputs = model(inputs)loss = criterion(outputs, labels)running_loss += loss.item()_, predicted = outputs.max(1)total += labels.size(0)correct += predicted.eq(labels).sum().item()epoch_loss = running_loss / len(testloader)epoch_acc = 100. * correct / totalreturn epoch_loss, epoch_accif __name__ == "__main__":test_loss, test_acc = test(model, testloader, criterion, device)print(f"================{model_name} Test================")print(f"Load Model Weights From: {weights_path}")print(f'Test Loss: {test_loss:.4f}, Test Acc: {test_acc:.2f}%')

相关文章:

Pytorch | 从零构建GoogleNet对CIFAR10进行分类

Pytorch | 从零构建GoogleNet对CIFAR10进行分类 CIFAR10数据集GoogleNet网络结构特点网络整体架构应用与影响Inceptionv1到Inceptionv2 GoogleNet结构代码详解结构代码代码详解Inception 类初始化方法前向传播 forward GoogleNet 类初始化方法前向传播 forward 训练过程和测试结…...

基于SIFT的目标识别算法

基于SIFT(Scale-Invariant Feature Transform)的目标识别算法是一种经典的计算机视觉算法,用于在图像中寻找和匹配具有尺度不变性的特征点,从而实现目标的快速而准确的识别。 SIFT算法的主要步骤包括以下几个阶段: 尺…...

--数据的表示与运算·其三 补码的乘法以及原码补码的除法)

计算机组成原理的学习笔记(4)--数据的表示与运算·其三 补码的乘法以及原码补码的除法

学习笔记 前言 本文主要是对于b站尚硅谷的计算机组成原理的学习笔记,仅用于学习交流。 1.补码乘法 基本操作 与正常原码乘法差不多,逐位乘,随后相加,而与符号位有关的一项也叫校正项 Booth算法 从乘数的最低位开始,…...

压缩glb模型文件

使用?gltf-pipeline进行压缩: GitHub地址[这里是图片001]https://github.com/CesiumGS/gltf-pipeline 1. 安装gltf-pipeline npm install -g gltf-pipeline2. 在glb文件目录打开cmd进行命令行压缩: // cmd: gltf-pipeline -i glb.glb -d -s以下是 -…...

vertx idea快速使用

目录 1.官网下载项目 2.修改代码 2.1拷贝代码方式 为了能够快速使用,我另外创建一个新的maven项目,将下载项目的src文件和pom文件拷贝到新建的maven项目。 2.2删除.mvn方式 3.更新配置 4.配置application 5.idea启动项目 1.官网下载项目 从vert…...

如何创建属于自己的大语言模型:从零开始的指南

如何创建属于自己的大语言模型:从零开始的指南 为什么要创建自己的大语言模型? 随着人工智能的快速发展,大语言模型(LLM)在各种场景中表现出了卓越的能力,例如文本生成、对话交互和内容总结等。虽然市场上…...

)

debian linux 连网自动调整时间 (报错 Unit systemd-timesyncd.service could not be found.)

debian linux 连网自动调整时间 如果有报错 Unit systemd-timesyncd.service could not be found. 就用 apt 装一下 systemd-timesyncd 吧 参考: https://github.com/MichaIng/DietPi/issues/5472 sudo apt-get install systemd-timesyncd... ┌──(kali㉿kali)-[~] └─$ t…...

监控易在汽车制造行业信息化运维中的应用案例

引言 随着汽车制造行业的数字化转型不断深入,信息化类IT软硬件设备的运行状态监控、故障告警、报表报告以及网络运行状态监控等成为了企业运维管理的关键环节。监控易作为一款全面、高效的信息化运维管理工具,在汽车制造行业中发挥着重要作用。本文将结合…...

es使用knn向量检索中numCandidates和k应该如何配比更合适

在Elasticsearch(ES)中,KNN(k-最近邻)向量检索是一种高效的向量相似性搜索方法,广泛应用于推荐系统、图像搜索、自然语言处理等领域。在KNN检索中,k 和 numCandidates 是两个关键参数࿰…...

推挽输出和开漏输出

推挽输出:能真正的输出高低电平 开漏输出:无法正真的输出高电平(会分压),高电平时没有驱动能力,需要借助外部上拉电阻完成对外驱动...

Cesium引入天地图、高德、百度地图

这里借助了ceisum-map开源项目进行了实现。 cesium-map中的百度地图存在一定问题,使用矢量地图的时候,感觉地图的样式不太理想,而且卫星底图仅显示了东半球,所以自己写了个一个提供器,也存在一定的问题,在0…...

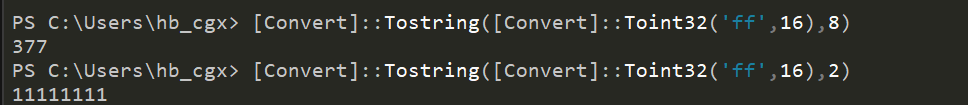

windows自带16进制转10进制

简单的 A->10 如下 11A9 ---》4521 正数解算(最高位为 0,为正值): 0x11A9 解算为 4521 11A9H 4521D 如果是负数 最高位为 1,为负值): 0xE7B0 解算为 -6220 E7B0H (E7B0H - FFFFH)1 -62…...

Redis应用—9.简单应用汇总

大纲 1.基于Redis实现的简单缓存机制(String数据结构) 2.实现一个最简单的分布式锁(String数据结构) 3.博客网站的文章发布与查看(String数据结构) 4.博客字数统计与文章预览(String数据结构) 5.用户操作日志审计功能(String数据结构) 6.实现一个简单的唯一ID生成器(incr…...

powershell基础(1)

powershell基础(1) 1. 安装PowerShell 首先,确保你的计算机上已经安装了PowerShell。对于Windows 10及更高版本,PowerShell通常是默认安装的。你也可以从微软官网下载并安装最新版本的PowerShell Core。 2. 打开PowerShell 在Windows搜索栏中输入“P…...

【NLP 18、新词发现和TF·IDF】

目录 一、新词发现 1.新词发现的衡量标准 ① 内部稳固 ② 外部多变 2.示例 ① 初始化类 NewWordDetect ② 加载语料信息,并进行统计 ③ 统计指定长度的词频及其左右邻居字符词频 ④ 计算熵 ⑤ 计算左右熵 编辑 ⑥ 统计词长总数 ⑦ 计算互信息 ⑧ 计算每个词…...

C# 从控制台应用程序入门

总目录 前言 从创建并运行第一个控制台应用程序,快速入门C#。 一、新建一个控制台应用程序 控制台应用程序是C# 入门时,学习基础语法的最佳应用程序。 打开VS2022,选择【创建新项目】 搜索【控制台】,选择控制台应用(.NET Framew…...

怿星科技联合赛力斯举办workshop活动,进一步推动双方合作

12月18日,由怿星科技与赛力斯汽车联合举办的workshop活动在赛力斯五云湖总部展开,双方嘉宾围绕智能汽车发展趋势、行业前沿技术、汽车电子网络与功能测试等核心议题展开了深度对话与交流,并现场参观演示了多套前沿产品。怿星科技CEO潘凯、汽车…...

JVM和数据库面试知识点

JVM内存结构 主要有几部分:堆、栈、方法区和程序计数器 堆是JVM中最大的一块内存区域,用于存储对象实例,一般通过new创建的对象都存放在堆中。堆被所有的线程共享,但是它的访问时线程不安全的,通常通过锁的机制来保证线…...

批量提取zotero的论文构建知识库做问答的大模型(可选)——含转存PDF-分割统计PDF等

文章目录 提取zotero的PDF上传到AI平台保留文件名代码分成20个PDF视频讲解 提取zotero的PDF 右键查看目录 发现目录为 C:\Users\89735\Zotero\storage 写代码: 扫描路径‘C:\Users\89735\Zotero\storage’下面的所有PDF文件,全部复制一份汇总到"C:\Users\89735\Downl…...

Codeforces Round 993 (Div. 4)个人训练记录

Codeforces Round 993 (Div. 4) 只选择对我有价值的题目记录 E. Insane Problem 题目描述 给定五个整数 k k k, l 1 l_1 l1, r 1 r_1 r1, l 2 l_2 l2 和 r 2 r_2 r2,Wave 希望你帮助她计算满足以下所有条件的有序对 …...

AI-调查研究-01-正念冥想有用吗?对健康的影响及科学指南

点一下关注吧!!!非常感谢!!持续更新!!! 🚀 AI篇持续更新中!(长期更新) 目前2025年06月05日更新到: AI炼丹日志-28 - Aud…...

微信小程序之bind和catch

这两个呢,都是绑定事件用的,具体使用有些小区别。 官方文档: 事件冒泡处理不同 bind:绑定的事件会向上冒泡,即触发当前组件的事件后,还会继续触发父组件的相同事件。例如,有一个子视图绑定了b…...

DockerHub与私有镜像仓库在容器化中的应用与管理

哈喽,大家好,我是左手python! Docker Hub的应用与管理 Docker Hub的基本概念与使用方法 Docker Hub是Docker官方提供的一个公共镜像仓库,用户可以在其中找到各种操作系统、软件和应用的镜像。开发者可以通过Docker Hub轻松获取所…...

Nuxt.js 中的路由配置详解

Nuxt.js 通过其内置的路由系统简化了应用的路由配置,使得开发者可以轻松地管理页面导航和 URL 结构。路由配置主要涉及页面组件的组织、动态路由的设置以及路由元信息的配置。 自动路由生成 Nuxt.js 会根据 pages 目录下的文件结构自动生成路由配置。每个文件都会对…...

相机从app启动流程

一、流程框架图 二、具体流程分析 1、得到cameralist和对应的静态信息 目录如下: 重点代码分析: 启动相机前,先要通过getCameraIdList获取camera的个数以及id,然后可以通过getCameraCharacteristics获取对应id camera的capabilities(静态信息)进行一些openCamera前的…...

三体问题详解

从物理学角度,三体问题之所以不稳定,是因为三个天体在万有引力作用下相互作用,形成一个非线性耦合系统。我们可以从牛顿经典力学出发,列出具体的运动方程,并说明为何这个系统本质上是混沌的,无法得到一般解…...

Axios请求超时重发机制

Axios 超时重新请求实现方案 在 Axios 中实现超时重新请求可以通过以下几种方式: 1. 使用拦截器实现自动重试 import axios from axios;// 创建axios实例 const instance axios.create();// 设置超时时间 instance.defaults.timeout 5000;// 最大重试次数 cons…...

涂鸦T5AI手搓语音、emoji、otto机器人从入门到实战

“🤖手搓TuyaAI语音指令 😍秒变表情包大师,让萌系Otto机器人🔥玩出智能新花样!开整!” 🤖 Otto机器人 → 直接点明主体 手搓TuyaAI语音 → 强调 自主编程/自定义 语音控制(TuyaAI…...

uniapp中使用aixos 报错

问题: 在uniapp中使用aixos,运行后报如下错误: AxiosError: There is no suitable adapter to dispatch the request since : - adapter xhr is not supported by the environment - adapter http is not available in the build 解决方案&…...

听写流程自动化实践,轻量级教育辅助

随着智能教育工具的发展,越来越多的传统学习方式正在被数字化、自动化所优化。听写作为语文、英语等学科中重要的基础训练形式,也迎来了更高效的解决方案。 这是一款轻量但功能强大的听写辅助工具。它是基于本地词库与可选在线语音引擎构建,…...