【DeepSeek】在本地计算机上部署DeepSeek-R1大模型实战(完整版)

【作者主页】Francek Chen

【专栏介绍】 ⌈ ⌈ ⌈人工智能与大模型应用 ⌋ ⌋ ⌋ 人工智能(AI)通过算法模拟人类智能,利用机器学习、深度学习等技术驱动医疗、金融等领域的智能化。大模型是千亿参数的深度神经网络(如ChatGPT),经海量数据训练后能完成文本生成、图像创作等复杂任务,显著提升效率,但面临算力消耗、数据偏见等挑战。当前正加速与教育、科研融合,未来需平衡技术创新与伦理风险,推动可持续发展。

文章目录

- 前言

- 一、为什么需要本地部署大模型

- 二、DeepSeek R1简介

- DeepSeek-R1 Models

- DeepSeek-R1-Distill Models

- 三、在本地计算机部署DeepSeek R1

- (一)安装Ollama

- (二)下载DeepSeek R1

- (三)运行DeepSeek R1

- (四)安装Python

- (五)安装Microsoft Visual C++ Build Tools

- (六)使用Open WebUI增强交互体验

- (七)每次使用大模型的步骤

- (八)取消Ollama的开机自动启动

- 小结

前言

2025年1月,中国春节期间,DeepSeek爆火,称为全球最炙手可热的大模型。DeepSeek一路 “狂飙”,在美国科技界和美股市场掀起惊涛骇浪,1月27日,美国三大股指开盘即暴跌,英伟达、微软、谷歌母公司Alphabet、Meta等美国主要科技股均遭遇股市地震,其中英伟达跌近17%,单日市值蒸发约6000亿美元,创美股最高纪录。

这里以DeepSeek为例介绍在自己本地计算机上部署大模型的方法。操作过程中,遇到很多错误,借助于豆包大模型,把每个错误都解决了,顺利完成了安装过程。我的笔记本电脑是Windows10操作系统。实际上,只要电脑具有8GB内存和30GB可用磁盘空间即可安装最小版本的DeepSeek R1大模型。

特别强调,在自己本地计算机上部署DeepSeek R1大模型,不需要读者具备任何计算机基础知识,也不需要掌握任何编程知识,只要会使用Windows操作系统就可以,按照本文给出的步骤,一步步执行,就可以顺利完成所有操作。

一、为什么需要本地部署大模型

一般而言,DeepSeek、文心一言、豆包、Kimi等在线的大模型,功能非常强大,完全可以很好满足我们的需求。所以,大多数情况下,我们不需要在本地部署大模型。但是,当我们需要保护个人数据隐私时,也可以考虑在本地部署大模型。

和直接使用在线大模型(豆包、Kimi等)相比,在本地部署大模型具有以下优势:

- 数据隐私与安全性。第一,数据本地存储:所有数据运算和存储均在本地完成,不会上传至云端,有效避免了数据在传输和云端存储过程中可能带来的隐私泄露风险。第二,完全掌控数据:用户可以完全掌控数据的使用和存储,确保数据不被未经授权的访问或用于其他目的。第三,隐私保护机制:支持访问权限控制,进一步增强数据安全性。

- 定制化与灵活性。第一,自定义知识库训练:用户可以根据自己的需求对模型进行自定义知识库训练,进一步提升模型在特定领域的性能。第二,灵活调整模型参数:根据业务需求灵活调整模型参数和功能,满足不同场景下的个性化需求。第三,开源灵活性:开源模型一般都允许用户无限制地进行微调或将其集成到自己的项目中。

- 离线与高效使用。第一,离线访问:本地部署后,无需依赖网络连接,适合旅行或网络不稳定的场景,随时随地可用。第二,避免服务器繁忙:再也不用担心“服务器繁忙”的问题,提升使用体验。

- 成本与资源优化。第一,成本可控:长期使用比云服务更经济,尤其适合高频调用场景。第二,硬件友好:对硬件资源要求较低,可在较少GPU或高级CPU集群上运行,资源效率显著。

- 避免使用限制。本地部署避免了可能出现的使用限制,不受未来商业化影响,可永久免费使用。通过本地部署开源大模型,用户不仅能够享受强大的AI功能,还能在数据隐私、定制化需求和使用成本等方面获得显著优势。

二、DeepSeek R1简介

首先需要说明的是,大模型的训练过程需要耗费大量的计算资源(比如投入上亿元构建计算机集群去训练大模型),训练成本比较昂贵,个人是无法承担的。但是,训练得到的大模型,部署到计算机上,就不需要那么高的计算资源要求。但是,即使如此,在DeepSeek出现之前,很多市场上的大模型产品都是“贵族”模型,“段位”很高,通常需要依赖高端的硬件,配置大量的GPU,普通个人计算机一般很难运行大模型。2025年1月20日,我国杭州深度求索公司的DeepSeek R1大模型正式发布,它是一个基于深度学习的推荐系统模型,通常用于处理推荐任务,如商品推荐、内容推荐等。

Deepseek R1的发布,标志着大模型产品的“平民”时代已经到来,它大大降低了对计算机硬件的要求,可以部署在普通的个人计算机上,甚至部署在手机等便携式设备中。Deepseek采用了较为简洁高效的模型架构,去除了一些不必要的复杂结构和计算,在保证模型性能的基础上,降低了对计算资源的需求,使模型在本地计算机上运行更加轻松。通过先进的量化压缩技术,Deepseek将模型的参数进行压缩存储和计算,大大减少了模型所需的存储空间和计算量。2025年1月30日,微软公司宣布支持在Win11电脑本地运行DeepSeek R1大模型。

DeepSeek R1对硬件资源比较友好,对不同硬件配置有良好的适应性,能根据用户计算机硬件配置选择合适的模型版本。入门级设备拥有4GB 存和核显就能运行1.5B(Billion,十亿,大模型参数的数量)版本;进阶设备8GB内存搭配4GB显存就能驾驭7B版本;高性能设备则可选择32B版本。而且,DeepSeek R1支持低配置电脑,即使是没有独立显卡的低配置电脑,只要有足够的空余硬盘空间,如部署最大的6710亿参数的大模型需要至少1TB的空余空间,也能完成部署。

DeepSeek R1可以满足用户的数据隐私需求,本地部署能将所有数据运算都限制在本地,数据不会上传至云端,可有效避免数据传输和存储在云端可能带来的隐私泄露风险,满足用户对数据安全和隐私保护的要求。DeepSeek R1还可以满足定制需求,用户可以根据自己的需求对模型进行自定义知识库训练,进一步提升模型在特定领域的性能。

我们介绍了我们的第一代推理模型DeepSeek-R1-zero和DeepSeek-R1。DeepSeek-R1-Zero是一个通过大规模强化学习(RL)训练的模型,没有监督微调(SFT)作为初步步骤,在推理方面表现出卓越的性能。有了强化学习,DeepSeek-R1-Zero自然就出现了许多强大而有趣的推理行为。然而,DeepSeek-R1-Zero遇到了诸如无休止的重复、可读性差和语言混合等挑战。为了解决这些问题并进一步提高推理性能,引入了DeepSeek-R1,它在强化学习之前包含了冷启动数据。DeepSeek-R1在数学、代码和推理任务方面的性能可与OpenAI-o1媲美。为了支持研究社区,目前开源了DeepSeek-R1-Zero,DeepSeek-R1,以及基于Llama和Qwen的DeepSeek-R1提炼的六个密集模型。DeepSeek-R1-Distill-Qwen-32B在各种基准测试中优于OpenAI-o1-mini,为密集模型实现了新的最先进的结果。

DeepSeek以开源的特性和极低的成本,在数学、编程、自然语言推理等任务上表现出色,性能不亚于美国顶级AI模型。特别是DeepSeek-R1,通过创新性运用强化学习技术,以极少量标注数据实现了推理能力的跨越式提升。在数学、编程、语言理解等核心能力上,完美比肩OpenAI-o1。这一系列创新成果不仅得到了行业的广泛认可,也让世界看到了中国AI技术的崛起之势。

DeepSeek-R1 Models

| Model | #Total Params | #Activated Params | Context Length | Download |

|---|---|---|---|---|

| DeepSeek-R1-Zero | 671B | 37B | 128K | 🤗 HuggingFace |

| DeepSeek-R1 | 671B | 37B | 128K | 🤗 HuggingFace |

DeepSeek-R1- zero和DeepSeek-R1是基于DeepSeek-V3-Base训练的。关于模型架构的更多细节,请参考DeepSeek-V3存储库。

DeepSeek-R1-Distill Models

| Model | Base Model | Download |

|---|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | Qwen2.5-Math-1.5B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Qwen-7B | Qwen2.5-Math-7B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Llama-8B | Llama-3.1-8B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Qwen-14B | Qwen2.5-14B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Qwen-32B | Qwen2.5-32B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Llama-70B | Llama-3.3-70B-Instruct | 🤗 HuggingFace |

DeepSeek-R1-Distill模型基于开源模型进行微调,使用DeepSeek-R1生成的样本。稍微改变了它们的配置和标记器。

三、在本地计算机部署DeepSeek R1

本节将详细介绍如何通过Ollama和Open WebUI在本地计算机环境中部署DeepSeek R1大模型。本地计算机至少需要8GB内存和30GB剩余磁盘空间。

(一)安装Ollama

Ollama是一个开源的本地化大模型部署工具,旨在简化大型语言模型(LLM)的安装、运行和管理。它支持多种模型架构,并提供与OpenAI兼容的API接口,适合开发者和企业快速搭建私有化AI服务。

访问Ollama官网(https://ollama.com/), 点击“Download”(如图2所示),根据操作系统(Windows、macOS或Linux)下载自己操作系统对应的安装包(如图3所示),比如,Windows用户可以点击“Windows”图标,然后,点击“Download for Windows”下载安装包。需要注意的是,对于Windows系统,这里仅支持Windows10及其以上版本。

下载完成以后,双击安装包文件“OllamaSetup.exe”完成安装。安装完成后,在Windows系统中,输入快捷键Win + R,再在弹出的对话框中输入“cmd”并回车,打开cmd命令行工具窗口,输入以下命令验证是否安装成功:

ollama --version

如果显示Ollama版本号,说明安装成功(如图4所示)。

(二)下载DeepSeek R1

Ollama已经在第一时间支持DeepSeek R1,模型下载地址是https://ollama.com/library/deepseek-r1。 请根据自己的显存选择对应的模型,建议选择参数较少、体积最小的1.5B版本(如果计算机的配置较高,也可以选择参数较大的版本),这里的B是英文Billion(十亿),表示参数模型的参数规模,1.5B表示大模型的参数量是15亿。

当然,我们可以不用到这个下载地址手动下载,只需要在cmd命令行窗口中执行如下命令就可以自动下载DeepSeek R1大模型:

ollama run deepseek-r1:1.5b

该命令会自动下载并加载模型,下载时间取决于网络速度和模型大小。注意,如果在下载过程中,出现长时间停滞不动,可以敲击几次回车键。下载完成后,可以使用以下命令查看模型信息:

ollama list

该命令会列出本地已下载的模型及其状态。

(三)运行DeepSeek R1

可以在cmd命令行窗口中执行如下命令启动DeepSeek R1大模型:

ollama run deepseek-r1:1.5b

启动后,模型会进入交互模式,用户可以直接输入问题并获取回答。在交互模式下,可以测试DeepSeek R1的多种功能(如图6所示),例如:

- 智能客服:输入常见问题,如“如何学习人工智能?”。

- 内容创作:输入“请为我撰写一篇介绍沙县小吃的宣传文案”。

- 编程辅助:输入“用Python绘制一个柱状图”。

- 教育辅助:输入“解释牛顿第二定律”。

cmd窗口关闭以后,DeepSeek R1大模型就停止运行了。下次再次使用时,需要再次在cmd窗口中执行如下命令启动DeepSeek R1大模型:

ollama run deepseek-r1:1.5b

这种以命令行的方式与大模型进行对话,显然不太友好,因此,下面介绍如何通过浏览器来与大模型进行对话,这里就需要安装Open WebUI,由于Open WebUI依赖于Python环境,因此,在安装Open WebUI之前,需要首先安装Python环境(注意,只是需要安装Python环境,并不需要学习Python语言,读者可以完全不会Python语言,大模型的安装和使用过程完全不会用到Python语言)。如果读者没有使用浏览器与大模型对话的需求,可以不用学习下面的安装步骤。

(四)安装Python

Python(发音[ˈpaɪθən])是1989年由荷兰人吉多·范罗苏姆(Guido van Rossum)发明的一种面向对象的解释型高级编程语言。Python的第一个公开发行版于1991年发行,在2004年以后,Python的使用率呈线性增长,并获得“2021年TIOBE最佳年度语言”称号,这是Python第5次被评为“TIOBE最佳年度语言”,它也是获奖次数最多的编程语言。发展到今天,Python已经成为最受欢迎的程序设计语言之一。

Python可以用于多种平台,包括Windows、Linux和MacOS等。这里使用的Python版本是3.12.2(该版本于2024年2月6日发布),不要安装最新的3.13版本。请到Python官方网站下载(官网下载地址)与自己计算机操作系统匹配的安装包,比如,64位Windows操作系统可以下载python-3.12.2-amd64.exe。运行安装包开始安装,在安装过程中,要注意选中“Add python.exe to PATH”复选框,如图7所示,这样可以在安装过程中自动配置PATH环境变量,避免了手动配置的烦琐过程。

然后,点击“Customize installation”继续安装,在选择安装路径时,可以自定义安装路径,比如设置为“C:\python312”,并在“Advanced Options”下方选中“Install Python 3.12 for all users”(如图8所示)。

安装完成以后,需要检测是否安装成功。可以打开Windows操作系统的cmd命令界面,然后执行如下命令打开Python解释器:

cd C:\python312

python

如果出现图9所示信息,则说明Python已经安装成功。

(五)安装Microsoft Visual C++ Build Tools

备注:对于不同的计算机环境,本步骤可能不是必须的,读者可以先跳到第6步继续操作,如果在下面的第6步遇到报错信息说“缺少Microsoft Visual C++ Build Tools”,可以再回到本步骤安装Microsoft Visual C++ Build Tools,然后再执行第6步的安装。

在安装Open WebUI之前,在有些计算机上可能还需要安装Microsoft Visual C++ Build Tools,否则,安装Open WebUI过程会报错。可以到如下网址下载该工具安装包vs_BuildTools.exe:https://visualstudio.microsoft.com/zh-hans/visual-cpp-build-tools/

下载完成以后,双击安装包文件vs_BuildTools.exe进行安装,在弹出的安装界面中(如图10所示),在界面左上角的“桌面应用和移动应用”下方,选中“使用C++的桌面开发”,然后,点击界面右下角的“安装”按钮,完成安装。

(六)使用Open WebUI增强交互体验

只要是支持Ollama的WebUI都可以,如Dify、AnythingLLM等。这里使用比较简单而且也是与Ollama结合比较紧密的Open WebUI。

可以在cmd命令行窗口中执行如下命令安装Open WebUI(这里使用国内清华大学的安装源镜像,这样可以加快安装速度):

pip install open-webui -i https://pypi.tuna.tsinghua.edu.cn/simple

注意,如果在下载和安装过程中,出现长时间停滞不动,可以敲击几次回车键。

可以执行如下命令启动Open WebUI服务:

open-webui serve

注意,如果启动以后,看到下面界面(如图11所示),说明还没有启动成功,需要继续等待。可以敲击几次回车。

在继续等待过程中,可能屏幕上会出现一些错误信息,里面会包含如下内容:

requests.exceptions.ConnectTimeout: (MaxRetryError("HTTPSConnectionPool(host='huggingface.co', port=443)

这个错误信息说明,启动过程连接Hugging Face Hub失败。Hugging Face Hub网站在国外,所以,经常会连接失败,所以,导致open-webui启动过程始终停止不动。

直到出现下面屏幕信息以后(如图12所示),才说明启动成功了。

启动后,在浏览器中访问http://localhost:8080/即可进入Open WebUI界面。如果网页显示“拒绝连接”,无法访问Open WebUI界面,一般是由于你的计算机开启了Windows防火墙,可以点击“开始”菜单按钮,在弹出的界面中,在顶部的搜索框中输入“安全中心”(如图13所示),打开“Windows安全中心”,点击左侧的“防火墙和网络保护”,在右侧的“域网络”中,关闭防火墙。

Open WebUI支持中文界面,可以在设置中调整语言,默认是你的Windows系统当前正在使用的语言。首先,需要注册一个管理员账号(如图14所示),然后,就可以开始使用了。

在Open WebUI界面中,选择已下载的DeepSeek R1模型,即可开始对话测试。如图15所示,可以在对话框中输入“请介绍如何学习人工智能”然后回车,页面就会给出DeepSeek R1的回答结果(如图16所示)。

(七)每次使用大模型的步骤

当我们本次使用完大模型时,只需要关闭各个cmd命令行窗口,大模型就停止运行了。下次要再次使用时,还是按照一样的步骤进行操作:

1. 启动大模型

新建一个cmd命令行窗口,在cmd命令行窗口中执行如下命令启动DeepSeek R1大模型:

ollama run deepseek-r1:1.5b

2. 启动Open WebUI

再新建一个cmd命令行窗口,在cmd命令行窗口中执行如下命令启动Open WebUI服务:

open-webui serve

3. 在浏览器中访问大模型

在浏览器中访问http://localhost:8080/即可进入Open WebUI界面,开始使用大模型。

(八)取消Ollama的开机自动启动

前面步骤已经完成了DeepSeek R1大模型的部署,但是,你会发现,每次计算机关机以后,再次启动计算机时,Ollama会开机自动启动,导致占用计算机系统资源。当我们平时不使用DeepSeek R1时,为了让Ollama不占用计算机系统资源,我们需要禁止Ollama开机自动启动。

在Windows10系统中,输入快捷键Win + R,再在弹出的对话框中输入“msconfig”并回车,进入如图17所示系统设置界面,点击“启动”选项卡,在这个选项卡中点击“打开任务管理器”,进入如图18所示的任务管理器界面,在界面中,找到“ollama.exe”,把鼠标指针放到“已启动”上面,单击鼠标右键,在弹出的菜单中点击“禁用”,然后关闭任务管理器界面。经过这样设置以后,Ollama以后就不会开机自动启动了。

下次在使用DeepSeek时,仍然采用之前介绍的方法,在cmd命令行窗口中执行如下命令启动DeepSeek R1大模型:

ollama run deepseek-r1:1.5b

小结

本文详细介绍了如何在本地计算机上部署DeepSeek R1大模型,主要针对普通用户和开发者,提供了一个简便的安装流程,并强调了本地部署大模型的优势。首先,介绍了为什么需要本地部署大模型,包括数据隐私与安全、定制化与灵活性、离线使用、高效性、成本可控等多方面的优势。相比于在线大模型,本地部署能够有效保护用户的隐私数据,避免信息泄露,并允许用户根据实际需求对模型进行定制和调整,提升使用体验。

接着,介绍了DeepSeek R1大模型的基本概念及其发布背景。DeepSeek R1是一个具有高效、低资源消耗特性的推荐系统模型,其优化了对计算资源的要求,使得普通的个人计算机也能承载其运行。特别是DeepSeek R1支持不同硬件配置的设备,适配不同规模的用户需求。这一创新使得大规模AI模型的使用不再局限于高端硬件环境,普通用户也能在本地计算机上运行。

本文核心部分详细讲解了通过Ollama和Open WebUI等工具进行DeepSeek R1部署的步骤。从安装Ollama开始,用户只需按照简单的命令行操作,便能轻松完成模型的下载与运行。而对于更复杂的需求,如通过浏览器与模型进行互动,用户可以安装Python环境并结合Open WebUI实现更友好的操作界面。这一部分的讲解深入浅出,即便没有编程经验的用户也能轻松上手,按照步骤完成安装与配置。

此外,还提到一些可能遇到的问题及其解决方案,确保用户在遇到问题时能够找到对应的解决方法。例如,针对下载过程中可能的停滞,提供了按回车键的操作提示;对于启动失败的情况,也给出了详细的排查步骤。通过这些细致的提示,有效降低了用户操作的复杂度和失败率。

总结来说,本文为普通用户提供了一个清晰、易懂的指南,帮助他们在本地计算机上部署并运行DeepSeek R1大模型。它不仅展示了如何通过简单的工具和命令实现AI技术的本地化使用,也进一步说明了大模型应用的普及和便利性。通过这篇文章,用户可以充分理解并享受到本地部署大模型带来的数据安全、定制化、离线使用等多方面的优势,促进了AI技术的民主化。

欢迎 点赞👍 | 收藏⭐ | 评论✍ | 关注🤗

相关文章:

【DeepSeek】在本地计算机上部署DeepSeek-R1大模型实战(完整版)

【作者主页】Francek Chen 【专栏介绍】 ⌈ ⌈ ⌈人工智能与大模型应用 ⌋ ⌋ ⌋ 人工智能(AI)通过算法模拟人类智能,利用机器学习、深度学习等技术驱动医疗、金融等领域的智能化。大模型是千亿参数的深度神经网络(如ChatGPT&…...

996引擎-问题处理:三职业改单职业

996引擎-问题处理:三职业改单职业 问题解决方案顺便补充点单性别设置补充:可视化配置表参考资料问题 目前的版本: 引擎版本号:2024.8.7.0 三端配套客户端:3.40.9 传统PC客户端:23.12.07 配套数据库:64_24.8.7.0此版本需要通过可视化配置表...

Redis 发生宕机时,数据怎样恢复?

当 Redis 发生宕机时,数据恢复的核心依赖于其持久化机制和备份策略。以下是结合不同场景的恢复方法及原理: 一、通过持久化机制恢复数据 1. RDB(Redis Database)快照恢复 原理:RDB 通过生成内存数据的全量快照&#…...

)

【02】RUST项目(Cargo)

文章目录 rust项目与编译创建项目检查编译运行各级目录文件作用TODO各文件作用Cargo.tomlCargo.lockRUST项目一些关键字`mod``pub``use` (`as`)`pub use`重导出(re-exporting)`crate``suer`模块系统包 Pcakagescrate模块 Modules 和 usemain.rs的例子`lib.rs`的例子拆分文件为…...

二、通义灵码插件保姆级教学-IDEA(使用篇)

一、IntelliJ IDEA 中使用指南 1.1、代码解释 选择需要解释的代码 —> 右键 —> 通义灵码 —> 解释代码 解释代码很详细,感觉很强大有木有,关键还会生成流程图,对程序员理解业务非常有帮忙,基本能做到哪里不懂点哪里。…...

Docker使用指南与Dockerfile文件详解:从入门到实战

Docker使用指南与Dockerfile文件详解:从入门到实战 文章目录 **Docker使用指南与Dockerfile文件详解:从入门到实战****引言****第一部分:Docker 核心概念速览****1. Docker 基础架构****2. Docker 核心命令****第二部分:Dockerfile 文件深度解析****1. Dockerfile 是什么?…...

前端权限控制和管理

前端权限控制和管理 1.前言2.权限相关概念2.1权限的分类(1)后端权限(2)前端权限 2.2前端权限的意义 3.前端权限控制思路3.1菜单的权限控制3.2界面的权限控制3.3按钮的权限控制3.4接口的权限控制 4.实现步骤4.1菜单栏控制4.2界面的控制(1)路由导航守卫(2)动态路由 4.3按钮的控制…...

网络安全讲座之一:网络安全的重要性

第一讲内容主要对于安全的发展以及其重要性作了简明的阐述,并介绍了一些国内外知名的网络安全相关网站,并对于如何建立有效的安全策略给出了很好的建议,并让大家了解几种安全标准。 媒体经常报道一些有关网络安全威胁的令人震惊的事件&am…...

iOS主要知识点梳理回顾-3-运行时消息机制

运行时(runtime) 运行时是OC的重要特性,也是OC动态性的根本支撑。动态,如果利用好了,扩展性就很强。当然了,OC的动态性只能算是一个一般水平。与swift、java这种强类型校验的语言相比,OC动态性很…...

深度学习中的Checkpoint是什么?

诸神缄默不语-个人CSDN博文目录 文章目录 引言1. 什么是Checkpoint?2. 为什么需要Checkpoint?3. 如何使用Checkpoint?3.1 TensorFlow 中的 Checkpoint3.2 PyTorch 中的 Checkpoint3.3 transformers中的Checkpoint 4. 在 NLP 任务中的应用5. 总…...

STM32开发笔记,编译与烧录

1. Keil开发环境 【Project】》【Manager】》【Pack Installer】选择相应的芯片,Unpack安装。 2. 编译 3. 烧录 烧录时,Boot0 为 1,Boot1 为 0。烧录后启动,Boot0 为 0 ,Boot 1 为 0。 3.1 ST-LINK烧录 测试连接&a…...

【CXX-Qt】1 CXX-Qt入门

与其他Qt-Rust绑定相比,CXX-Qt的目标不仅仅是将Qt功能暴露给Rust,而是完全将Rust集成到Qt生态系统中。我们将通过一个最小示例,展示如何使用CXX-Qt在Rust中创建自己的QObject,并将其与基于QML的小型GUI集成。 一、阅读前准备知识…...

JS宏进阶:XMLHttpRequest对象

一、概述 XMLHttpRequest简称XHR,它是一个可以在JavaScript中使用的对象,用于在后台与服务器交换数据,实现页面的局部更新,而无需重新加载整个页面,也是Ajax(Asynchronous JavaScript and XML)…...

物联网智能语音控制灯光系统设计与实现

背景 随着物联网技术的蓬勃发展,智能家居逐渐成为现代生活的一部分。在众多智能家居应用中,智能灯光控制系统尤为重要。通过语音控制和自动调节灯光,用户可以更便捷地操作家中的照明设备,提高生活的舒适度与便利性。本文将介绍一…...

hyperf知识问题汇总

1、简单说下 hyperf(什么是 hyperf) 答:hyperf 是一个依赖swoole扩展的 php 开源开发框架,它由黄朝辉团队设计创建维护,具备简洁而强大的组件和超强的并发性能,而且还支持微服务架构,例如&…...

制药行业 BI 可视化数据分析方案

一、行业背景 随着医药行业数字化转型的深入,企业积累了海量的数据,包括销售数据、生产数据、研发数据、市场数据等。如何利用这些数据,挖掘其价值,为企业决策提供支持,成为医药企业面临的重大挑战。在当今竞争激烈的…...

【SVN基础】

软件:ToritoiseSVN 代码版本回退:回退到上一个版本 问题:SVN版本已经提交了版本1和版本2,现在发现不需要版本2的内容,需要回退到版本1然后继续开发。 如图SVN版本已经提交到了107版本,那么本地仓库也已经…...

多项式插值(数值计算方法)Matlab实现

多项式插值(数值计算方法)Matlab实现 一. 原理介绍二. 程序设计1. 构建矩阵2. 求解矩阵方程3. 作出多项式函数4. 绘制插值曲线5. 完整代码 三. 图例 一. 原理介绍 关于插值的定义及基本原理可以参照如下索引 插值原理(数值计算方法ÿ…...

[AI]Mac本地部署Deepseek R1模型 — — 保姆级教程

[AI]Mac本地部署DeepSeek R1模型 — — 保姆级教程 DeepSeek R1是中国AI初创公司深度求索(DeepSeek)推出大模型DeepSeek-R1。 作为一款开源模型,R1在数学、代码、自然语言推理等任务上的性能能够比肩OpenAI o1模型正式版,并采用MI…...

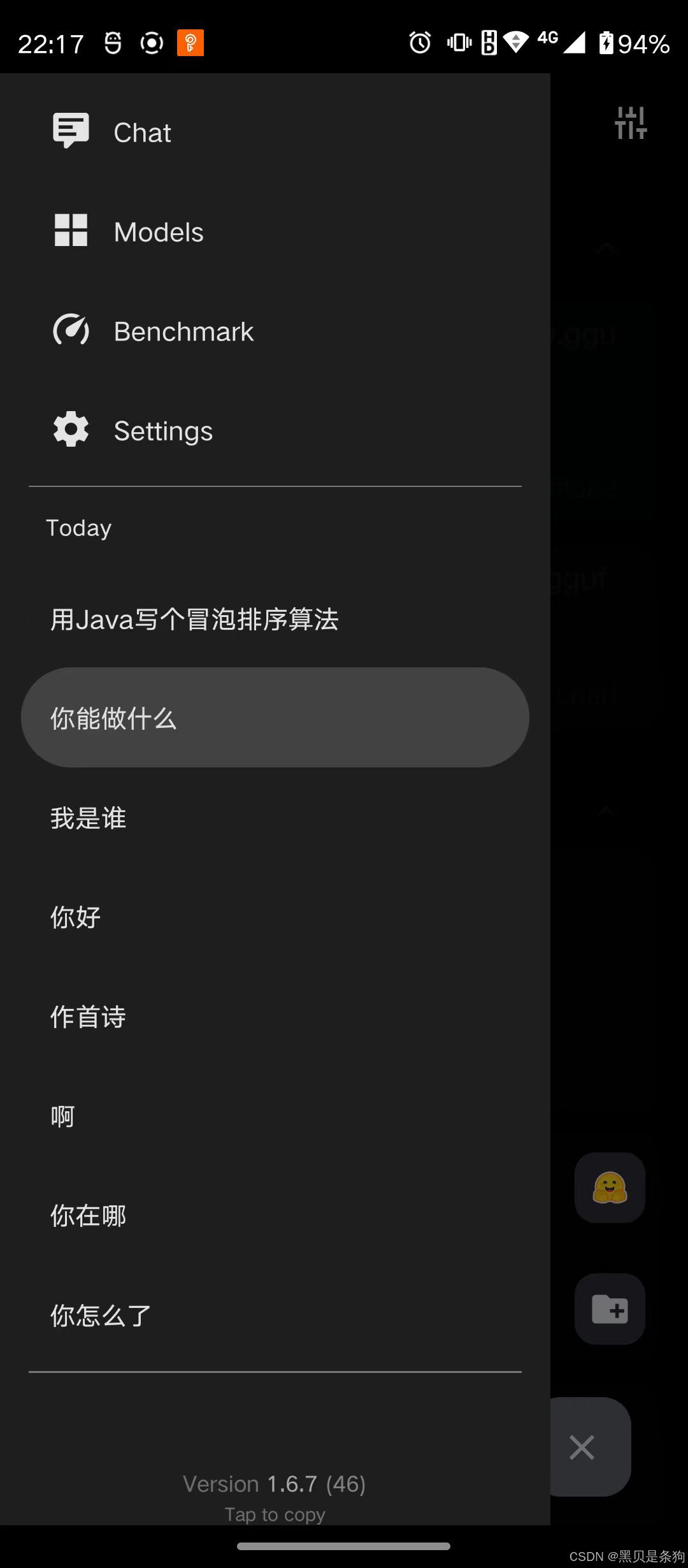

android手机本地部署deepseek1.5B

手机本地部署大模型需要一个开源软件 Release Release v1.6.7 a-ghorbani/pocketpal-ai GitHub 下载release版本apk 它也支持ios,并且是开源的,你可以编译修改它 安装完后是这样的 可以下载推荐的模型,也可以在pc上下载好,然后copy到手机里 点 + 号加载本地模型...

idea大量爆红问题解决

问题描述 在学习和工作中,idea是程序员不可缺少的一个工具,但是突然在有些时候就会出现大量爆红的问题,发现无法跳转,无论是关机重启或者是替换root都无法解决 就是如上所展示的问题,但是程序依然可以启动。 问题解决…...

Ubuntu系统下交叉编译openssl

一、参考资料 OpenSSL&&libcurl库的交叉编译 - hesetone - 博客园 二、准备工作 1. 编译环境 宿主机:Ubuntu 20.04.6 LTSHost:ARM32位交叉编译器:arm-linux-gnueabihf-gcc-11.1.0 2. 设置交叉编译工具链 在交叉编译之前&#x…...

【WiFi帧结构】

文章目录 帧结构MAC头部管理帧 帧结构 Wi-Fi的帧分为三部分组成:MAC头部frame bodyFCS,其中MAC是固定格式的,frame body是可变长度。 MAC头部有frame control,duration,address1,address2,addre…...

【力扣数据库知识手册笔记】索引

索引 索引的优缺点 优点1. 通过创建唯一性索引,可以保证数据库表中每一行数据的唯一性。2. 可以加快数据的检索速度(创建索引的主要原因)。3. 可以加速表和表之间的连接,实现数据的参考完整性。4. 可以在查询过程中,…...

多模态商品数据接口:融合图像、语音与文字的下一代商品详情体验

一、多模态商品数据接口的技术架构 (一)多模态数据融合引擎 跨模态语义对齐 通过Transformer架构实现图像、语音、文字的语义关联。例如,当用户上传一张“蓝色连衣裙”的图片时,接口可自动提取图像中的颜色(RGB值&…...

【算法训练营Day07】字符串part1

文章目录 反转字符串反转字符串II替换数字 反转字符串 题目链接:344. 反转字符串 双指针法,两个指针的元素直接调转即可 class Solution {public void reverseString(char[] s) {int head 0;int end s.length - 1;while(head < end) {char temp …...

【git】把本地更改提交远程新分支feature_g

创建并切换新分支 git checkout -b feature_g 添加并提交更改 git add . git commit -m “实现图片上传功能” 推送到远程 git push -u origin feature_g...

中关于正整数输入的校验规则)

Element Plus 表单(el-form)中关于正整数输入的校验规则

目录 1 单个正整数输入1.1 模板1.2 校验规则 2 两个正整数输入(联动)2.1 模板2.2 校验规则2.3 CSS 1 单个正整数输入 1.1 模板 <el-formref"formRef":model"formData":rules"formRules"label-width"150px"…...

中的KV缓存压缩与动态稀疏注意力机制设计)

大语言模型(LLM)中的KV缓存压缩与动态稀疏注意力机制设计

随着大语言模型(LLM)参数规模的增长,推理阶段的内存占用和计算复杂度成为核心挑战。传统注意力机制的计算复杂度随序列长度呈二次方增长,而KV缓存的内存消耗可能高达数十GB(例如Llama2-7B处理100K token时需50GB内存&a…...

FFmpeg:Windows系统小白安装及其使用

一、安装 1.访问官网 Download FFmpeg 2.点击版本目录 3.选择版本点击安装 注意这里选择的是【release buids】,注意左上角标题 例如我安装在目录 F:\FFmpeg 4.解压 5.添加环境变量 把你解压后的bin目录(即exe所在文件夹)加入系统变量…...