Python网络爬虫从入门到实战

目录

引言

一、网络爬虫的概念

二、 网络爬虫的基本工作流程

(一)过程:

(二)安装requests模块和beautifulsoup4模块

(三)requests库的使用

1、requests库的基本介绍

2、导入requests库的具体语法格式如下:

3、requests库网页请求方法

4、requests库的-Response对象

(四)beautifulsoup4库的使用

1、beautifulsoup4库的基本介绍

2、导入BeautifulSoup库的具体语法格式如下:

3、beautifulsoup4库的常用操作

4、元素中的文本信息往往是有用信息,下面将介绍用BeautifulSoup类解析HTML页面中的有用信息,分为: 节点选择器 方法选择器

4.1 节点选择器

4.2 方法选择器

三、实战:电影排行爬取及分析

1、获取网页

2、解析网页

3、存储数据

总结

引言

网络爬虫是自动从互联网上抓取信息的工具,其应用范围十分广泛,特别是在大数据分析、搜索引擎优化和信息采集等领域中具有重要作用。通过网络爬虫,我们能够快速获取大量网页数据,并利用数据分析工具对信息进行深入的解析与处理。这次实验旨在学习和实践如何使用Python中的requests和beautifulsoup4库,完成从网页获取数据、解析数据到存储数据的完整流程。

一、网络爬虫的概念

网络爬虫(Web Crawler)是按照一定的规则,自动地抓取万维网(World Wide Web,WWW)并获取信息的程序或脚本。在浏览器的网页中,除了供用户阅读的文字信息外,还包括一些超链接,网络爬虫可以通经过网页中的超链接不断地获得网络上的其它页面。网络数据采集的过程像爬虫在网络上漫游,因此得名为网络爬虫。

二、 网络爬虫的基本工作流程

简单的网络爬虫通常分为以下三个部分的内容:

数据采集:即获取网页中的数据;

数据处理:即进行网页解析;

数据存储:即将有用的信息持久化。

(一)过程:

- 设定抓取目标(初始URL)并获取页面。

- 不断地爬取页面,直到满足停止爬取的条件。

- 对于获取的页面,进行网页下载,获得网页中的数据。获得网页中的数据需要用到Python中的requests模块。

- 获取网页中的数据后,需要对此数据进行解析。进行网页解析需要用到Python中的beautifulsoup4模块。

- 对于网页解析出来的数据,可以对有用的信息进行存储。有用的信息,可以存储在文件中,也可以存储在数据库中,还可以进行可视化的展示。

(二)安装requests模块和beautifulsoup4模块

pip install requests

pip install beautifulsoup4

(三)requests库的使用

1、requests库的基本介绍

requests库的本质就是封装了urllib3模块,它可以模拟浏览器的请求,编写过程更接近正常URL的访问过程。requests库的宗旨是服务于人类(for human beings),具有以下功能特性:

- 支持URL数据自动编码;

- 支持HTTP连接保持和连接池;

- 支持使用Cookie保持会话;

- 支持文件分块上传;

- 支持自动确定相应内容的编码;

- 支持连接超时处理和流数据下载。

2、导入requests库的具体语法格式如下:

import requests

3、requests库网页请求方法

requests库中包含与HTTP协议的请求相对应的方法,即网页请求方法。

例如:

使用requests库中的get()方法访问网址http://www.mobiletrain.org

import requests

r = requests.get("http://www.mobiletrain.org")

print(type(r))

通过get()方法访问网址,返回了一个Response对象

<class 'requests.models.Response'>

4、requests库的-Response对象

Response对象代表的是响应内容,其属性如下表所示。

- import requests

- r = requests.get("http://www.mobiletrain.org")

- r.encoding = r.apparent_encoding # 自动检测编码

- content = r.content # 使用content属性获取二进制内容

- print(content.decode('utf-8').encode('gbk', 'ignore').decode('gbk')) # 先按utf-8解码,再按gbk编码打印

(四)beautifulsoup4库的使用

1、beautifulsoup4库的基本介绍

- 通过requests库获取HTML页面内容后,需要进一步解析HTML格式,提取其中的有用数据。beautifulsoup4库是一个可以解析HTML或者XML文件的Python库,它具有以下三个特点。

- beautifulsoup4库提供了用于浏览、搜索和修改解析树的简洁函数,可以通过解析文档为用户提供需要抓取的数据。

- beautifulsoup4库自动将输入文档稳定转换为Unicode编码,输出文档转换为utf-8编码。不需要考虑编码方式,除非文档没有指定编码方式,此时beautifulsoup4库不能自动识别编码方式,需要说明一下原始编码方式。

- beautifulsoup4库能够为用户灵活地提供不同的解析策略或者是较快的交易速度。

2、导入BeautifulSoup库的具体语法格式如下:

beautifulsoup4库中最主要的是BeautifulSoup类,一般通过导入此类来解析网页内容。

from bs4 import BeautifulSoup

3、beautifulsoup4库的常用操作

导入BeautifulSoup类后,可以创建BeautifulSoup对象。

- import requests from bs4

- import BeautifulSoup

- url = "http://www.mobiletrain.org"

- r = requests.get(url)

- r.encoding = "utf-8"

- soup = BeautifulSoup(r.text,"html.parser")

- print(type(soup))

<class 'bs4.BeautifulSoup'>

4、元素中的文本信息往往是有用信息,下面将介绍用BeautifulSoup类解析HTML页面中的有用信息,分为: 节点选择器 方法选择器

通过BeautifulSoup对象的属性可以选择节点元素,并获得节点的信息,这些属性与HTML的标签名称相同。

4.1 节点选择器

使用BeautifulSoup对象获得元素内容

- import requests from bs4

- import BeautifulSoup

- url = "http://www.mobiletrain.org"

- r = requests.get(url)

- r.encoding = "utf-8"

- soup = BeautifulSoup(r.text,"html.parser")

- print(soup.title) #获取页面的<title>内容

- print(soup.p) #获取页面的第一个<p>内容

<title>千锋教育-坚持教育初心,坚持面授品质,IT培训良心品牌</title>

<p class="bubble">小小千想和您聊一聊</p>

如果想要获得HTML标签中各个属性的内容,则需要通过Tag对象的属性去获取

使用BeautifulSoup对象获得标签的详细信息

- import requests from bs4

- import BeautifulSoup

- url = "http://www.mobiletrain.org"

- r = requests.get(url)

- r.encoding = "utf-8"

- soup = BeautifulSoup(r.text,"html.parser")

- print("<p>标签:",soup.p)

- print("<p>标签的名称:",soup.p.name)

- print("<p>标签的属性:",soup.p.attrs)

- print("<p>标签的子标签:",soup.p.contents)

- print("<p>标签包含的文本内容:",soup.p.string)

- <p>标签: <p class="bubble">小小千想和您聊一聊</p>

- <p>标签的名称: p

- <p>标签的属性: {'class': ['bubble']}

- <p>标签的子标签: ['小小千想和您聊一聊']

- <p>标签包含的文本内容: 小小千想和您聊一聊

string属性应遵循以下原则:

标签内部嵌套多层标签时,string属性返回None;

标签内部有一个标签时,string属性返回内层标签包含的文本内容;

标签内部没有标签时,string属性返回其包含的文本内容。

4.2 方法选择器

在HTML页面中,div、a、p等标签往往不止一个,节点选择器无法获得所有同名标签的内容,此时就要选择使用方法选择器。使用BeautifulSoup类中的方法可以获得HTML中的标签内容,主要的方法包括find()和find_all(),可以根据参数找到对应标签,返回列表类型。

BeautifulSoup.find(name,attrs,recursive,string) BeautifulSoup.find_all(name,attrs,recursive,string,limit)

find()和find_all()方法中的参数说明

find()和find_all()的区别在于find()方法仅返回找到的第一个结果,而find_all()可以返回找到的所有结果,也就是说,find()方法相当于参数limit为1时的find_all()方法。

例:使用find_all()方法获得所有的<i>

import requests from bs4

- import requests from bs4

- import BeautifulSoup

- url = "http://www.mobiletrain.org"

- r = requests.get(url)

- r.encoding = "utf-8"

- soup = BeautifulSoup(r.text, "html.parser")

- for item in soup.find_all("i"):

- print(item.string, end=" ")

三、实战:电影排行爬取及分析

1、获取网页

User-Agent(简称UA) 大量的爬虫请求会使服务器的压力过大,使得网页响应速度变慢,影响网站的政策运行,所以网站一般会检验UA来判断发起请求的是不是机器人。故需要自己设置UA进行简单伪装。

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 6.1; WOW64)

AppleWebKit/535.1 (KHTML, like Gecko) Chrome/14.0.835.163 Safari/535.1"}

需要将此键值对传入requests库中的get()方法,获取网页的函数可以写成如下形式。

def get_html(url,headers):

r = requests.get(url,headers=headers)

html = r.text

2、解析网页

定位文本内容所在标签

标签中的有用内容

3、存储数据

将解析网页后获得的有用数据列表转换为字典元素形式,并存入JSON格式的文件中。

movie.json

爬取具体步骤:

1、选择网站

2、解析网页

3、定位标签所在位置

4、提取文本数据

5、筛选数据

6、存储数据

总结

通过本次实验,深入理解了网络爬虫的基本原理和工作流程,掌握了使用Python编写爬虫的核心技术。实验过程中,我们学习了如何利用requests库获取网页内容,并通过beautifulsoup4库对HTML页面进行解析。此外,还学会了将爬取的数据进行存储,为后续的数据处理打下了坚实的基础。整个过程提升了我们在网络数据采集方面的实践能力,也为今后在大数据和信息处理领域的应用提供了宝贵经验。

相关文章:

Python网络爬虫从入门到实战

目录 引言 一、网络爬虫的概念 二、 网络爬虫的基本工作流程 (一)过程: (二)安装requests模块和beautifulsoup4模块 (三)requests库的使用 1、requests库的基本介绍 2、导入requests库的…...

探索Theine:Python中的AI缓存新贵

文章目录 探索Theine:Python中的AI缓存新贵背景:为何选择Theine?Theine是什么?如何安装Theine?简单的库函数使用方法场景应用场景一:Web应用缓存场景二:分布式系统中的数据共享场景三࿱…...

js拼图(神鹰黑手哥)

直接上代码 再解释 这是最终效果图 css代码如下 * {margin: 0;padding: 0;}body {height: 800px;width: 100%;background-color: blanchedalmond;display: flex;justify-content: space-around;align-items: center;position: relative;}.img-box {display: flex;flex-wrap: w…...

值得推荐的五款数据恢复工具!!

当谈及我们日常工作生活中无法避免的数据丢失情况时,很多小伙伴一定急得如热锅上的蚂蚁,无助与忐忑。特别是现在社会,信息量庞大,一旦电脑上的重要数据不慎丢失,无论是工作文件、生活照片还是珍贵的视频,都…...

股票金融市场中的tick,分钟,日线数据

在金融市场中,股票数据的分析对于投资者来说至关重要。股票数据可以根据时间粒度的不同,分为几种不同的类型,包括Tick数据、分钟数据和日线数据。下面将详细介绍这些数据类型,并对比它们之间的差别。 Tick数据 Tick数据…...

OKG Research:如何衡量链上数据的开放价值?

在新加坡Token2049期间,欧科云链研究院受邀参加Bloomberg主办的企业另类资产投资峰会2024,与多位专家围绕未来数据形态与前景进行了深入交流。 活动后,欧科云链研究院负责人Lola Wang与资深研究员Jason Jiang在大公网发表署名文章《如何衡量…...

向日葵下载教程以及三款远程控制工具推荐!!!

向日葵远程控制下载教程!! 亲爱的朋友们,如果你对远程控制软件有所需求,那么向日葵绝对是一个不错的选择。现在我将带你走一遍向日葵的下载流程。 1. 打开你的浏览器,输入“向日葵官方网站”,进入官方网站…...

Studio One 6中文版及最新功能介绍 Studio One 6音乐软件安装包

Studio One 6是一款功能强大的数字音频工作站(DAW),专为音乐制作和录音而设计。它提供了从初学者到专业人士的所有需求,无论是创作、录音、混音还是母带处理。 Studio One 6拥有直观的界面和强大的虚拟乐器、插件和音频处理工具&a…...

【数据结构】栈和队列 + 经典算法题

目录 前言 一、栈 二、栈的实现 三、栈的循环遍历演示 四、栈的算法题 // 一、队列 二、队列的实现 三、使用演示 四、队列的算法题 总结 前言 本文完整实现了栈和队列的数据结构,以及栈和队列的一些经典算法题,让我们更加清楚了解这两种数据…...

C# 基于winform 使用NI-VISA USB口远程控制电源 万用表

1.下载完整版本NI-VISA NI-VISA Download - NI *注意支持的操作系统,以便后期编译 安装完成之后,打开NI MAX,插上usb口,打开测试面板进行通信 2.编程示例 见本地文件夹C:\Users\Public\Documents\National Instruments\NI-VIS…...

Python设计方差分析实验

前言 方差分析(ANOVA)是一种用于检测多个样本均值之间差异的统计方法,广泛应用于实验设计与数据分析中。通过分析不同因素对实验结果的影响,方差分析能够帮助评估哪些因素显著影响了实验结果,并且可以提供各因素交互作用的深入理解。在多因子实验设计中,随机化、重复和平…...

【Oracle DB故障分享】分享一次由于SGA设置太小导致的DP备份失败

List item 今天给客户做Oracle例行数据库健康巡检,过程中检出一些备份异常,分享如下。 排查问题: 打开DP备份软件,随即弹出如下提示: 登录DP,查看备份情况:发现从10/6开始,DP备份…...

Yocto构建教程:在SDK中添加Qt5并生成带有Qt5的SDK

下载meta-qt5 复位环境 确认下版本是否匹配 添加meta-qt5进bblayers.bb 先编译起来 研究meta-qt5 构建带有Qt5的toolchain SDK meta-toolchain如何编译带Qt5的软件包? 文件系统中如何添加Qt5软件包 如何同时编译目标镜像和SDK Yocto Project是一个开源的嵌…...

操作系统——位示图

这里写目录标题 前言基础说明相关计算题目一题目二题目三 前言 基础说明 位示图是一种用来表示文件和目录在磁盘上存储位置的图形化表示方法。它通过使用一系列的位来表示文件或目录所占用的磁盘块,从而显示出磁盘上的存储情况。 位示图通常是一个位向量…...

【STM32 Blue Pill编程实例】-矩阵键盘

矩阵键盘 文章目录 矩阵键盘1、矩阵键盘介绍2、硬件准备与接线3、模块配置3.1 矩阵键盘列引脚配置3.2 矩阵键盘列引脚配置3.3 LED配置4、代码实现在本文中,我们将介绍如何把 43 键盘与 STM32 Blue Pill 连接,并使用 HAL 库在 STM32CubeIDE 中对其进行编程。 键盘是一种输入设…...

基于SSM的药品商城系统

作者:计算机学姐 开发技术:SpringBoot、SSM、Vue、MySQL、JSP、ElementUI、Python、小程序等,“文末源码”。 专栏推荐:前后端分离项目源码、SpringBoot项目源码、Vue项目源码、SSM项目源码、微信小程序源码 精品专栏:…...

南京邮电大学电工电子A实验十一(数据选择器及逻辑电路的动态测试)

文章目录 一、实验报告预览二、Word版本报告下载 一、实验报告预览 二、Word版本报告下载 点我...

算法.图论-BFS及其拓展

文章目录 广度优先搜索简介经典bfs习题地图分析贴纸拼词 01bfs解析基本过程相关习题 广度优先搜索简介 bfs的特点是逐层扩散, 从源头到目标点扩散了几层, 最短路就是多少 bfs的使用特征是任意两个节点的距离(权值)是相同的(无向图, 矩阵天然满足这一特点) bfs开始的时候可以是…...

mongodb的相关关键字说明

以下是MongoDB中一些数据库相关的关键字说明: 1. 数据库(Database) 概念 数据库是MongoDB中数据存储的最高层级容器,类似于关系型数据库中的数据库概念。一个MongoDB服务器实例可以包含多个数据库,每个数据库可以有自…...

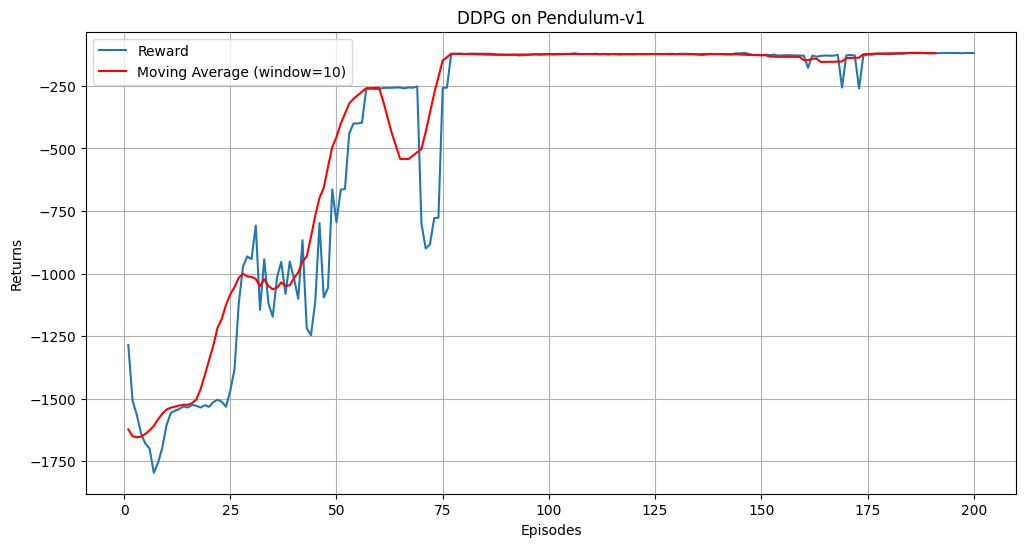

强化学习之DDPG算法

前言: 在正文开始之前,首先给大家介绍一个不错的人工智能学习教程:https://www.captainbed.cn/bbs。其中包含了机器学习、深度学习、强化学习等系列教程,感兴趣的读者可以自行查阅。 一、算法介绍 深度确定性策略梯度 ࿰…...

龙虎榜——20250610

上证指数放量收阴线,个股多数下跌,盘中受消息影响大幅波动。 深证指数放量收阴线形成顶分型,指数短线有调整的需求,大概需要一两天。 2025年6月10日龙虎榜行业方向分析 1. 金融科技 代表标的:御银股份、雄帝科技 驱动…...

Debian系统简介

目录 Debian系统介绍 Debian版本介绍 Debian软件源介绍 软件包管理工具dpkg dpkg核心指令详解 安装软件包 卸载软件包 查询软件包状态 验证软件包完整性 手动处理依赖关系 dpkg vs apt Debian系统介绍 Debian 和 Ubuntu 都是基于 Debian内核 的 Linux 发行版ÿ…...

线程同步:确保多线程程序的安全与高效!

全文目录: 开篇语前序前言第一部分:线程同步的概念与问题1.1 线程同步的概念1.2 线程同步的问题1.3 线程同步的解决方案 第二部分:synchronized关键字的使用2.1 使用 synchronized修饰方法2.2 使用 synchronized修饰代码块 第三部分ÿ…...

Python爬虫(一):爬虫伪装

一、网站防爬机制概述 在当今互联网环境中,具有一定规模或盈利性质的网站几乎都实施了各种防爬措施。这些措施主要分为两大类: 身份验证机制:直接将未经授权的爬虫阻挡在外反爬技术体系:通过各种技术手段增加爬虫获取数据的难度…...

解决本地部署 SmolVLM2 大语言模型运行 flash-attn 报错

出现的问题 安装 flash-attn 会一直卡在 build 那一步或者运行报错 解决办法 是因为你安装的 flash-attn 版本没有对应上,所以报错,到 https://github.com/Dao-AILab/flash-attention/releases 下载对应版本,cu、torch、cp 的版本一定要对…...

蓝桥杯3498 01串的熵

问题描述 对于一个长度为 23333333的 01 串, 如果其信息熵为 11625907.5798, 且 0 出现次数比 1 少, 那么这个 01 串中 0 出现了多少次? #include<iostream> #include<cmath> using namespace std;int n 23333333;int main() {//枚举 0 出现的次数//因…...

Git常用命令完全指南:从入门到精通

Git常用命令完全指南:从入门到精通 一、基础配置命令 1. 用户信息配置 # 设置全局用户名 git config --global user.name "你的名字"# 设置全局邮箱 git config --global user.email "你的邮箱example.com"# 查看所有配置 git config --list…...

)

【LeetCode】3309. 连接二进制表示可形成的最大数值(递归|回溯|位运算)

LeetCode 3309. 连接二进制表示可形成的最大数值(中等) 题目描述解题思路Java代码 题目描述 题目链接:LeetCode 3309. 连接二进制表示可形成的最大数值(中等) 给你一个长度为 3 的整数数组 nums。 现以某种顺序 连接…...

前端中slice和splic的区别

1. slice slice 用于从数组中提取一部分元素,返回一个新的数组。 特点: 不修改原数组:slice 不会改变原数组,而是返回一个新的数组。提取数组的部分:slice 会根据指定的开始索引和结束索引提取数组的一部分。不包含…...

微服务通信安全:深入解析mTLS的原理与实践

🔥「炎码工坊」技术弹药已装填! 点击关注 → 解锁工业级干货【工具实测|项目避坑|源码燃烧指南】 一、引言:微服务时代的通信安全挑战 随着云原生和微服务架构的普及,服务间的通信安全成为系统设计的核心议题。传统的单体架构中&…...